Pl@ntNet, un réseau et des outils pour une recherche participative

Cet article met à jour la première version publiée en mars 2014.

Spécialistes et amateurs de botanique se connectent dans un réseau collaboratif organisé autour d’une plateforme logicielle, auquel un consortium de structures de recherche en Informatique, Agronomie et Gestion des ressources naturelles apporte son expertise. Les communautés ainsi constituées autour de projets communs contribuent à l’accumulation de nouvelles données sur la biodiversité végétale et à la promotion de la science citoyenne.

Démonstration vidéo réalisée par Pierre-Olivier Gaumin.

Visionner la vidéo – Durée : 07 min 09 s.

Le verrou taxonomique

Donner un nom correct à chacune des plantes rencontrées dans la nature n’est pas une chose facile, ceci même parfois pour des spécialistes. Une personne, même botaniste, peut connaître un grand nombre de plantes relatives à une région, un groupe taxonomique, un usage, etc., mais rares sont celles qui sur un territoire aussi vaste que la France métropolitaine ou un territoire français d’outre-mer sont capables de nommer toutes les espèces d’une flore donnée. L’identification taxonomique constitue donc l’un des verrous majeurs pour l’agrégation et le partage d’observations de terrain.

C’est pourquoi le consortium Pl@ntNet [1] s’est attaché à développer de nouvelles technologies, afin de surpasser ce verrou et ainsi favoriser le partage d’information botanique. En se basant sur des données photographiques réelles, partagées à travers le réseau Tela Botanica, réseau des botanistes francophones, Pl@ntNet a développé des méthodes originales de recherche et d’analyse de données visuelles à grande échelle. Ce travail a été mené conjointement au travers d’une méthode itérative impliquant doctorants, chercheurs, développeurs, photographes, animateurs, naturalistes amateurs ou professionnels.

Les jeux de données photographiques mobilisés pour faire progresser les méthodes réalisées n’ont ainsi cessé de croître en fonction des contributions des participants, et des capacités de traitement mises en œuvre. C’est notamment en réunissant différentes équipes de recherche en informatique au sein du forum international CLEF [2] que plusieurs approches ont pu être développées, évaluées et mises en œuvre pour répondre à ces problèmes complexes.

Approches algorithmiques déployées

Les algorithmes mis en œuvre sont issus des recherches en analyse et en gestion de données visuelles. Ils sont intégrés dans le moteur de recherche visuel Snoop développé conjointement par l’équipe-projet Inria ZENITH et l’institut national de l’audiovisuel (INA) et adapté au contexte botanique dans le cadre du projet Pl@ntNet.

Chaque image de la base de données est représentée par un certain nombre d’attributs visuels qui permettent de distinguer une espèce d’une autre. Afin de sélectionner les attributs les plus discriminants, ceux-ci sont appris par des techniques d’intelligence artificielle appelées réseaux de neurones convolutionnels. Ils peuvent caractériser aussi bien des traits assez généraux comme la couleur de la fleur ou la forme générale de la feuille, que des détails subtils comme la forme de la pointe des pétales de la fleur ou la présence d’une légère pilosité sur la marge des feuilles.

Toutes ces descriptions sont intégrées dans de grands index visuels. Ces index, lorsqu’ils sont interrogés avec des images d’une plante inconnue, sont capables de renvoyer très rapidement les images de la base de données partageant le plus grand nombre d’attributs visuels similaires. Cela permet d’illustrer les espèces reconnues par le système avec les images de la base qui ressemblent le plus à la plante observée. Charge alors à l’utilisateur de prendre la décision finale en comparant finement ces illustrations avec le spécimen devant lui.

Les six années de campagnes d’évaluation de LifeCLEF [2] ont permis de constater que les performances d’identification sont parmi les meilleures par rapport aux autres méthodes proposées par des équipes de recherche dans le monde entier travaillant dans le même domaine.

Ces performances ne sont cependant pas encore transposables à une base de données qui contiendrait l’ensemble de la flore mondiale (environ 300 000 espèces, contre une dizaine de milliers dans l’application actuelle). Si les questions algorithmiques et de mesures de performances brutes sont cruciales pour proposer à un large public un outil d’aide à l’identification des plantes, la question de l’enrichissement d’une base d’images l’est certainement tout autant. Il y a en effet un manque encore très important de données, pour beaucoup d’espèces, pour beaucoup de types d’organes, dans la base de données utilisée, mais aussi plus largement parmi les images accessibles sur le web.

Algorithmes et enrichissement de cette base de données sont deux aspects interdépendants qui doivent avancer en parallèle, ce qui constitue l’une des plus grandes originalités de la méthode utilisée par Pl@ntNet.

Vers l’implication des citoyens

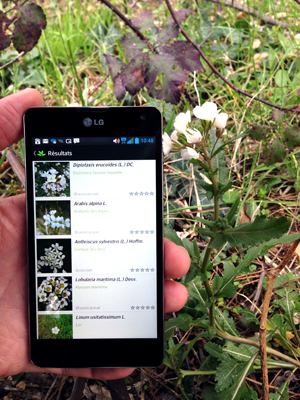

Ce travail, démarré fin 2009, a abouti en février 2013, au cours du 50e Salon International de l’Agriculture, au lancement de l’application mobile d’aide à l’identification par l’image PlantNet-mobile. L’application réalisée permet de prendre avec son smartphone des photos d’une plante recherchée et de comparer ces photos à celle d’une base d’images expertisée et dynamiquement mise à jour. Le résultat proposé est évolutif, puisque la base s’enrichit de jour en jour de nouvelles images et de nouvelles espèces grâce aux contributions des membres du réseau. Disponible initialement pour iPhone, l’application est désormais accessible aussi sur Android.

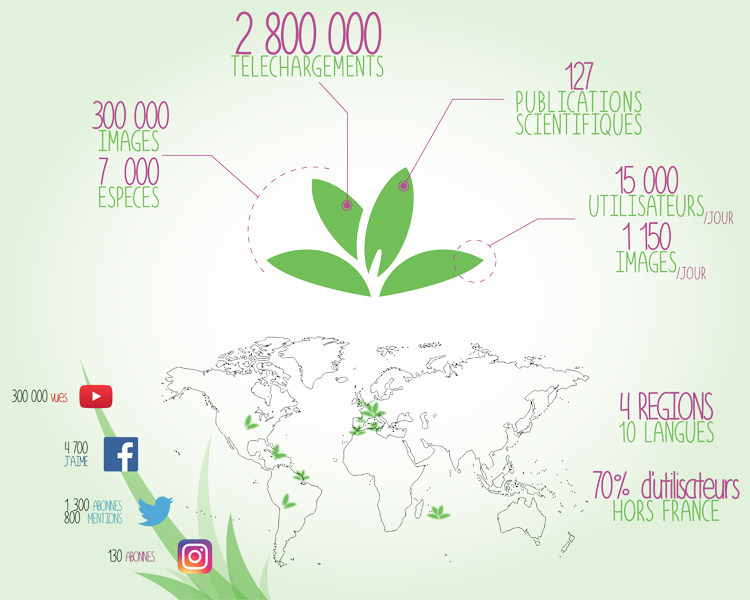

Les images et leurs annotations sont révisées collaborativement, ainsi seules celles de qualité suffisante et dont la détermination est validée sont exploitées par l’application. À ce jour, la base de données contient près de 300 000 images pour 10 000 espèces, dans quatre régions du monde, l’Europe de l’Ouest, l’Afrique du Nord, l’Océan Indien (Réunion, Maurice) et l’Amérique du Sud (Guyane), ce qui constitue une base de connaissance multimédia sans précédent.

Les utilisateurs de l’application mobile peuvent la parcourir directement sur le terrain et accéder pour chaque espèce à des informations complémentaires issues d’ eFlore ou de Wikipedia. Ils peuvent également suivre le flux des contributions au jour le jour et participer eux-mêmes à l’aventure en partageant leurs observations. Enfin, fonctionnalité clé de l’application, ils peuvent effectuer une recherche par similarité visuelle. Après avoir photographié une plante avec leur smartphone selon 4 motifs visuels complémentaires (feuille, fleur, fruit, tige/écorce), ils naviguent dans les espèces similaires retournées pour identifier la plante observée.

Avec près de trois millions de téléchargements en trois an et plusieurs centaines de milliers d’utilisateurs réguliers, PlantNet-mobile démontre un vif intérêt du public pour ce type de technologie et une soif de connaissance au sujet des plantes. On peut espérer qu’à plus long terme, le réseau d’observateurs s’agrandisse encore et se transforme en un véritable outil citoyen de surveillance écologique, offrant des possibilités d’analyse inédites pour les scientifiques et les responsables du territoire. Plus globalement, on commence à comprendre que les enjeux du nomadisme numérique vont bien au-delà du simple fait d’embarquer des outils informatiques dans des appareils mobiles. Ces applications contribuent à l’accès universel à la connaissance, en rendant le monde qui nous entoure interrogeable même par ceux qui n’ont pas de bagage scientifique spécifique au préalable.

Données mises à jour en novembre 2016

Infographie : Rémi Knaff.

L’application Pl@ntnet est accessible sur iPhone ou Android.

Références scientifiques

[1] Joly, A., Bonnet, P., Goëau, H., Barbe, J., Selmi, S., Champ, J., … & Boujemaa, N. (2015). A look inside the Pl@ ntNet experience. Multimedia Systems, 1-16.

Alexis Joly, Hervé Goëau, Julien Champ, Samuel Dufour-Kowalski, Henning Müller, and Pierre Bonnet. 2016. Crowdsourcing Biodiversity Monitoring: How Sharing your Photo Stream can Sustain our Planet. In Proceedings of the 2016 ACM on Multimedia Conference (MM ’16).

[2]Joly, A., Goëau, H., Glotin, H., Spampinato, C., Bonnet, P., Vellinga, W. P., … & Müller, H. (2015, September). LifeCLEF 2015: multimedia life species identification challenges. In International Conference of the Cross-Language Evaluation Forum for European Languages (pp. 462-483). Springer International Publishing.

Newsletter

Le responsable de ce traitement est Inria. En saisissant votre adresse mail, vous consentez à recevoir chaque mois une sélection d'articles et à ce que vos données soient collectées et stockées comme décrit dans notre politique de confidentialité

Niveau de lecture

Aidez-nous à évaluer le niveau de lecture de ce document.

Votre choix a été pris en compte. Merci d'avoir estimé le niveau de ce document !