Le Web de données

Entretien réalisé par Joanna Jongwane.

Qu’entend-on exactement par « donnée » à l’heure du Web ? Tout n’est-il pas de l’ordre de la « donnée » ?

Catherine Faron Zucker : On parle de Web de données par opposition à ce qu’était le Web à l’origine : un Web documentaire, c’est-à-dire un ensemble de documents interconnectés et accessibles par Internet, à destination des utilisateurs humains qui allaient naviguer d’un document à l’autre pour en traiter eux-mêmes le contenu informatif.

Actuellement, le Web contient non seulement des documents, à destination d’agents humains, mais aussi des données, à destination d’agents logiciels (les machines). Certaines données décrivent les documents du Web (on parle alors de métadonnées) tandis que d’autres sont indépendantes de tout document du Web.

Le premier principe du Web de données est de reposer sur un standard du Web appelé « identifiant uniforme de ressource » (URI, de l’anglais Uniform Resource Identifier). Servant à identifier tout ce que l’on veut décrire sur le Web, ce standard est une extension du standard URL qui permet d’identifier les pages du Web uniquement. Ainsi, tout ce qui est identifié par un URI est une ressource du Web, accessible sur le Web, et qui peut être décrite. Cela englobe les documents du Web (identifiés par leur URL) mais aussi toutes les autres choses, matérielles ou abstraites, dont on parle sur le Web, par exemple une table, une voiture, une plante, un humain, une organisation, ou encore une idée, un concept abstrait, comme l’amour par exemple.

De plus, le W3C, l’organisme de standardisation du Web, a conçu un standard pour décrire des ressources : RDF, Resource Description Framework. En résumé, il s’agit d’un langage spécifique pour décrire les données du web. Ce standard RDF est un modèle de représentation à base de graphe qui permet de construire un graphe géant de connaissances avec des données liées, c’est-à-dire des URI décrits et interconnectés. On parle alors de Web de données liées, ou Linked Data en anglais.

Quelles sont ces données liées ou Linked Data ?

CFZ : Le principe même du modèle RDF est un principe de représentation sous forme de graphe. On a donc un graphe de connaissances qui décrit un objet identifié par un URI. Dans ce graphe de connaissances, on peut faire appel à d’autres URI qui participent à la description d’un certain objet. Par exemple, imaginons que je vous décrive en train de m’interviewer. Vous êtes identifiée par un URI. Dans votre description, il y a un autre URI qui m’identifie comme la personne interviewée et de proche en proche, d’une description d’une personne à une autre, ou d’un objet à un autre, on construit un graphe global géant de données RDF utilisant des URI qui se retrouvent ainsi liées.

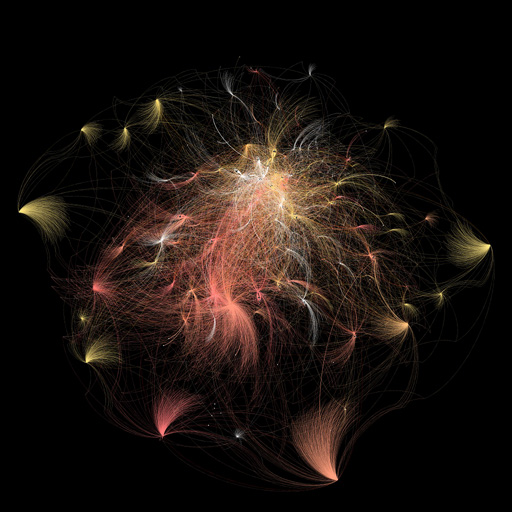

Graphe de données extraites de DBpedia avec le moteur de recherche exploratoire Discovery hub.

© Inria / WIMMICS.

Ces données formalisées en RDF peuvent être manipulées non plus par des humains mais par des agents logiciels, c’est-à-dire des programmes qui vont les traiter, raisonner sur elles. Notamment, elles peuvent être interrogées avec un langage standard spécifique également conçu par le W3C : SPARQL, une sorte de langage d’interrogation (SQL) pour des données RDF.

Web sémantique, Web de données… Quelles différences entre les deux ?

CFZ : Une manière de présenter les choses est de dire que le Web de données liées est la première phase de déploiement du Web sémantique. Sur le Web de données, on publie des données selon un formalisme de représentation standardisé, RDF, on construit ainsi un graphe mondial de données, et on l’interroge avec un langage standardisé, SPARQL.

La clé du liage des données du Web, ce qui permet d’éviter d’avoir des silos de données, c’est-à-dire des sous-graphes RDF non connectés, c’est l’utilisation de vocabulaires communs partagés pour décrire les données. Ces vocabulaires sont souvent le résultat de travaux au sein de différentes communautés spécifiques et décrivent un domaine ou sous-domaine particulier, par exemple le Dublin Core pour décrire les métadonnées associées à des documents : titre, auteur, éditeur, année de publication, etc., ou encore le vocabulaire FOAF (Friend of a friend, littéralement « l’ami d’un ami ») pour décrire les relations sociales entre les personnes : ami, collègue, parent, etc. Il existe également des vocabulaires très spécialisés comme par exemple TAXREF pour décrire toutes les espèces végétales et animales en France.

Il existe trois standards du W3C pour décrire des vocabulaires : RDFS, OWL et SKOS.

- RDFS sert à décrire des vocabulaires simples : il permet de déclarer des types de ressources, c’est-à-dire des classes, comme les classes « personne » ou « document », et des types de relations entre les ressources, par exemple la relation d’auteur entre une personne et un document ;

- OWL quant à lui est plus expressif : il permet notamment de définir des classes par des conditions nécessaires et suffisantes pour appartenir à une classe. On peut par exemple définir la classe des femmes comme l’ensemble des individus appartenant à la classe des humains et qui sont de sexe féminin. Il permet également d’être plus expressif dans la définition du domaine ou codomaine d’une relation. On peut par exemple préciser que la propriété d’avoir un compte bancaire s’applique à une personne physique ou une société ou une association ;

- enfin SKOS s’intéresse à la partie terminologique des vocabulaires : il permet d’associer différents types de labels aux classes et aux propriétés. En utilisant ce standard, on peut notamment associer à un même concept différents labels alternatifs, identifier un label préféré, associer également des labels cachés pour par exemple permettre la détection automatique de concepts dans un texte même en cas de faute orthographique. On pourrait par exemple définir le concept de femme, avec « femme » comme label préféré et « conjointe », « égérie », « épouse », « femelle », « muse », etc. comme labels alternatifs et « feme » et « fame » comme labels cachés.

C’est l’utilisation de ces langages pour publier des vocabulaires qui permet de construire un Web de données liées qui utilisent dans la description de ces données des vocabulaires communs.

Lorsqu’on exploite ces vocabulaires pour raisonner, on parle de Web sémantique. Ces vocabulaires sont alors vus comme des ontologies, qui modélisent une partie du monde, par exemple, lorsqu’on exploite le fait que « femme » et « homme » soient déclarés comme des sous-types de « personne » pour rechercher tous les documents écrits par des personnes, certains ayant été déclarés comme ayant été écrits par un homme, d’autres comme ayant été écrits par une femme. Ou lorsqu’on exploite le fait que « film », « roman », « nouvelle », « pièce de théâtre » sont des sous-types de « œuvre », pour retrouver en une seule requête toutes les œuvres (de différents types) d’un auteur.

Dans l’équipe WIMMICS, vous cherchez à donner du sens aux données… Quels sont les objectifs et les enjeux de vos travaux ?

CFZ : De manière générale, les travaux de notre équipe visent à soutenir les communautés épistémiques sur le Web, qu’il s’agisse d’organisations, d’entreprises, voire de groupes de personnes quelconques partageant un domaine d’intérêt commun. Nous développons des solutions informatiques pour aider les membres d’une communauté à gérer leurs connaissances et leurs interactions.

Soutenir une communauté, cela commence par expliciter les connaissances de la communauté, par exemple en construisant des ontologies à partir des connaissances des experts d’un domaine, qu’il s’agit d’expliciter à travers des interviews, ou en exploitant des tags, des mots-clés qu’associent des personnes à des documents de la communauté, ou encore en extrayant des connaissances à partir de documents textuels.

Une question connexe est l’annotation sémantique des ressources documentaires d’une communauté par des descriptions formelles (formalisées en RDF) permettant de raisonner sur ces documents, pour mieux les organiser, mieux les retrouver. Plus généralement, il est intéressant de décrire toutes les ressources de la communauté pour augmenter les possibilités de raisonnement : non seulement les documents, mais aussi les personnes, les processus, les pratiques.

Un autre type de problématiques est l’intégration de données hétérogènes, issues de communautés différentes, dans le but de raisonner en les combinant. Cela nécessite de reconnaître que deux ressources désignent un même objet, que deux classes dans deux vocabulaires différents sont équivalentes, et de tenir compte de ces liens dans les raisonnements. C’est ce qu’on appelle l’alignement des données et des vocabulaires.

Il y a ensuite toutes les questions relatives à l’exploitation des connaissances acquises : visualiser les connaissances, les interroger, les explorer, recommander des ressources, plus généralement raisonner sur ces connaissances.

Notre équipe a la particularité de placer l’utilisateur au cœur de tous ces traitements, par exemple en se posant la question d’adapter les modes d’interaction au profil de l’utilisateur, d’adapter les modes de visualisation, de personnaliser les recommandations de ressources, de détecter les communautés d’intérêt des utilisateurs et les exploiter pour améliorer encore les recommandations, etc.

Vous partez donc de la demande des utilisateurs ?

CFZ : La demande peut ne pas être explicite mais dans tous les cas, nous cherchons à modéliser l’utilisateur et la communauté dans son ensemble, c’est-à-dire les relations sociales. Cela nous permet d’exploiter cette modélisation en même temps que celle des documents pour gérer les connaissances de la communauté.

Concrètement, comment procédez-vous ? Quels sont les méthodes et les outils que vous utilisez ?

CFZ : Le cœur de nos compétences scientifiques informatiques est le domaine de l’intelligence artificielle (IA). Nous développons des méthodes et techniques de représentation des connaissances et de raisonnement qui s’inscrivent dans le domaine de l’IA. Nous reposons systématiquement sur les techniques et standards du Web sémantique et nous participons à l’élaboration de ces standards.

Autre particularité, notre équipe est pluridisciplinaire. Outre des informaticiens, elle comprend un psychologue ergonome, un philosophe, une linguiste spécialiste du traitement de la langue naturelle. Le psychologue ergonome par exemple travaille sur l’explicitation des besoins en amont des projets et en aval, il élabore les questionnaires pour la validation par les utilisateurs des applications que nous développons, des raisonnements que l’on met en œuvre.

Et comment abordez-vous le problème de la masse des données à traiter ?

CFZ : Le problème général de la masse de données disponibles à traiter, du « big data », est orthogonal au Web sémantique mais il est particulièrement crucial pour lui puisque sur le Web en particulier, on assiste à un déluge de données disponibles. On prend alors en compte cette question dans la conception des algorithmes et des infrastructures qui permettent le passage à l’échelle dans le traitement des données du Web : des algorithmes très sophistiqués deviennent trop coûteux quand la taille des données devient trop grande.

Pour pallier ce problème, il y a deux approches complémentaires :

- la première consiste à distribuer les données, chaque source de données devenant d’une taille raisonnable pour permettre certains traitements coûteux localement ;

- la seconde consiste à distribuer les traitements : appliquer des traitements simples sur de grandes masses de données et combiner leurs résultats.

Quelles sont les applications possibles de vos travaux ?

CFZ : Les applications sont multiples. Je suis par exemple actuellement impliquée dans deux projets dans le domaine de l’e-éducation, qui visent à améliorer l’apprentissage dans un environnement informatique, en guidant mieux les apprenants, en leur faisant des recommandations de ressources ou de parcours pédagogiques plus pertinentes. Pour cela, nous modélisons les ressources de l’environnement d’apprentissage : non seulement les ressources pédagogiques, mais aussi le profil et le contexte des apprenants, ainsi que leurs réseaux sociaux. Cette modélisation repose sur des ontologies (vocabulaires) que nous construisons, pour modéliser un domaine, des approches pédagogiques, les relations sociales des apprenants, etc.

J’ai également travaillé sur un projet avec le centre scientifique et technique du bâtiment (CSTB) qui visait à assister des industriels pour rédiger des documents techniques sur un nouveau produit afin d’obtenir l’autorisation de mise en vente, et assister également des experts du CSTB en charge d’émettre des avis techniques sur ces dossiers techniques en fonction de leur conformité aux normes techniques en vigueur. Le but était de pallier la surcharge des acteurs de ce processus de validation, liée à la masse croissante des documents technico-réglementaires qui entrent dans le processus de validation. Il s’agissait donc de modéliser ces connaissances réglementaires et de raisonner dessus.

Un autre exemple d’application de nos travaux est un projet pluridisciplinaire en lien avec les humanités numériques qui vise l’étude de la transmission des connaissances zoologiques de l’Antiquité au Moyen Âge. Dans ce cadre, nous travaillons à l’extraction de connaissances à partir de textes scientifiques (plus précisément zoologiques) antiques et médiévaux. Nous participons à la construction d’un thésaurus spécialisé, nous mettons en œuvre des raisonnements sur ces connaissances extraites et concevons des modes de visualisation des connaissances, de visualisation des résultats des raisonnements pour assister les historiens dans leur étude de la transmission des connaissances à travers les textes répertoriés.

Enfin, un dernier exemple de projet sur lequel nous travaillons est la détection de communautés d’intérêt à partir des données issues d’un site de questions-réponses tel que Stack Overflow. Le but est de pouvoir recommander des experts pour répondre à des questions sur une thématique particulière, ou encore d’analyser les tendances telles que l’émergence ou la perte de vitesse de certaines thématiques.

Pour finir, quels sont les défis scientifiques à venir ? De nouvelles perspectives d’évolution à envisager ?

CFZ : Les perspectives sont effectivement très nombreuses. D’abord, il y a la question de la confidentialité, de la protection des données, de la confiance dans les données, et dans les résultats des traitements sur les données. Cela demande de modéliser, de prendre en compte la provenance des sources de données et des traitements et d’expliquer les processus de traitement, de justifier les résultats issus de ces traitements.

Une thématique liée est la modélisation et le raisonnement sur les croyances des utilisateurs et plus seulement sur les faits. Par exemple, pour expliquer le résultat de certains traitements automatiques à l’utilisateur, il faut partir de ce que sait ou croit celui-ci. Il s’agit de considérer non pas des faits supposés partagés et connus mais, comme point de départ, l’état des connaissances des utilisateurs, qui peut varier de l’un à l’autre.

Et pour aller encore plus loin dans la modélisation des utilisateurs, il y a également la question de la modélisation des émotions des utilisateurs, une thématique en plein essor. L’idée est de prendre en compte cette dimension émotionnelle pour adapter les interactions aux différents états émotionnels des utilisateurs.

Mais comment peut-on connaître l’état émotionnel d’un utilisateur ? Cela vient-il de la façon dont il formule une recherche ?

CFZ : On peut en effet étudier la trace des actions des utilisateurs, on peut également utiliser les résultats de caméras ou de capteurs qui, à partir des expressions du visage ou du taux de transpiration, ou encore des mouvements cardiaques, vont détecter tel ou tel état émotionnel. Par exemple, dans un jeu sérieux, cela va permettre d’adapter la difficulté des exercices proposés à un état de stress croissant détecté.

Un autre défi est d’améliorer les interactions avec l’utilisateur, notamment en langue naturelle, avec le développement d’agents conversationnels capables de comprendre des questions complexes en langue naturelle, de répondre en langue naturelle et de conduire un dialogue permettant d’aller plus loin dans l’expression du besoin de l’utilisateur.

De manière plus générale, une grande partie des questions de recherche qui se posent actuellement ont été énoncées il y a trente ans et les travaux en Intelligence Artificielle ont à l’époque tenté d’y apporter des solutions avec plus ou moins de succès. L’avènement du Web et les bouleversements qu’il a engendrés réactualisent et renouvellent ces questions tandis que les progrès scientifiques réalisés en Intelligence Artificielle et plus généralement en sciences informatiques depuis trente ans offrent de nouveaux moyens pour y répondre.

Newsletter

Le responsable de ce traitement est Inria. En saisissant votre adresse mail, vous consentez à recevoir chaque mois une sélection d'articles et à ce que vos données soient collectées et stockées comme décrit dans notre politique de confidentialité

Niveau de lecture

Aidez-nous à évaluer le niveau de lecture de ce document.

Votre choix a été pris en compte. Merci d'avoir estimé le niveau de ce document !

Catherine Faron Zucker

Maître de conférences à l'Université Nice Sophia Antipolis, responsable adjointe de l’équipe de recherche WIMMICS.

Joanna Jongwane

Rédactrice en chef d'Interstices, Direction de la communication d'Inria