Réimaginer nos interactions avec le monde numérique

Une première version de cet entretien avec Wendy Mackay est parue sur le site du Collège de France en prévision de la leçon inaugurale de la chaire annuelle Informatique et sciences numériques du Collège de France qu’elle occupe cette année. Ses cours débuteront le 1er mars 2022 et ses enseignements seront disponibles sur le site du Collège de France. Texte reproduit avec l’aimable autorisation du Collège de France.

Portrait de la professeure Wendy Mackay. © Collège de France / Photo Patrick Imbert.

L’étude de l’interaction entre l’humain et la machine est cruciale à l’heure où la technologie est omniprésente. Sur quoi doit-elle se fonder ?

Wendy Mackay : C’est intéressant d’étudier la machine d’une part et l’humain de l’autre, mais insuffisant. Ce que nous faisons dans notre domaine, c’est essayer de comprendre comment ces deux parties interagissent. En tant qu’êtres humains, nous sommes indéniablement influencés par les technologies que nous utilisons quotidiennement ; celles-ci peuvent affecter nos comportements et changer notre manière de réfléchir, mais nous pouvons aussi les adapter à nos besoins en nous les appropriant. Il faut bien comprendre que toutes les capacités humaines sont parties prenantes de l’équation qu’est l’interaction humain-machine. Cela implique de prendre en compte des notions comme la sensation, la perception, l’aspect moteur, la mémoire… toute la psychologie humaine, en somme. Par exemple, l’un de nos sujets de recherche consiste à observer le phénomène de deskilling, c’est-à-dire le processus par lequel les compétences d’un humain sont rendues désuètes, voire perdues, lorsqu’un élément de technologie peut accomplir la tâche pour lui. On observe depuis longtemps cette diminution des capacités humaines relative à la délégation aux machines. Toutefois, on pourrait aller dans le sens inverse et chercher un moyen d’améliorer les compétences et capacités humaines par le biais de cette interaction.

Comment pourrait-on repenser cette interaction pour stimuler les capacités de l’utilisateur ?

Nous considérons plusieurs stratégies pour y parvenir. Ce qui est très plaisant, aujourd’hui, c’est que certains chercheurs du domaine de l’intelligence artificielle commencent à travailler avec nous, spécialistes de l’interaction humain-machine. Prenons l’exemple d’une décision qu’un utilisateur doit prendre à l’aide d’un logiciel ou d’une machine. S’il dispose d’un système qui lui dit directement « il faut choisir A et non B », et que l’utilisateur sait que ce système a généralement raison, il va simplement se contenter de faire ce que lui dit la machine sans recourir à sa propre réflexion : ses capacités n’étant plus stimulées, elles risquent de s’affaiblir. Si nous concevons un système qui, au lieu de donner directement la réponse, doit plutôt réagir à une proposition de l’utilisateur, alors nous créons une situation qui stimule davantage les compétences humaines par la réflexion et l’interaction. C’est un moyen d’apprentissage, ni plus ni moins, entre intelligence artificielle et intelligence humaine. Cependant, des interactions différentes peuvent engendrer une grande variété d’effets, à long terme, sur un utilisateur. Donc, c’est assez compliqué à mettre en place.

Illustration © Flydragon – Fotolia.com

Les disciplines de l’intelligence artificielle et de l’interaction humain-machine se doivent par conséquent d’avancer main dans la main ?

Oui, c’est très important. Du côté de l’intelligence artificielle, la qualité de la recherche est mesurée à la qualité de l’algorithme. Si j’ai un algorithme plus rapide et efficace, et s’il faut moins de données pour obtenir des réponses satisfaisantes, alors j’ai de bons résultats, prêts à être publiés. De l’autre côté, en interaction humain-machine, on mesure l’impact de la technologie sur l’être humain. En travaillant avec de vrais utilisateurs, on mesure non seulement leurs performances, mais aussi l’influence sur leur capacité à innover ; il y a une démarche à la fois quantitative et qualitative. Nous nous intéressons plus à la perspective de l’utilisateur que du concepteur. Aussi, pour une conception optimale et afin d’assurer une expérience d’interaction positive, est-il crucial que nous travaillions et communiquions ensemble.

Publicités Xerox Star / Photo Digibarn Computer Museum.

Notre rapport avec une machine va être déterminé par l’interface qui nous y connecte. Or, la plupart des interfaces d’aujourd’hui sont calquées sur un même modèle depuis les années 1970, celui des interfaces graphiques. Faut-il repenser les bases de ce modèle pour aller plus loin dans l’expérience utilisateur ?

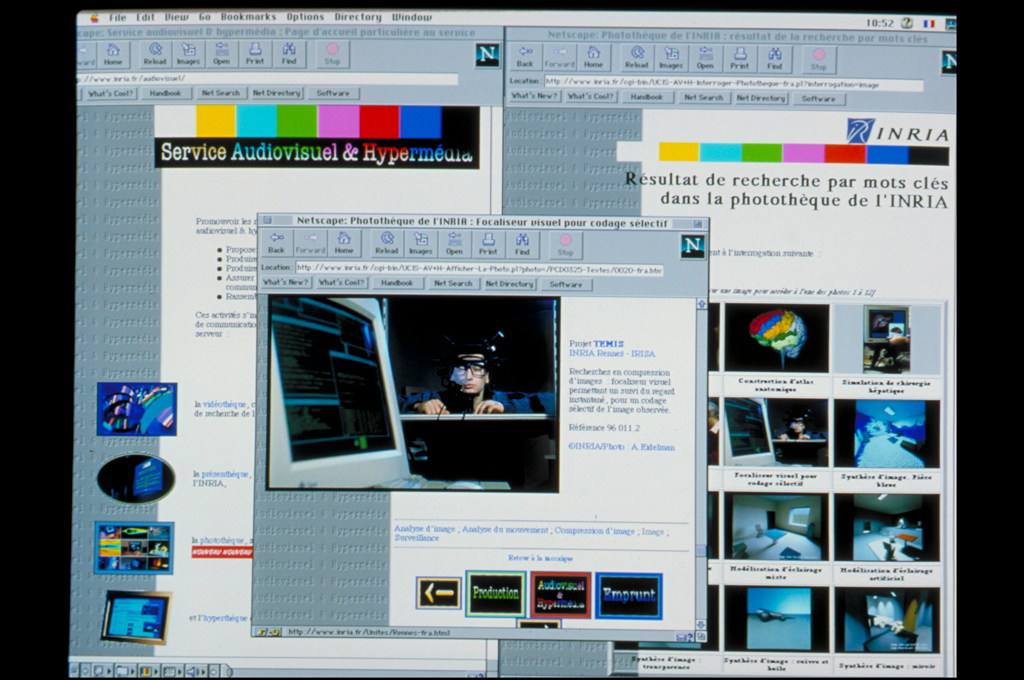

Absolument, et c’est ce que nous sommes en train de faire ! Dans les années 1970 et 1980, il y a eu des travaux à Xerox qui ont conduit au Star, l’un des tout premiers ordinateurs personnels. C’est à cette époque que l’interface graphique, ou Graphical User Interface, a été conçue. Il s’agissait du premier dispositif de dialogue humain-machine dans lequel objets et fonctions étaient représentés sous la forme de petits pictogrammes. Or, cette interface a été développée spécialement pour le travail de secrétariat de direction, avec des dossiers, des fichiers, des outils de copier-coller – et c’est la même interface que nous utilisons encore aujourd’hui ! C’est un bon modèle, à bien des égards, mais qui reste assez limité, alors qu’il y a beaucoup d’autres options. Au début de ma carrière, nous étions bien plus ouverts que nous ne le sommes maintenant, parce que tout est ciblé, à présent, sur ce style fenêtré qui fait l’essence de systèmes comme Windows ou MacOS. Quand je dis à mes étudiants que nous avions des systèmes sans fenêtres, ils ne me croient pas. Pour eux, c’est difficilement concevable, alors qu’on peut très bien combiner la manipulation directe des interfaces graphiques avec des capacités de programmation pour avoir des systèmes plus puissants. On peut aussi utiliser des gestes de la main, voire du corps entier, pour donner des commandes et créer des outils plus expressifs qui seraient davantage orientés vers la créativité que vers la consommation de contenus. Certes, le système le plus répandu actuellement fonctionne : tout le monde connaît et utilise les ordinateurs. On l’a tellement intégré dans notre vie quotidienne qu’il a forgé notre mode de pensée en matière de numérique et conditionné notre interaction avec les machines. Je suis convaincue que nous pouvons faire mieux.

De nombreux outils sont mis au service d’un travail créatif. Comment peut-on les optimiser pour qu’ils soient, plus que de simples instruments, des vecteurs de créativité ?

Si vous prenez les suites créatives que nous connaissons, comme celle d’Adobe ou celle de Microsoft, vous remarquerez que chacun de ses composants se fonde sur l’idée d’une tâche précise à exécuter. L’utilisateur connaît cette tâche et sait comment faire pour la réaliser. Tout ce qui concerne l’exploration et la décision de la nature du problème passe un peu à la trappe. L’être humain, pourtant, a cette capacité propre d’utiliser des outils possédant des fonctions définies pour explorer de nouvelles idées. L’innovation créative viendra de systèmes qui laissent à l’utilisateur assez de place pour explorer sa propre créativité avec l’appui d’outils adaptables, personnalisables et flexibles.

Capture d’écran : page d’accueil du serveur Web du service Audiovisuel et Hypermédia sur le navigateur Netscape

Pourquoi la conception de ces interfaces a-t-elle été si restrictive jusqu’à présent ?

C’est parce que de tels systèmes sont tout simplement plus faciles à produire. Les êtres humains sont très divers et, si je suis concepteur d’un système que je veux vendre, je préfère que mes utilisateurs puissent faire moins de choses, mais les fassent mieux. C’est une stratégie habile : il est aisé de deviner ce que l’utilisateur voudra faire si, à la base, c’est nous qui l’y encourageons. C’est plus facile, plus rentable, avec un public précis et des outils moins complexes à concevoir. Historiquement, il y a aussi un peu de taylorisme, c’est-à-dire l’idée qu’on peut traiter l’humain comme une machine. On analyse la productivité humaine et on optimise les outils servant à l’organisation du travail. On retrouve cette répartition des activités humaines en tâches et compétences bien avant la démocratisation des ordinateurs personnels. C’est pour cela que tous les systèmes ont été conçus sur ce modèle, qui s’est conservé depuis. Pour cette raison, le domaine de la recherche en interaction humain-machine est parfois aussi intéressant que frustrant ; si l’on ne peut pas montrer aux grandes entreprises comment le changement de paradigme pourrait leur rapporter de l’argent, il y a peu de chances de voir ce changement s’implémenter dans l’industrie. En plus du confort de l’utilisateur et de l’efficacité, il y a un aspect marketing à prendre en compte. Dans l’histoire de la technologie, il y a quelquefois des évidences, comme le téléphone portable, dont le concept est très aisément compréhensible et la prise en main nécessite peu d’adaptation pour quiconque connaissait déjà le principe du téléphone. Puis est arrivé le smartphone, avec toutes les capacités d’un ordinateur dans la main et une interface simple à comprendre et à utiliser ; une véritable révolution rendue possible par les sciences de l’interaction humain-machine. Mais avant ce genre d’épiphanie, il y a un long processus de recherche.

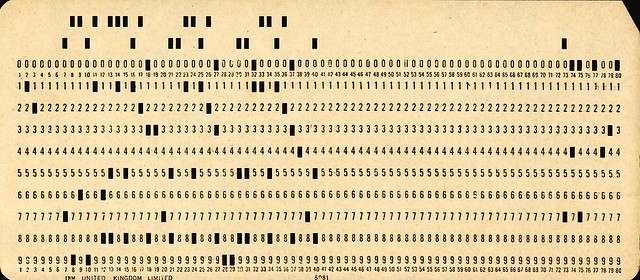

Une carte IBM perforée utilisée aux débuts de l’informatique.

© Pete Birkinshaw via Flickr CC

Pour interagir avec un système, il faut connaître et parler son « langage » dans une certaine mesure. Peut-on imaginer une interface universelle ?

Plutôt qu’une interface universelle, ce que nous tentons de concevoir, c’est une boîte à outils universelle. Nous aimerions proposer aux utilisateurs, en particulier les experts, le moyen non seulement d’apprendre, mais aussi de créer leurs propres outils ou de personnaliser ceux qu’ils ont à disposition. L’idée, c’est de permettre une appropriation du médium et l’exploitation des capacités acquises, sans avoir besoin de les réapprendre lorsqu’on change de système. Hélas, les grandes entreprises n’ont aucun intérêt à cela, en matière de marketing. Prenons l’exemple du courrier électronique et de Facebook. Avec le premier, il me suffit d’une seule adresse pour écrire à n’importe qui, sur n’importe quel système, comme Outlook, Gmail et tant d’autres. Avec Facebook, il faut devenir membre de Facebook et on ne peut communiquer qu’avec d’autres membres de Facebook. Depuis la pandémie, on observe la même chose avec les différentes applications de visioconférence : Skype, Zoom, Teams, Discord… Pour chacun, il faut apprendre comment fonctionne le système, avoir un compte, et tous les participants doivent utiliser le même système. Pour rendre ces systèmes ouverts, interopérables, et plus faciles à approprier par les utilisateurs, une solution est de créer des outils qui ne sont pas liés à telle ou telle application. Ce serait encore mieux que ces systèmes soient coadaptatifs.

Qu’est-ce qu’un système coadaptatif ?

C’est un terme qui vient de la biologie de l’évolution. Dans la nature, on trouve des organismes en constante interaction qui, par conséquent, ont évolué main dans la main : c’est la coévolution à long terme. À court terme, on retrouve ça chez des animaux en symbiose, comme les poissons nettoyeurs et ceux qu’ils nettoient. Quand on regarde comment les êtres humains utilisent la technologie, on retrouve ce principe de coadaptation. Si je veux utiliser Adobe Premiere Pro pour éditer une vidéo, il faut que j’apprenne son mode de fonctionnement et que j’adapte mon comportement, mais je vais aussi m’approprier le logiciel en l’utilisant à ma manière. Un bon exemple est l’évolution des tableurs. À l’origine, il ne s’agissait que d’ajouter des colonnes de chiffres pour vérifier un budget. Puis les utilisateurs s’en sont servis pour explorer des alternatives, par exemple ce qu’on appelle le « What if budgeting » par lequel on peut, en changeant les données d’entrée, voir comment réagissent les données de sortie et inversement. C’était une innovation des utilisateurs, et les concepteurs des tableurs ont ensuite adapté leur logiciel pour répondre à ces nouveaux usages. Il est important, lorsque cela se produit, que les concepteurs soient à l’écoute des utilisateurs ; ce faisant, ils ne pourront qu’améliorer leur système. Ce phénomène se produit partout, tout le temps, dans le monde de la technologie, cependant il est souvent ignoré : on conçoit un système avec une fonction en tête, mais dans la pratique, ses utilisateurs en repoussent les limites. L’humain fait cela depuis qu’il est humain ; il suffit de regarder un enfant se servir d’un crayon – conçu pour écrire – comme une règle pour tracer un trait droit. Appropriation et adaptation font la force du raisonnement technique humain. En le combinant avec l’intelligence artificielle, on arrive à la coadaptation réciproque ; le système réagit à l’usage qu’en fait l’utilisateur, apprend, s’adapte, influence les actions de l’humain, qui de son côté s’adapte, innove et influence le système par ses nouveaux usages.

Newsletter

Le responsable de ce traitement est Inria. En saisissant votre adresse mail, vous consentez à recevoir chaque mois une sélection d'articles et à ce que vos données soient collectées et stockées comme décrit dans notre politique de confidentialité

Niveau de lecture

Aidez-nous à évaluer le niveau de lecture de ce document.

Votre choix a été pris en compte. Merci d'avoir estimé le niveau de ce document !

Wendy Mackay

Directrice de recherche au centre Inria de Saclay, Wendy Mackay dirige le groupe de recherche en interaction humain-machine (IHM) Ex-Situ, commun avec le Laboratoire de recherche en informatique (LRI – Université Paris-Saclay, CNRS). Elle est membre de l’ACM SIGCHI Academy (Association for Computing Machinery – Special Interest Group on Computer-Human Interaction).