50 ans d’interaction homme-machine : retours vers le futur

Cet article met à jour 40 ans d’interaction Homme-machine : points de repère et perspectives publié sur Interstices en avril 2007.

L’interaction avec les ordinateurs est aussi vieille que les ordinateurs eux-mêmes. En effet, un ordinateur est une machine programmable, il faut donc pouvoir y entrer les données et programmes et visualiser les résultats. Les premiers ordinateurs disposaient typiquement de lecteurs de cartes perforées et d’imprimantes, mais ces dispositifs ne permettaient pas une réelle interaction, pendant l’exécution du programme. Aussi l’histoire de l’interaction Homme-machine (IHM) débute réellement au début des années 1960 avec les travaux pionniers de Ivan Sutherland sur SketchPad, qui ont montré comment un opérateur pouvait interagir en temps réel avec une machine exécutant un logiciel complexe.

Ce texte présente quelques points de repère de cette histoire de l’IHM. Il ne prétend pas être exhaustif (pour une liste plus complète, voir par exemple un article de B. Myers paru en 1992, ainsi que les sites web mentionnés en annexe). L’objectif est de mettre en regard les travaux des pionniers de l’interaction Homme-machine avec les systèmes interactifs commerciaux actuels, et d’attirer ainsi l’attention sur le décalage entre l’état de l’art et les standards du marché, entre les inventions et leur large diffusion.

Ivan Sutherland : de SketchPad à la réalité virtuelle

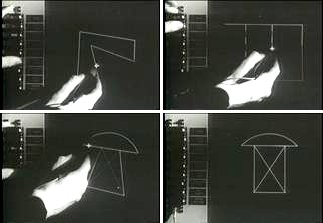

L’écran de SketchPad avec, à gauche, la rangée de boutons permettant de choisir la commande et au centre l’opérateur utilisant le stylo optique pour créer des schémas. L’image en bas à droite résulte de l’application de contraintes d’orthogonalité entre les segments sur l’image en bas à gauche. Source : Wikipedia.

SketchPad, développé par Ivan Sutherland au début des années 1960 et publié dans sa thèse de doctorat en 1963, est considéré comme la première interface graphique. Développé au MIT Lincoln Laboratory, c’est le premier système à utiliser un écran cathodique et un crayon optique pour l’édition graphique de dessins techniques. Bien plus tard, en 1983, Ben Shneiderman appellera ce type d’interaction avec des objets représentés à l’écran « manipulation directe », par contraste avec l’utilisation systématique, jusqu’au début des années 1980, de langages de commandes obligeant à mémoriser les noms des commandes et des objets, une forme d’interaction encore pratiquée aujourd’hui dans ce que l’on appelle le « terminal ».

SketchPad permet de créer interactivement des diagrammes et des plans. Il met déjà en œuvre de nombreux concepts fondamentaux des interfaces graphiques modernes : désignation directe des objets à l’écran, retour d’information immédiat sous forme de lignes élastiques, zoom avant et arrière sur le dessin avec un facteur de 2000, etc. Il inclut même des fonctions dont peu de logiciels modernes disposent. Par exemple, l’utilisateur peut spécifier des contraintes, comme le fait que des segments doivent être parallèles ou à angle droit, après la création du dessin. On voit alors l’objet s’animer pour satisfaire au mieux ces contraintes. Même au niveau de la mise en œuvre, les concepts sont étonnamment modernes : représentation des objets graphiques en mémoire, résolution de contraintes, système de rendu graphique.

Le premier casque de réalité virtuelle, réalisé par Sutherland et Sproull (Harvard, 1967). Source : A Critical History of Computer Graphics and Animation Section 17: Virtual Reality

Sutherland développe SketchPad sur le TX-2, l’un des rares ordinateurs de l’époque utilisable en ligne : jusqu’à la fin des années 1970, la grande majorité des ordinateurs sont utilisés de façon non interactive, en traitement par lots (« batch »). Le TX-2 a 320 Ko de mémoire, deux fois plus que les plus gros ordinateurs commerciaux de l’époque, une unité de bande magnétique, la première imprimante de Xerox, et l’entrée des programmes se fait par ruban perforé. Surtout, le TX-2 a un écran cathodique (en fait un oscilloscope) de 9 pouces (21 cm), un crayon optique, et un panneau de boutons que Sutherland utilise pour sélectionner des fonctions, comme la palette d’outils des interfaces modernes. D’autres chercheurs utilisent le TX-2 à la même époque pour réaliser d’autres interfaces révolutionnaires, comme Ron Baecker qui crée Genesys, le premier système d’animation de l’Histoire.

Peu après, Ivan Sutherland devient l’un des pionniers de l’infographie, avec notamment un algorithme d’élimination des parties cachées qui porte son nom, et de la réalité virtuelle. En 1967, alors qu’il est professeur à Harvard, il crée avec son étudiant Bob Sproull le premier casque de réalité virtuelle affichant des images de synthèse. Plus tard encore, il s’intéresse à la robotique, et crée l’entreprise Evans & Sutherland, célèbre dans les années 1980 pour ses systèmes graphiques haut de gamme.

Doug Engelbart : NLS/Augment

Pendant que Ivan Sutherland travaille sur SketchPad sur la côte est des États-Unis, sur la côte ouest, Doug Engelbart commence à travailler sur ce qui deviendra NLS/Augment. Engelbart est un visionnaire qui a anticipé une grande partie de l’évolution de l’informatique depuis les années soixante. Revenu de la guerre convaincu que seule la combinaison de la puissance de calcul des machines et de l’intelligence humaine peut résoudre les problèmes du monde, il publie en 1962 un article fondateur intitulé « Augmenting Human Intellect : A Conceptual Framework ». Il y présente sa vision du rôle des systèmes informatiques dans ce qu’il appelle l’augmentation de l’intellect humain, grâce à leur puissance de calcul mais aussi aux possibilités de collaboration qu’ils offrent.

D’une certaine façon, cet article fait écho à un autre article séminal, « As We May Think » de Vannevar Bush, qui présentait en 1945 un système imaginaire appelé Memex, considéré aujourd’hui comme l’ancêtre de l’hypertexte. Lorsque Vannevar Bush écrit son article, l’ordinateur existe à peine.

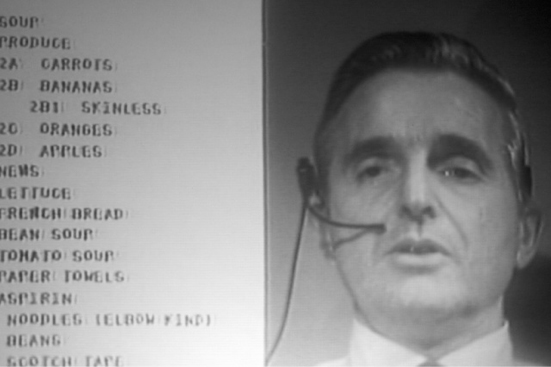

La souris inventée par Doug Engelbart.

Source : 1968 Demo

Quinze ans plus tard, l’informatique s’est développée et Engelbart peut commencer à mettre en œuvre sa vision, sur laquelle il travaillera le reste de sa vie, notamment au sein du Bootstrap Institute qu’il crée en 1989 lorsque McDonnell Douglas arrête le financement de son projet (pour un historique détaillé, voir l’article d’Interstices Douglas Engelbart, inventeur et visionnaire).

En 1964, Doug Engelbart invente la souris, car il veut pouvoir facilement désigner des objets à l’écran, et brevète ce dispositif. Le brevet ne lui rapportera jamais rien, car les souris commercialisées plus tard utilisent une boule au lieu des deux roues de son système. Il crée également des claviers à accord (« chord keyboards ») qui permettent d’entrer des données en composant des accords avec les doigts d’une main, comme sur le clavier d’un piano. Peu de gens ont été capables de maîtriser ces claviers, qui sont cependant encore utilisés par les greffiers dans les tribunaux américains pour la saisie de texte. La souris, par contre, s’est imposée comme le périphérique incontournable des interfaces graphiques.

Le clavier du système NLS, avec le « chord keyboard » sur sa partie gauche et la souris sur sa partie droite. Source : 1968 Demo

Fin 1968, Engelbart fait une démonstration publique devant mille personnes de son système NLS (oN-Line System), développé depuis plusieurs années au SRI, à Stanford. La démonstration est filmée et elle est aujourd’hui disponible sur le site web de Stanford.

NLS est un système hypertexte collaboratif couplé à un système de vidéoconférence. Des utilisateurs séparés de 45 km éditent collaborativement des données organisées hiérarchiquement, comme le plan d’un document découpé en chapitres, sections et sous-sections. Lorsqu’ils collaborent, ils peuvent se voir par vidéoconférence et utiliser des télépointeurs pour montrer des objets à l’écran. L’interaction avec NLS est complexe, notamment à cause de l’utilisation du « chord keyboard ». Mais Doug Engelbart a toujours été perplexe devant l’idée de systèmes conviviaux ou faciles d’utilisation. Pour lui, l’important est que le système permette aux utilisateurs de développer leurs compétences et de construire des organisations humaines plus évoluées. Il justifie cette approche avec l’exemple suivant : il est plus facile de faire du tricycle, mais le vélo est plus rapide car on peut se pencher dans les virages ; le temps passé à apprendre le vélo est donc largement rentabilisé. Engelbart défend ainsi l’idée d’interfaces adaptées aux capacités des utilisateurs experts, quitte à nécessiter un apprentissage, plutôt que des interfaces simplistes devant être accessibles à tout le monde.

Édition collaborative de texte temps réel et vidéoconférence dans NLS/Augment.

Source : 1968 Demo

Certains aspects de NLS (rebaptisé Augment lorsque Engelbart quitte le SRI en 1978) ont mis des décennies à s’imposer. Ainsi, ce n’est que tout récemment que la vidéoconférence, par exemple avec Skype, et l’édition collaborative, par exemple avec Google Docs, sont devenues largement accessibles. L’explication en est peut-être que, avec le Xerox Star qui se profile et plus tard le Macintosh, l’informatique s’intéresse à des catégories d’utilisateurs différentes de celles que visait Engelbart : les « knowledge workers » (travailleurs intellectuels) pour NLS, les secrétaires pour le Star, le grand public pour le Macintosh. L’avènement dans les années 1980 de l’informatique dite individuelle est d’ailleurs bien la preuve que la vision d’Engelbart de systèmes spécifiques à la collaboration est restée très longtemps ignorée. Il aura fallu attendre l’explosion du Web 2.0, des réseaux sociaux, des services comme Skype et Google Docs pour que les outils informatiques commencent à fournir de réelles capacités de collaboration.

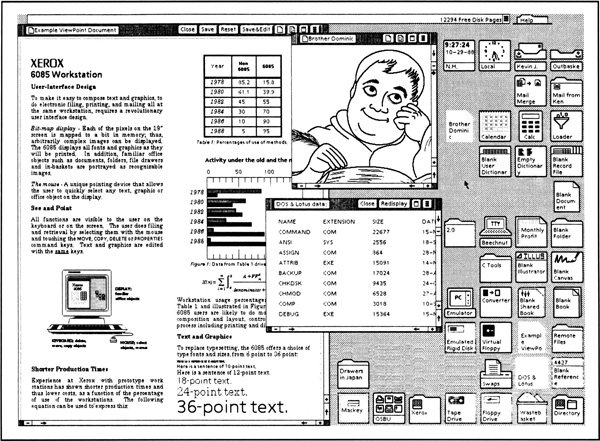

Xerox : le Star

L’écran, le clavier et la souris du Xerox 8010, connu sous le nom de Star.

Source : The first GUIs

En 1970, Xerox crée son laboratoire de recherche à Palo Alto, le PARC. Xerox veut non seulement développer sa technologie de la photocopie, mais aussi se lancer sur le marché des systèmes bureautiques. Le slogan favori des chercheurs du PARC est dû à l’un de ses fondateurs, Alan Kay : « la meilleure façon de prédire le futur, c’est de l’inventer ». De fait, Xerox PARC est le théâtre d’un nombre spectaculaire d’inventions qui ont marqué l’informatique. Ainsi, au moment du lancement du projet Star en 1975, Xerox a déjà inventé l’imprimante à laser et le réseau local Ethernet, et développe le langage à objets Smalltalk.Dès 1968, Alan Kay, considéré comme le père de l’informatique individuelle, a sa propre vision de l’ordinateur, qu’il appelle le Dynabook. Elle consiste à fournir aux utilisateurs non pas des applications préprogrammées, mais un ensemble d’outils pour construire chacun son propre environnement. Pour mettre en œuvre sa vision, Alan Kay développe dans les années 1970 le langage Smalltalk et son environnement de programmation graphique, premier du genre. Il poursuit encore aujourd’hui ses travaux au sein du Viewpoints Research Institute dont il est le président.

La première station de travail personnelle munie d’un écran graphique développée à Xerox PARC est l’Alto. Elle sert de base à de nombreuses applications qui permettent d’affiner les principes de l’interaction graphique : édition de texte et de dessins (images ou formes graphiques), courrier électronique, outils bureautiques. C’est dans ce contexte qu’est lancé le projet Star en 1975, qui débouche en 1981 sur l’annonce du « Xerox 8010 Information System », nom commercial du Star. Cette machine est conçue pour les secrétaires de direction, une cible logique pour Xerox qui s’affiche comme « The Document Company » et cherche à trouver des relais de croissance dans la perspective de l’échéance de ses brevets sur la photocopie. Même si sa commercialisation est un échec, le Star révolutionne l’informatique en préfigurant l’avènement des ordinateurs personnels et des interfaces graphiques.

Les aspects matériels du Star sont conçus en fonction des besoins identifiés pour le logiciel. Ce matériel consiste en un processeur microcodé d’une puissance inférieure à un million d’instructions par seconde, muni d’opérations rapides pour accéder à l’écran (BitBlt), de 385 Ko de mémoire, d’un disque de 10 à 40 Mo, d’un lecteur de disquettes 8 pouces et d’une connexion Ethernet. Les périphériques d’interaction sont un écran noir et blanc de 17 pouces, une souris à deux boutons et un clavier spécial, muni de deux pavés de touches de fonctions, à droite et à gauche de la partie alphabétique. Le logiciel est programmé en Mesa, une variante évoluée de Pascal développée au SRI. Le développement du Star représente à l’époque un effort de 30 hommes-années, pour une machine dont la capacité de calcul et de stockage est une fraction de celle de la moindre calculette d’aujourd’hui.

Le Star est, dès le départ, une machine destinée à être connectée à un réseau local Ethernet. L’interface permet de naviguer parmi les ressources présentes sur le réseau (imprimantes, serveurs de fichiers, etc.) de façon totalement transparente, et de créer son propre environnement en déplaçant les icones de ces ressources sur le bureau. Le Star est la première machine à offrir des fenêtres qui se superposent et à utiliser la métaphore du bureau, avec notamment des icones représentant les documents, les dossiers et d’autres ressources. Larry Tesler, s’inspirant de la façon dont les maquettistes dans l’édition utilisent des ciseaux et de la colle pour littéralement copier et coller des morceaux de texte, invente le copier-coller. Il met près de quinze ans à imposer cette méthode, qui nous paraît pourtant aujourd’hui évidente et indispensable.

Mais le plus frappant dans l’interface du Star par rapport à nos systèmes actuels est que le système est centré sur la notion de document : un nouveau document est créé à partir d’un modèle existant, et tout document peut contenir du texte, des dessins, des formules mathématiques, des tableaux, tous éditables sur place. Pour l’utilisateur, la notion d’application est inexistante.

L’interface graphique du Star.

À gauche, une fenêtre avec un document mélangeant texte, graphique et tableaux, à droite, un ensemble d’icones de documents et de ressources, et deux autres fenêtres au milieu.

Source : The Xerox Star: A retrospective

L’interface est conçue pour utiliser un nombre minimal de commandes, dont les principales sont accessibles directement par des touches de fonctions du clavier : copier, déplacer, détruire, changer les propriétés. L’interface n’a pas de barre de menus, seulement un ou deux menus déroulants pour les fonctions les moins fréquentes. Il n’utilise pas de boîtes de dialogue dites modales, qui interrompent l’utilisateur, mais des boîtes de propriétés associées à la partie du document en cours d’édition. Grâce à la configuration du clavier, l’interaction consiste à manipuler la souris à la main droite pour désigner les objets d’intérêt et sélectionner les options dans les boîtes de propriétés, et à utiliser les touches de fonctions à gauche du clavier avec la main gauche pour spécifier les actions. En cela, le Star reprend le style d’interaction de NLS/Augment en le simplifiant.

|

|

| Sur le clavier du Star, pavés de touches de fonctions disposés de part et d’autre du clavier alphabétique. Source : DigiBarn Computer Museum |

|

Tous les concepts des interfaces modernes sont présents dans le Star. À vrai dire, le Star est encore en avance par rapport aux interfaces actuelles : la transparence du réseau, l’environnement centré sur les documents, l’utilisation d’un petit nombre de commandes qui s’appliquent à un grand nombre de contextes, l’interaction non-modale, autant de caractéristiques du Star qui ne sont toujours pas présentes dans les environnements actuels. Pourtant le Star est un échec commercial : système trop cher, cible marketing mal évaluée, et surtout incapacité de Xerox à sortir de son marché historique des photocopieurs.

C’est le Macintosh d’Apple qui, trois ans plus tard, est le réel point de départ du marché de l’informatique personnelle. Certes, le Macintosh s’est largement inspiré du Star (on cite fréquemment la visite de Steve Jobs et de son équipe au Xerox PARC en 1979). Mais le concept est, dès le départ, différent et propre à Apple, et une grande partie de l’interface du Macintosh est dérivée du Lisa et a été créée avant la visite de Jobs au PARC. Apple invente la barre de menus et les boîtes modales, laisse de côté l’aspect réseau, et conserve le concept d’application qui était familier aux utilisateurs de l’Apple ][. Quinze ans plus tard, au début des années 1990, Apple tentera d’introduire une approche centrée sur les documents avec OpenDoc, mais le projet sera abandonné. Entre autres, il remettait en cause le modèle commercial selon lequel les éditeurs de logiciels vendent des applications autonomes et indépendantes les unes des autres. Pourtant, le modèle de document, que l’on trouve notamment sur le Web, est conceptuellement plus adapté aux usages bureautiques que celui d’application.

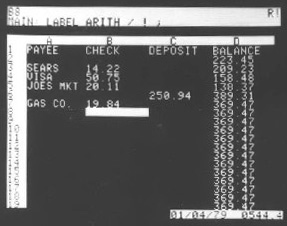

Une application emblématique : le tableur

Version alpha de VisiCalc en 1979, sur un Apple ][.

Source : Dan Bricklin

Certaines applications interactives ont révolutionné l’usage que nous faisons des ordinateurs. En 1979, Dan Bricklin et Bob Frankston commercialisent VisiCalc, le premier tableur de l’histoire. Bricklin, étudiant à Harvard, en a l’idée en utilisant une calculette Texas Instruments. Il imagine comment un système permettant la visualisation dite « tête haute » d’une feuille de calcul, piloté par un « trackball », lui faciliterait la résolution de ses exercices d’économie en lui permettant de tester rapidement plusieurs hypothèses.La visualisation tête haute date des années 1950 et a été d’abord utilisée dans les avions de chasse, pour afficher les informations directement sur la vitre du cockpit plutôt que sur des écrans du tableau de bord, évitant ainsi aux pilotes d’avoir à baisser la tête pour lire les informations. Certaines voitures utilisent aujourd’hui ce système d’affichage. Quant au « trackball », c’est une boule dont seule la partie supérieure émerge de son boîtier et que l’on peut faire tourner sur elle-même. Elle est un peu moins précise qu’une souris mais offre l’avantage de nécessiter peu de place.Bricklin abandonne l’idée de la visualisation tête haute pour se rabattre sur l’écran de son Apple ][, et il décide d’utiliser les touches de positionnement du curseur du clavier, car le contrôleur de jeu de l’Apple ][ n’est pas assez précis pour permettre le pointage direct des cellules. L’algorithme de recalcul des cellules est dérivé d’un algorithme de Sussman et Stallman du MIT, et permet de recalculer instantanément les valeurs de l’ensemble du tableau lorsque l’on change le contenu d’une cellule. L’interaction avec un tableur est donc d’une grande simplicité : déplacer le curseur sur une cellule, entrer sa valeur ou la formule qui la calcule.Il n’existe peut-être pas d’autre exemple d’application informatique ayant eu un impact aussi important, et dont le concept n’a pas changé en trente-cinq ans. Grâce à VisiCalc, les comptables peuvent faire en un quart d’heure ce qui leur prenait vingt heures par semaine auparavant. Mais surtout, comme Bricklin l’avait bien vu, le tableur devient un outil d’aide à la décision et non pas simplement un outil de calcul : il permet de tester et de comparer rapidement plusieurs hypothèses, et d’échanger non seulement des résultats, mais aussi la méthode de calcul. Enfin, le tableur est fondé sur un modèle tellement simple et puissant qu’il est détourné, approprié de mille manières par ses utilisateurs. Certains l’utilisent pour littéralement dessiner (et simuler) des circuits électroniques, d’autres pour réaliser des œuvres d’art, d’autres encore pour faire de la mise en page. Le tableur a ainsi la propriété, rare pour un programme informatique, de dépasser les usages attendus par ses concepteurs.

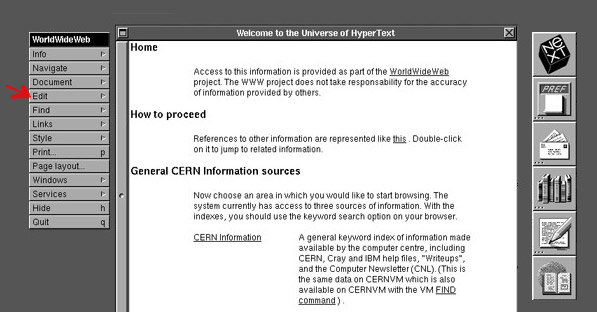

Une occasion manquée pour l’interaction : le Web

Nexus, le premier navigateur web. La flèche rouge montre la commande « Edit » qui permettait d´éditer directement le contenu de la page. Source : Digital Archaeology.

Un autre concept qui a eu un impact considérable sur nos usages de l’ordinateur est celui de l’hypertexte, dont on a vu plus haut qu’il remonte à l’article visionnaire de Vannevar Bush en 1945. Le terme hypertexte lui-même a été inventé en 1968 par Ted Nelson, qui publie en 1981 un ouvrage intitulé « Literary Machines » où il présente Xanadu, une vision d’un système mondial en réseau pour la publication de documents. Xanadu est notamment fondé sur un procédé de « transclusion » : au lieu de copier le texte d’un document lorsqu’on le cite, on inclut une référence au document source, qui peut ainsi garder trace des citations et mettre en œuvre un système de micropaiement à l’acte. Nelson a tenté depuis, sans réel succès, de réaliser Xanadu. Par ailleurs, de nombreux systèmes hypertexte ont été développés dans divers laboratoires à partir de cette époque.

En 1980, Tim Berners-Lee crée au CERN, le centre européen de recherche nucléaire installé sur la frontière franco-suisse, un système hypertexte qui sera le précurseur du Web. En 1989, il propose au CERN un projet de système hypertexte en réseau, et réalise en 1990 Nexus, un prototype qui est à la fois un navigateur (« browser ») et un éditeur de pages web. Il invente le langage HTML de description des pages et le protocole HTTP de communication entre navigateur et serveur web. Mais le prototype est implémenté sur le NeXT, une machine peu répandue, ce qui nuit à son déploiement.

En 1993, Marc Andressen implémente le navigateur Mosaic sous l’environnement X-Window, qui est largement utilisé dans le monde de la recherche, mais il n’a pas le temps d’y intégrer un éditeur de pages web comme dans la version de Berners-Lee. La diffusion de Mosaic marque le début du développement exponentiel du Web en-dehors de son contexte d’origine vers le succès qu’on lui connaît.

Mais sur le plan de l’interaction, les navigateurs web marquent un grand coup d’arrêt, sinon un retour en arrière. Jusqu’à très récemment, l’interaction sur le Web était limitée à cliquer des liens et remplir des formulaires, ce qui n’est pas beaucoup mieux que ce que permettait notre Minitel national. Alors que Berners-Lee voulait que chacun puisse également être un auteur, l’édition de pages et la construction de sites nécessitent des outils complexes et des connaissances avancées. Alors qu’il s’agit d’un système destiné à partager des documents, le support à la collaboration de groupe, chère à Engelbart, est pratiquement inexistant.

Certes, l’avènement du Web 2.0 et l’évolution des standards ont permis de rapprocher l’interaction de celle que l’on peut avoir avec des applications classiques. Mais à quel prix ! Chaque page doit embarquer du code Javascript qui implémente, souvent de façon incomplète ou maladroite, des interactions aussi courantes qu’un menu déroulant ou le glisser-déposer ; l’édition de texte est d’une grande pauvreté ; la création de pages et de sites est de plus en plus complexe, sauf à utiliser des outils comme les blogs qui restreignent dramatiquement la forme des contenus et les capacités d’interaction.

Le Web présentait une opportunité rare d’imaginer de nouvelles formes d’interaction collective pour fabriquer et organiser des contenus riches et variés. Mais finalement il est resté un système orienté essentiellement vers la diffusion de documents, et c’est en-dehors du Web que se sont développées les inventions et innovations plus récentes en IHM.

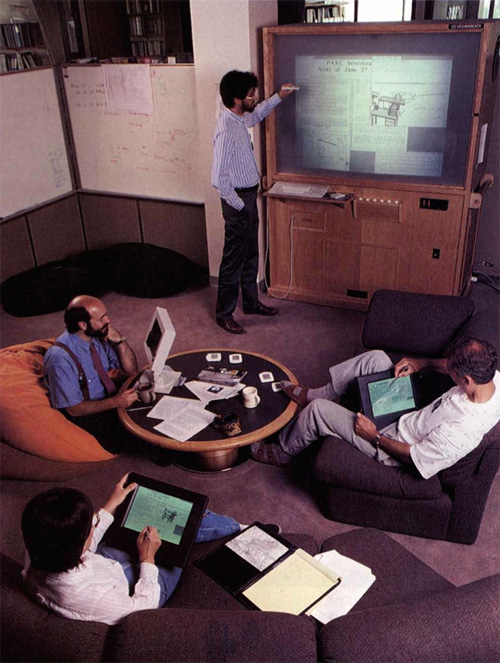

Vers l’interaction physique avec le monde numérique

En 1991, Mark Weiser publie un article qui présente l’Ubiquitous Computing, ou Ubicomp, sa vision de l’informatique du 21e siècle. Avec l’Ubicomp, la multiplication des ordinateurs et des écrans de toutes tailles permet l’accès à l’information en tout lieu et en toute circonstance. Dans son laboratoire à Xerox PARC, Mark Weiser développe des prototypes de systèmes Ubicomp avec des ordinateurs de trois tailles (badge, bloc-note et tableau) capables de communiquer entre eux pour créer un environnement interactif. Le badge permet de localiser son porteur, et de mettre à disposition ses documents informatiques sur le bloc-note ou le tableau le plus proche, ce dernier pouvant être utilisé de manière collaborative.

Le prototype de système Ubicomp de Mark Weiser.

Source : MJSBlog.

« Pick and Drop » : l’utilisateur transfère un document d’un appareil à l’autre simplement en le tapant avec son stylet. Photo © 1997-1998, Sony Computer Science Laboratories, Inc.

Cette vision préfigure clairement l’avènement des smartphones, des tablettes tactiles, des tableaux interactifs et de l’Internet des objets. Mais elle reste loin d’être réalisée à ce jour, car là où Weiser imaginait tous ces appareils fonctionnant de façon harmonieuse dans leur environnement, la situation actuelle est beaucoup plus chaotique. Ainsi, transférer de l’information d’un appareil à l’autre est particulièrement fastidieux. Pourtant, Jun Rekimoto a inventé en 1997 à Sony Labs le « pick-and-drop », une technique intuitive qui consiste simplement à « attraper » l’information sur un appareil avec un stylo pour la transporter vers un autre. Mais la prolifération des standards et les stratégies protectionnistes des constructeurs (leur « écosystème ») rendent difficile, voire impossible, l’interopérabilité entre appareils que nécessitent de telles interactions.L’Ubicomp a été le premier d’une série de concepts d’interaction qui visent tous à mieux intégrer le monde numérique et le monde physique et abolir, ou tout au moins réduire, les frontières entre ces deux mondes. Ainsi, la réalité augmentée est inventée en 1993 en réaction à la réalité virtuelle, alors très en vogue. L’objectif ici est d’intégrer l’information numérique directement au sein des objets physiques plutôt que de la confiner dans le monde informatique de l’ordinateur.

|

|

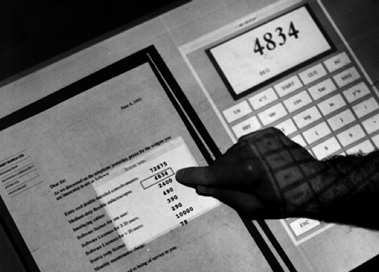

| Le Digital Desk. À gauche, vue générale du prototype, à droite, détail de son utilisation. Source : Pierre Wellner |

|

Le Digital Desk, développé par Pierre Wellner à Rank Xerox EuroPARC, est le premier système de réalité augmentée et probablement le plus emblématique : grâce à un projecteur et une caméra montés au-dessus d’un bureau traditionnel, l’ordinateur peut suivre et interpréter les manipulations d’objets physiques posés sur le bureau, comme des feuilles de papier, et projeter des informations ou des applications, comme une calculette, que l’on peut manipuler à même le bureau. Une autre approche de la réalité augmentée développée à la même époque, notamment par Steven Feiner de Columbia, utilise des dispositifs de réalité virtuelle pour superposer des images sur le monde physique.

À la même époque apparaissent les interfaces dites tangibles, développées notamment au sein du MIT Tangible Media Group de Hiroshi Ishii au Media Lab du Massachussetts Institute of Technology. L’idée est de rendre l’information physique, de lui donner une matérialité qui permet de tirer parti de notre facilité à manipuler des objets physiques. L’exemple canonique d’une interface tangible est la « Marble Answering Machine » de Durrell Bishop. Il s’agit d’un répondeur téléphonique dont chaque message est représenté par une bille, qui sort de la machine lorsque le message est reçu. On écoute le message en posant la bille sur un emplacement prévu à cet effet sur le répondeur, on l’efface en la remettant dans le répondeur, mais on peut aussi l’emporter avec soi comme pense-bête. De nombreuses interfaces tangibles ont été développées dans les laboratoires depuis vingt-cinq ans et continuent de l’être. Elles ont inspiré certains dispositifs de l’Internet des objets, et l’on peut parier que ce mouvement va se poursuivre.

Un dernier exemple de la fusion des mondes physique et numérique est le papier interactif. Dès 1974, Xerox, encore lui, a inventé le Gyricon, un papier électronique dont une variante est utilisée aujourd’hui dans les liseuses électroniques. Mais c’est la technologie de l’entreprise suédoise Anoto, au début des années 2000, qui permet réellement d’envisager des applications interactives. Grâce à un stylo muni d’une microcaméra et d’un papier sur lequel est imprimée une trame de points quasiment invisible à l’œil nu, tous les tracés réalisés avec le stylo sont envoyés en temps réel à un ordinateur. On peut donc écrire sur du vrai papier, tandis que l’ordinateur analyse ces traces. Wendy Mackay, d’Inria, travaille depuis vingt-cinq ans sur le papier interactif et a créé de nombreux prototypes : des « strips » de papier utilisés par les contrôleurs du trafic aérien, des cahiers de laboratoire interactifs utilisés par des biologistes, des interfaces papier pour la création musicale. Alors que l’écran de l’ordinateur devait nous débarrasser du papier, avec le mythe du bureau sans papier, c’est peut-être finalement celui-ci qui va nous débarrasser des écrans !

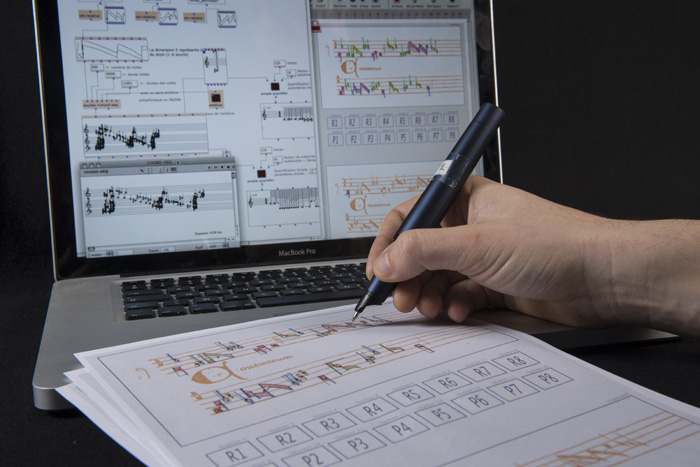

Papier interactif : le compositeur Philippe Leroux utilise le papier interactif pour créer une composition musicale et contrôler son interprétation par l’ordinateur. « Quid sit Musicus » : Wendy Mackay, Jérémie Garcia, Philippe Leroux.

© Inria / Photo H. Raguet

L’interaction gestuelle

L’écran tactile du système PLATO IV.

Source : Bill Buxton.

Pour terminer ce tour d’horizon, nous abordons un dernier pan de l’histoire de l’interaction. Avec l’avènement des smartphones à écran tactile puis des tablettes d’une part, des jeux vidéos utilisant les mouvements du corps entier d’autre part, l’interaction gestuelle a eu depuis moins de dix ans un impact considérable. Mais d’où viennent ces technologies ?

C’est en 1964 que la première tablette graphique est créée par Tom Ellis dans l’entreprise RAND. Cette tablette utilise un stylet, et Ellis développe le système GRAIL qui est le premier à reconnaître les marques tracées avec le stylet, comme les lettres de l’alphabet. En 1972, le système PLATO IV de l’Université d’Illinois, destiné à l’enseignement assisté par ordinateur, est l’un des premiers à utiliser un écran tactile : l’écran à plasma de 512 x 512 pixels est muni d’une grille infrarouge tactile de 16 x 16 cases. En 1985, Bill Buxton, de l’université de Toronto, développe la première tablette capable de détecter plusieurs points de contact simultanés avec leur pression. Il faudra plus de trente ans pour qu’un smartphone, l’iPhone 6S, intègre un écran multitactile sensible à la pression.

Dès 1969, Myron Krueger crée des installations qui permettent aux utilisateurs d’interagir avec l’ensemble de leur corps grâce à l’analyse en temps réel de leurs mouvements, et invente le terme Artificial Reality pour décrire ces espaces d’interaction qui jouent avec les lois de la physique. La plus connue de ces installations est VideoPlace, présentée à partir de 1974. La caméra Eye Toy de Sony, commercialisée en 2003, et la Kinect de Microsoft, dévoilée en 2009, sont les descendants directs de VideoPlace. Il est intéressant de constater que ce sont les jeux vidéo qui sont les héritiers des installations de Myron Krueger. En fait, les jeux sont depuis longtemps un vecteur d’innovation en matière d’interaction, avec l’utilisation de périphériques d’entrée dédiés ou l’utilisation massive de la 3D.

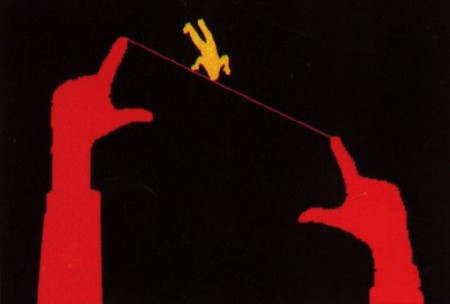

VideoPlace de Myron Krueger.

Source : Inventing Interactive.

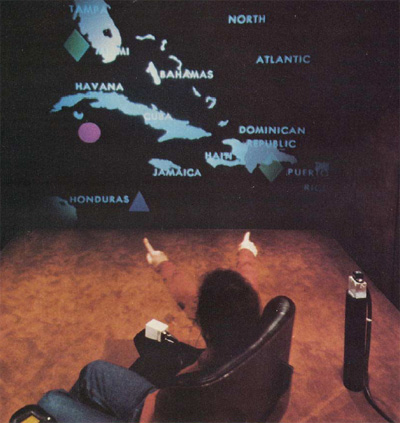

En 1980, Rich Bolt du MIT présente le système Put-That-There, premier système dit multimodal qui combine la reconnaissance des gestes de la main dans l’espace, la désignation sur un grand écran grâce à un capteur à six degrés de liberté et la reconnaissance de la parole. Ce système vise des applications d’aide à la décision, notamment en situation de crise comme le montre le scénario choisi de la crise de Cuba. Comme la plupart des applications multimodales qui lui ont succédé, Put-That-There met l’accent sur l’interaction vocale, les gestes servant à compléter de façon naturelle l’information transmise par la voix. Trente-cinq ans plus tard, bien que les assistants vocaux commencent à se généraliser, force est de constater que l’interaction multimodale n’est pas encore présente dans des produits commerciaux grand public.

Put-that-there de Rich Bolt.

Source : « Put-That-There »: Voice and Gesture at the Graphics Interface Richard A. Bolt, Architecture Machine Group Massachusetts Institute of Technology.

Contrairement à des idées répandues, ce n’est donc pas Apple qui a inventé l’interaction tactile avec l’iPhone, ni Microsoft qui a inventé l’interaction du corps entier avec la Kinect. Il ne faut pas pour autant sous-estimer le travail considérable réalisé par ces entreprises pour résoudre tous les problèmes techniques ayant permis d’industrialiser ces produits et assurer leur succès. De la même façon, les assistants vocaux d’Amazon, Google, Apple et Microsoft sont le résultat de longs et anciens travaux de recherche sur la reconnaissance de la parole, que nous n’avons pas la place de détailler ici. On peut cependant prédire que ces assistants seront tôt ou tard munis de capacités multimodales pour améliorer l’interaction.

Conclusion : Retour vers le futur

Cet historique de l’interaction Homme-machine a montré que la plupart des concepts des interfaces actuelles sont anciens. Cela ne doit pas nous surprendre : les technologies mettent généralement une trentaine d’années à passer des travaux initiaux des laboratoires de recherche à la diffusion de masse, et l’informatique comme l’interaction Homme-machine n’échappent pas à cette règle.

Néanmoins, de nombreuses innovations significatives en interaction Homme-machine sont passées inaperçues. Par exemple, les menus circulaires (« pie menus ») inventés en 1986 par Don Hopkins et améliorés en 1993 par Gordon Kurtenbach peuvent diviser par trois le temps de sélection dans un menu. Pourtant, ils ne sont implémentés dans aucune application commerciale de masse. C’est une autre loi de l’innovation, qui veut que nombre d’inventions soient oubliées ou ignorées, jusqu’à ce qu’elles soient éventuellement redécouvertes.

Il est plus inquiétant de constater que les visions de Doug Engelbart et de Ted Nelson, qui datent de près de cinquante ans, sont loin d’être réalisées, et que les interfaces graphiques actuelles sont une pâle copie de ce que permettait et promettait le Star il y a trente-cinq ans. En effet, la réalisation de ces visions risque fort d’être impossible avec les interfaces actuelles, leur cortège de standards incontournables et de « legacy applications » (des applications anciennes que l’on doit faire fonctionner dans un environnement moderne).

Comment imaginer que le modèle centré sur les applications, dominant aujourd’hui, puisse être remplacé par celui du Star, centré sur les documents, sans rupture majeure ? Comment imaginer que le Web puisse devenir un vrai média pour la collaboration distante sans remettre en cause les protocoles existants ? Ces ruptures sont pourtant nécessaires, car les interfaces actuelles atteignent leurs limites : elles génèrent leur propre complexité d’utilisation et détournent l’utilisateur de l’objet de sa tâche, elles ne tirent pas parti des capacités d’action, de perception et de communication des utilisateurs humains, elles ne sont pas adaptées à leurs contextes d’utilisation.

Entre les risques d’une telle régression et les promesses des interfaces à base d’agents intelligents, de langage naturel, d’Ubicomp et de réalité augmentée, l’IHM devra se frayer un chemin tandis que les chercheurs, entre évolution et révolution, continuent à inventer le futur.

- Berners-Lee, T. et al (1994) “The World Wide Web,” Communications of the ACM, 37(8):76-82, August 1994.

- Bolt, R.A, (1980) “Put-That-There: Voice and Gesture at the Graphics Interface,” ACM SIGRAPH Compututer Graphics 14::3 262-270, 1980.

- Bush, V. (1945) “As We May Think.” The Atlantic Monthly, 1945. 176(July): pp. 101-108. Reprinted and discussed in ACM interactions, 3(2), March 1996, pp. 35-67.

- Callahan, J., Hopkins, D., Weiser, M. & Shneiderman, B. (1988) “A Comparative Analysis of Pie Menu Performance,” Proc. ACM Human Factors in Computing Systems, CHI’88, Washington D.C., pp. 95-100, ACM.

- Engelbart, D.C (1962) “Augmenting Human Intellect: A Conceptual Framework”, Summary Report, Stanford Research Institute, on Contract AF 49(638)-1024, October 1962, 134 pages.

- Engelbart, D.C (1968) “A Research Center for Augmenting Human Intellect”, (90-min. video recording) live online hypermedia demonstration/presentation at the Fall Joint Computer Conference, San Francisco, CA, December 9, 1968.

- Johnson, J. et al (1989) “The Xerox « Star »: A Retrospective”, IEEE Computer, September 1989. Reprinted in Buxton, W. et al , Human Computer Interaction: Toward the Year 2000, Morgan Kaufman.

- Kurtenbach, G. & Buxton, W (1991) “The Limits of Expert Performance Using Hierarchic Marking Menus,” Proc. ACM Human Factors in Computing Systems, INTERCHI’93, Amsterdam., pp.482-487, ACM.

- Krueger, M (1983) Artificial Reality, Addison-Wesley, 1991.

- Krueger, M. (1985) “VIDEOPLACE: A Report from the Artificial Reality Laboratory,” Leonardo, 18(3):145-151, 1985.

- Myers, B. (1992) “A brief history of human-computer interaction technology”, ACM interactions , 5(2):44-54, March/April 1998.

- Nelson, T. (1992) Literary Machines 93.1. Sausolito: Mindful Press, 1992.

- Perkins, R., Keller, D.S. & Ludolph, F (1997) “Inventing the Lisa User Interface”, ACM Interactions, jan-Feb 1997, 41-53.

- Raskin, J. (2000) The Humane Interface, Addison Wesley, 2000.

- Shneiderman, B. (1983) “Direct manipulation: a step beyond programming languages,” IEEE Computer 16(8) (August 1983), 57-69.

- Smith, D.C., et al (1982) “The Star User Interface: an Overview”, in Proceedings of the 1982 National Computer Conference. 1982. AFIPS. pp. 515-528.

- Sutherland, I.E. (1963) “SketchPad: A Man-Machine Graphical Communication System”, in AFIPS Spring Joint Computer Conference, 23. pp. 329-346.

- Weiser, M. (1991) “The Computer for the Twenty-First Century,” Scientific American, 265(3):94-104, September 1991.

- Wellner, P., Gold, R. & Mackay, W. (1993) Special issue on computer-augmented environments, Communications of the ACM , 36(7), July 1993.

| Histoire de l’informatique | The Machine That Changed the World | |

| Histoire de l’IHM | A Brief History of Human Computer Interaction Technology Howard Rheingold’s Tools For Thought |

|

| Sketchpad | Sketchpad: A man-machine graphical communication system Early HCI Research by the Lincoln Lab TX-2 Group |

|

| NLS/Augment | Doug Engelbart’s Biography 1968 Demo by Doug Engelbart |

|

| Xerox Star | Xerox Star, a Retrospective Xerox Star Historical Documents (courtesy Dave Curbow) Vidéos du Star sur YouTube Bruce Damer’s Personal Histories of the Desktop User Interface Biographie de Alan Kay Alan Kay au Viewpoints Research Institute |

|

| Apple | apple-history.com The Apple Museum Jef Raskin |

|

| VisiCalc | History Introduction by Dan Bricklin | |

| World Wide Web | A Little History of the World Wide Web Histoire du Web sur World Wide Web Foundation Histoire de l’hypertexte par Jakob Nielsen |

|

| Pie Menus | The Design and Implementation of Pie Menus |

Newsletter

Le responsable de ce traitement est Inria. En saisissant votre adresse mail, vous consentez à recevoir chaque mois une sélection d'articles et à ce que vos données soient collectées et stockées comme décrit dans notre politique de confidentialité

Niveau de lecture

Aidez-nous à évaluer le niveau de lecture de ce document.

Votre choix a été pris en compte. Merci d'avoir estimé le niveau de ce document !