D’une informatique centralisée aux réseaux généraux : le tournant des années 1970

Au début des années 1960, le paysage informatique est dominé par de gros calculateurs, qui fonctionnent en local : les informations sont fournies à l’entrée par une carte perforée, ou un ruban magnétique, manipulés par des opérateurs, et on recueille les informations à la sortie.

Comme l’écrit R. Rocquet en 1962 dans la Revue des PTT de France : « Il s’agit donc d’une machine desservie par quelques spécialistes, remplaçant dans les locaux même d’une entreprise un service de secrétariat, de comptabilité, ou de bureau technique. »

1. De l’idée de transmettre des données à celle des réseaux d’ordinateurs

Ce fonctionnement est simple quand les terminaux et l’ordinateur sont au même endroit, mais cela limite leur utilisation. Pour travailler à distance, les cartes perforées ou les bandes magnétiques sont expédiées par la poste ou par coursiers. Dès la fin des années 1950 et le début des années 1960 toutefois, les administrations des Télécommunications offrent la possibilité de transférer automatiquement les données au moyen de lignes spécialisées (télégraphiques, télex, téléphoniques). L’introduction de ces moyens de télécommunications permet un changement majeur : une transmission presque instantanée entre deux lieux distants. On parle alors de transmission de données.

À la fin des années 1960, le transfert point à point entre calculateurs laisse progressivement place à des réseaux commutés équipés de modems. Les calculateurs sont connectés à des lignes de télécommunications pour accéder à des terminaux. Ceci implique le couplage de deux techniques et de deux types de messages différents, puisque le réseau téléphonique transmet des données alphanumériques et le calculateur des données numériques (code binaire), cette difficulté étant contournée par des modems.

Temps partagé et partage d’informations

Deux axes de réflexion féconds se développent en parallèle. Les recherches portent d’une part sur une utilisation collective, partagée de la machine, l’utilisateur mettant au point ses programmes en ignorant que de nombreux autres utilisateurs se servent de la machine dans le même temps. D’autre part, il s’agit de permettre une utilisation collective, partagée, des programmes de traitement et des informations, qui ouvre à des non-informaticiens l’utilisation de l’ordinateur.

Les systèmes d’utilisation partagée des ordinateurs autorisent plusieurs programmeurs à utiliser la machine en même temps, alors qu’avec le traitement par lots les temps de réponses étaient longs et les machines sous-exploitées. Les premiers pas dans le temps partagé sont effectués par le projet CTSS (Compatible Time-Sharing System) au MIT, puis la réalisation du PDP 1, et au début des années 1970 l’apparition des machines IBM 370.

Le temps partagé a marqué toute la génération d’ingénieurs des années 1960-1970.

Alors que le traitement par lots (batch processing) domine les années 1950, ses possibilités sont limitées : un lot (c’est-à-dire une tâche à exécuter) ne démarre que si le traitement du précédent a été accompli. La longueur du temps de réponse (parfois une journée) est un inconvénient majeur. Les traitements sont donc souvent effectués la nuit ou demandés à la veille des week-ends.

L’ordinateur ne peut pas être utilisé par plusieurs personnes à la fois. En général, il est contrôlé par « l’opérateur » et il devient le symbole d’une informatique lourde, à laquelle les chercheurs que sont John McCarthy, Herbert Teager, Jack Dennis ou Fernando Corbató vont chercher à mettre fin. Avec le temps partagé, chaque utilisateur se voit allouer la machine régulièrement pendant un laps de temps déterminé, ce qui rend les temps de traitement plus courts mais permet aussi l’accès direct des utilisateurs aux ordinateurs, sans nécessairement passer par l’opérateur, et une informatique plus « interactive ». Le partage des machines ainsi permis est ensuite associé au partage des informations.

Le projet MAC est mené à partir de 1963 au Massachusetts Institute of Technology. Il s’agit de rendre l’ordinateur accessible aux utilisateurs de n’importe quel endroit du MIT. Fernando Corbató est l’un des bénéficiaires du projet MAC, qui lui permet de financer CTSS (Compatible Time-Sharing System). CTSS devient le principal support technique du projet, qui bénéficie à partir de 1967 d’un cadre spécifique au MIT, le MAC laboratory.

Ce projet préfigure Arpanet par sa vision d’une informatique interactive et du partage des ressources, rendant possibles les communications entre chercheurs, les « communautés en ligne ».

Terminaux du réseau SABRE.

Photo Archives IBM.

En ce qui concerne le partage d’informations, la puissance de calcul étant un élément coûteux, le système en ligne (on line system), vise à ce que plusieurs utilisateurs partagent les mêmes données et programmes. Ce concept est défini au Massachusetts Institute of Technology par Wesley Clark en 1954.

Plusieurs utilisateurs à des kilomètres de distance, par exemple des employés à partir d’un terminal, partagent des informations et traitent des problèmes identiques. C’est le cas dans le réseau SABRE tourné vers les réservations aériennes.

Dans les années 1960, les utilisateurs cherchent donc à soumettre des travaux à distance et à saisir les données en temps réel, à s’affranchir du « support papier » en entrée.

En 1946-1947, le Whirlwind, projet de simulateur de vol, commence à être développé par une petite équipe autour de Jay Forrester, au sein du laboratoire de servomécanisme du Massachusetts Institute of Technology. Ce « rêve de physicien et cauchemar d’ingénieur », pour reprendre l’expression de Philippe Breton, doit voir la réalisation d’un ordinateur capable d’effectuer plusieurs fonctions en temps réel. Il s’achève en 1957, avec l’arrêt de ses financements, mais apporte de multiples innovations (première mémoire à tores de ferrite, premier affichage des résultats sur un terminal graphique, utilisation d’un crayon électronique, premier ordinateur opérant à partir de données numériques provenant d’une ligne téléphonique, etc.). Il va devenir ensuite une pièce maîtresse du réseau SAGE (Semi-Automatic Ground Environment), système américain de défense aérienne.

Le système SAGE joue un rôle essentiel dans l’évolution de la conception des réseaux et de l’informatique des années 1960, en apportant des avancées majeures dans le domaine de la programmation, notamment des compilateurs et langages d’assemblage, ou dans la voie du temps partagé.

Vers la fin des années 1950 et le début des années 1960, des compagnies d’aviation, des multinationales et des usines commencent à se doter de systèmes de téléinformatique et de télétraitement pouvant être utilisés simultanément par plusieurs usagers.

C’est par exemple le début des systèmes automatiques de réservation de billets d’avion. Une des premières applications d’importance est SABRE (Semi-Automatic Business-Related Environment), modèle réduit du réseau SAGE destiné, cette fois dans le domaine civil, aux applications de réservation aérienne développées sur IBM 7094 par IBM et American Airlines entre 1956 et 1962. Ce réseau permet le partage d’informations. Les utilisateurs ne sont pas forcément des informaticiens, les opérations sont prédéterminées, les réponses quasi immédiates.

Enfin, le temps partagé permet une véritable interaction entre l’homme et la machine, mise simultanément au service de plusieurs utilisateurs.

Des réseaux centralisés

Comme le rappelle Louis Pouzin dans un article de La Recherche de février 2000 intitulé « Cyclades ou comment perdre un marché » : « Dans les années 1970, le modèle de l’époque relevait du jacobinisme parfait : un ordinateur central était relié à quelques centaines de terminaux par le moyen de circuits téléphoniques loués aux PTT. Pour le reste, il s’agissait d’exploiter au maximum les vertus du temps partagé : le calculateur répondait, tour à tour, à chacun des terminaux. Le résultat donnait des vitesses de transmission qui se situaient autour de 30 à 240 caractères par seconde. »

La structure des réseaux est alors de type étoilé, c’est-à-dire que les échanges d’informations ont lieu entre l’ordinateur central et un terminal particulier. Habituellement, il n’y a pas d’échanges entre les terminaux eux-mêmes. Puis naît l’idée d’interconnecter les différents terminaux, ce qui permet l’apparition de réseaux spécialisés.

L’évolution vers une informatique en réseaux, répartie, décentralisée, aux « terminaux intelligents », n’est cependant pas naturelle ou évidente. À une informatique centralisée, où règne l’incompatibilité entre les calculateurs, la recherche en téléinformatique va chercher à substituer une informatique en réseaux qui implique progressivement la compatibilité des ordinateurs.

2. Arpanet et Cyclades : des pionniers dans la voie des réseaux généraux

En 1966, Lawrence Roberts prend en charge, au sein de l’IPTO (Information Processing Techniques Office) créé en 1962 à l’ARPA, Advanced Research Projects Agency, la construction d’un réseau informatique, Arpanet. Ses choix techniques font la synthèse des apports du projet MAC, des travaux sur la transmission par paquets, des avancées du temps partagé, mais aussi du temps réel.

Larry Roberts est un des premiers à avoir entrepris, avec Thomas Marill<, de relier deux ordinateurs de types différents. Aussi inscrit-il dans les principes d’Arpanet de mettre fin aux structures centralisées des réseaux en interconnectant une grande variété d’ordinateurs de constructeurs différents (IBM, DEC, General Electric ou Univac), présents sur les sites universitaires liés à l’ARPA.

Il s’agit d’une connexion à grande distance entre ordinateurs de types différents. Ce n’est pas à proprement parler un réseau, mais un premier pas vers ce qui devient ensuite, dans Arpanet, un réseau hétérogène. Cette recherche débouche en 1965 sur la première connexion entre deux ordinateurs : le TX-2 du Lincoln Laboratory et un Q-32 d’IBM à Santa Monica.

Des hommes de réseaux

La conceptualisation de ce projet commence en 1967. La même année est formé le NWG (Network Working Group), dirigé au début par Stephen Crocker. Toute une équipe se constitue pour donner naissance à l’ambitieux projet Arpanet de construction d’un réseau d’ordinateurs hétérogènes reposant sur la commutation de paquets. Travaillent à sa réalisation des pionniers dans le domaine des réseaux tels Leonard Kleinrock, d’anciens camarades de Larry Roberts d’UCLA, quelques étudiants parmi lesquels figurent les futurs grands noms de l’aventure internet comme Vinton Cerf et Jon Postel.

Robert Kahn rejoint également l’équipe en 1968, par le biais de la firme de consultants BBN (Bolt Beranek and Newman), qui décroche le contrat avec l’Arpa pour créer des IMP, Interface Message Processors, rendant possible la communication entre ordinateurs hétérogènes. Le réseau démarre réellement en 1969. Il dispose alors de quatre connexions entre universités aux Etats-Unis (à UCLA, au Stanford Research Institute, à l’University of California at Santa Barbara, et à l’Université d’Utah).

|

|

|

| Un IMP (Source : Internet Pioneers). | Le réseau Arpanet en 1969. Schéma des connexions entre les quatre sites (Source : Computer History Museum). |

En 1971, alors que commencent à se définir les recherches françaises sur Cyclades, Arpanet compte 15 nœuds aux Etats-Unis. La première liaison internationale a lieu en 1973 avec UCL (University College of London).

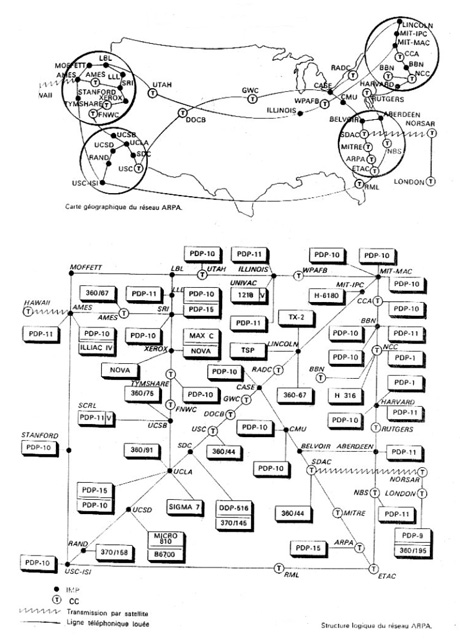

Le réseau Arpanet en 1975

Bulletin particulier de renseignement scientifique et technique du 2 juillet 1975.

En haut, carte géographique du réseau ; en bas, sa structure logique.

Lors de la conférence internationale sur les communications informatiques en 1972 (ICCC72), la première démonstration publique d’Arpanet, organisée par Robert Kahn, donne une vue générale des chercheurs et équipes intéressés par les réseaux.

Selon les souvenirs de Vinton Cerf, « Cette conférence a rassemblé un ensemble de gens : Donald Davies du National Physical Laboratory britannique, qui avait mené des travaux sur la commutation de paquets concurrents de ceux du DARPA ; Rémi Després qui était impliqué dans le réseau français de communication par paquets (RCP) et plus tard Transpac, leur réseau commercial X25 ; Larry Roberts et Barry Wessler, qui tous deux rejoignirent et dirigèrent ensuite le réseau Telenet de BBN ; Gesualdo LeMoli, un chercheur italien sur les réseaux ; Kjell Samuelson de l’Institut royal suédois ; John Wedlake de British Telecom ; Peter Kirstein de l’University College London ; Louis Pouzin qui dirigeait le projet de recherche Cyclades/Cigale sur les réseaux à commutation de paquets à l’Institut de recherche en informatique et automatique […]. Roger Scantlebury de NPL accompagnait peut-être Donald Davies. Il y avait sûrement aussi Alex McKenzie de BBN. »

Parmi les chercheurs qui assistent aux démonstrations, sont présents deux Français : Rémi Després qui développe au Centre national d’études des télécommunications (Cnet) le projet RCP, qui évoluera ensuite vers Transpac, et Louis Pouzin, maître d’œuvre du projet Cyclades à l’IRIA. Ce projet-pilote a été lancé en 1971 sur l’initiative de Maurice Allègre, alors Délégué à l’Informatique.

Une nouvelle vision des réseaux d’ordinateurs : d’une informatique « propriétaire » aux réseaux généraux

« L’informatique ne connaissait jusqu’alors que deux formules, intégration centralisée, ou décentralisation dispersée. Les réseaux en apportent une troisième : intégration décentralisée, ou informatique répartie. » Ainsi se résume en 1975 le principe qui guide le projet-pilote Cyclades.

Au début des années 1970, aucune politique globale n’existait, et quelques constructeurs d’ordinateurs avaient proposé des architectures complètes de réseau spécifiques comme Decnet de Digital Equipement Corporation, et Systems Network Architecture (SNA) d’IBM. Chaque constructeur informatique adopte en interne des standards qui lui sont propres. Dès lors, la clientèle est captive d’une seule source d’approvisionnement.

Les équipes Arpanet ou Cyclades proposent une alternative : un réseau conçu pour pouvoir supporter des ordinateurs et des terminaux de toute sorte (hétérogénéité), tout en offrant un ensemble de conventions (protocoles) permettant à des systèmes hétérogènes de dialoguer.

L’équipe qui conçoit le réseau Cyclades à l’IRIA (puis INRIA) de 1971 à 1979, date d’extinction du réseau, va pousser la réflexion théorique dans deux voies fondamentales. Il s’agit de construire un réseau à commutation de paquets, fondé sur des datagrammes, c’est-à-dire sur un format de paquets dont l’en-tête contient toutes les informations nécessaires à leur acheminement, pour que ces blocs de données soient envoyés indépendamment les uns des autres. Il s’agit aussi de construire un « réseau universel », pour permettre l’insertion dans le réseau de machines de constructeurs différents.

Cette idée repose sur un certain pragmatisme : le réseau Cyclades doit avoir des liens avec les matériels de la Compagnie internationale pour l’informatique (CII), qui est une entreprise française, dans le contexte du « Plan Calcul » qui vise à stimuler l’industrie nationale. Mais les ingénieurs prennent aussi en considération le fait que les futurs réseaux ne seront pas constitués exclusivement d’équipements CII, tant au plan national qu’au plan international, alors qu’IBM occupe une place dominante sur le marché mondial. Or IBM a développé en 1974 une architecture propriétaire, Systems Network Architecture (SNA), qui limite l’extension d’un réseau à ses propres calculateurs. En luttant contre SNA, et en démontrant qu’un réseau peut accueillir des machines de constructeurs différents, l’équipe Cyclades peut envisager de faire de la place aux matériels CII.

Dans les années 1960, IBM occupe une position dominante.

Graphique réalisé d’après INRIA, 88.16.014.

Cyclades, une copie d’Arpanet ?

Le projet Arpanet est bien connu des Français. Louis Pouzin effectue fin octobre 1972 la visite d’une dizaine de centres participant au réseau Arpanet, essentiellement orientés sur les protocoles. Il reçoit une documentation abondante émanant des Etats-Unis, notamment les documents techniques produits par Bolt Beranek and Newman.

L’équipe Cyclades a des liens contractuels avec l’entreprise Bolt, Beranek and Newman, chargée de la réalisation des IMP (Interface Message Processors), c’est-à-dire des mini-ordinateurs qui forment les nœuds du sous-réseau à commutation de paquets et sont reliés aux ordinateurs hôtes des Arpa’s contractors. Les chercheurs de l’ARPA et de Cyclades se rencontrent dans le cadre de l’INWG (International Network Working Group), présidé par Vinton Cerf. En 1974, Louis Pouzin y préside le sous-comité sur les protocoles. Gérard Le Lann, envoyé à Stanford en 1973 auprès de Vinton Cerf, est un intermédiaire également dans les contacts IRIA-Arpanet. Toutefois, aucune liaison ne sera effectivement mise en place entre Cyclades et Arpanet, même si l’idée a été évoquée en 1972.

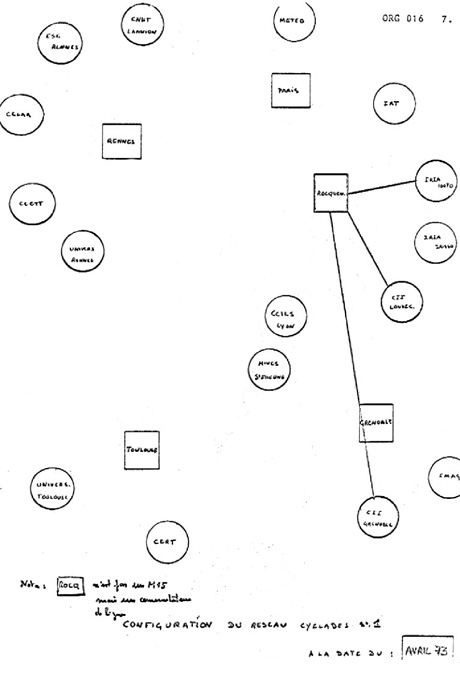

Le réseau Cyclades en avril 1973.

Toutefois, le projet Cyclades n’est pas une simple réplique de celui mené aux Etats-Unis, et ce pour plusieurs raisons. Tout d’abord, le projet Arpanet lui-même n’est pas figé et subit des évolutions, en particulier à partir de 1972, lorsque Vinton Cerf et Robert Kahn s’associent pour définir un nouveau protocole face au premier protocole d’Arpanet, NCP (Network control program), jugé trop « primitif ».

À la suite de séminaires organisés par Vinton Cerf sur les questions de protocoles, celui-ci et Robert Kahn publient en 1974 un article qui définit TCP (Transmission Control Protocol) , qui évolue ensuite en TCP/IP (Transport Control Protocol et Internet Protocol) et remplace NCP. L’idée est de pouvoir connecter et faire communiquer de nombreux réseaux indépendants de conception différente et même des réseaux radio ou satellites utilisant les paquets, ce que ne permettait pas NCP.

Dans un entretien avec Judy O’Neill en 1990, Vinton Cerf évoque deux éléments apportés par l’équipe Cyclades, les datagrammes purs et les « fenêtres ».

Le principe des fenêtres ou windowing concerne la numérotation des paquets introduits dans le réseau. Cette fenêtre plus ou moins longue incorpore les éléments de numérotation des paquets et des accusés de réception qui circulent.

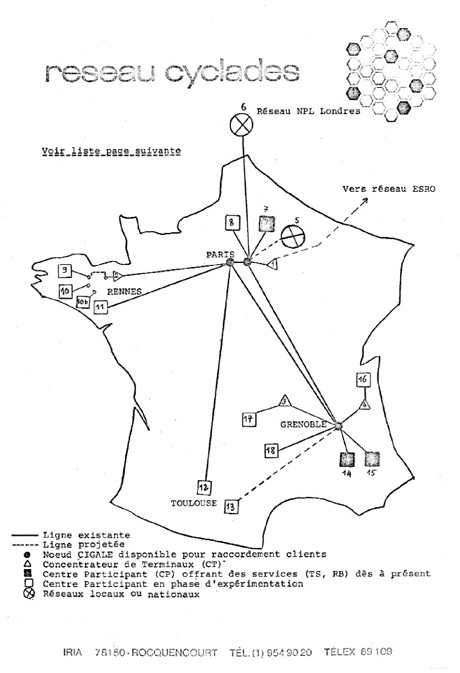

Le réseau Cyclades en janvier 1975

INRIA, Armoire des projets pilotes, Dossier Cyclades, ORG 554, janvier 1975.

Quant aux datagrammes purs, c’est aussi sur eux que repose TCP/IP, ce qui vaut au maître d’œuvre de Cyclades, Louis Pouzin, d’être honoré au Sigcomm 1997 aux côtés de Jon Postel. Dans un échange de courriers électroniques avec David Reed, Vinton Cerf le qualifie de « gourou des datagrammes ».

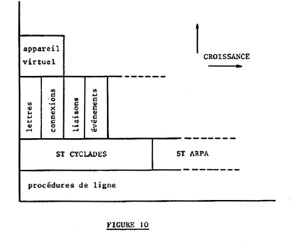

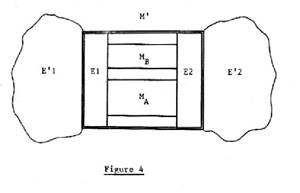

Une architecture de réseau en couches

Vinton Cerf mentionne aussi Hubert Zimmermann, autre membre de l’équipe de l’IRIA, comme étant le concepteur de la première version de l’architecture OSI. L’équipe française va en effet aussi se distinguer par son travail sur les architectures de systèmes ouverts bâties selon un système de couches.

Déjà dans SNA, le principe des couches est appliqué, mais il est systématisé dans Cyclades. C’est la seule manière, selon Louis Pouzin et son équipe, de pouvoir faire évoluer, d’une part les applications, d’autre part les systèmes de communications, pour tenir compte des améliorations futures de la technologie.

|

|

| L’architecture en couches dans Cyclades INRIA, Armoire des projets pilotes, dossier Cyclades, SCH 72, juillet 1973. |

|

La conception de Cyclades se double d’une politique très vive en faveur d’une normalisation internationale, car seuls des standards internationaux peuvent, aux yeux de l’équipe, apporter une alternative crédible à la « dominance IBM ».

3. Vers des standards « de fait » ou « officiels » ?

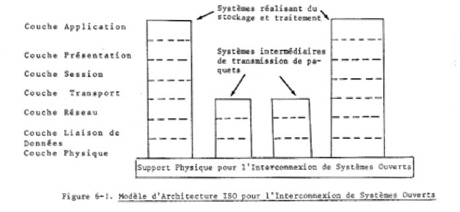

Les membres de l’équipe Cyclades mènent une intense action en faveur de la normalisation des architectures de réseaux au plan international à l’ISO (International Standard Organization). Ils contribuent ainsi à ce qui deviendra l’Open Systems Interconnection, une architecture de réseau en sept couches.

Modèle d’architecture ISO pour l’Interconnexion de Systèmes Ouverts

INRIA, 86.007.007, Hubert Zimmermann, « Les réseaux informatiques », SCH 620.1, octobre 1979.

La recherche de standards informatiques officiels

L’OSI (Open Systems Interconnection) est un cadre de référence couvrant l’ensemble des normes des protocoles de communication qui doivent être mis en œuvre pour l’interconnexion de systèmes hétérogènes. Si les travaux sur l’OSI ne débutent qu’en 1977, les réflexions étaient engagées et débattues dès l’année 1972, dans un groupe de travail appelé INWG (International Network Working Group), rattaché en 1974 à l’International Federation for Information Processing (IFIP), et présidé par Vinton Cerf. Il s’est donné comme objectif de proposer des bases de standardisation aux organismes compétents. En avril 1975, le groupe de travail compte une liste de 130 membres, et se concentre sur les expériences Arpanet, Cyclades et le réseau du National Physical Laboratory britannique. Les réflexions de l’International Network Working Group vont amener des propositions à l’ISO qui aboutissent à un effort de réflexion sur les standards et les architectures de réseaux.

En 1977 est donc créé à l’ISO, au sein du comité 97 responsable de la normalisation informatique, le sous-comité 16 « interconnexion des systèmes ouverts ». Cette création suscite des débats sur l’interprétation de cette normalisation : faut-il normaliser une « interconnexion des systèmes ouverts » ou une « architecture des systèmes ouverts » ? C’est la première notion qui l’emporte, car il ne s’agit pas de normaliser le comportement interne d’un système d’exploitation. Les experts de l’OSI définissent des services génériques et vont établir sept couches, quatre couches « transport » et trois couches « applications ». En cela, ils se démarquent du protocole X25 adopté par exemple dans Transpac, qui ne ne concerne que la couche transport dans les réseaux à commutation de paquets reposant sur des circuits virtuels.

Défini en 1976 au CCITT (Comité consultatif international téléphonique et télégraphique), le protocole X25 est un pas supplémentaire dans la normalisation. Issu du monde des télécommunications, il ne concerne toutefois que la couche transport dans les réseaux à commutation de paquets reposant sur des circuits virtuels.

Il comporte trois niveaux :

- l’interface physique et électrique

- la procédure de ligne dite HDLC (High Level Data Link Control)

- la procédure pour l’échange des paquets

X25 n’a aucun caractère impératif, il s’agit d’une recommandation, qui va toutefois connaître une large implantation, grâce à un consensus qui se dégage autour de son adoption dans Transpac, Datapac (réseau canadien) ou Euronet. X25 est inséré dans l’OSI mais ce protocole ne suffit pas à assurer un réseau hétérogène, il décrit un service de transport basé sur les circuits virtuels, mais ne concerne que le niveau transport et n’apporte rien en matière de contrôle de bout en bout, ni de gestion de terminaux.

Une mise en œuvre longue

Stabilisé à l’ISO dès 1982, le modèle de référence de base de l’OSI est officiellement publié par l’ISO en 1984, mais le programme de normalisation internationale est abandonné au cours des années 1990. Parmi les freins, peuvent être relevées une prolifération de normes de fait, en particulier TCP/IP, la tentation de normes transitoires (au Royaume-Uni avec les coloured books ou MAP aux Etats-Unis), et la lenteur et la complexité du processus de normalisation. L’OSI a tendance à devenir une « tour de Babel ».

L’équipe Arpanet est restée effacée dans la définition de l’OSI, alors qu’elle a initié la réflexion dans le cadre de l’International Network Working Group. Janet Abbate note à ce sujet dans Inventing the internet : « Le fait que les protocoles de l’internet n’avaient pas été élaborés par un comité officiel de standardisation, combiné au fait qu’ils venaient des États-Unis, qui dominaient déjà le marché des ordinateurs, rendait impossible, sur le plan politique, leur acceptation par l’ISO comme standards pour les systèmes ouverts. » Rappelons aussi la philosophie exposée par David Clark du MIT en 1992, pour le 24e anniversaire de l’Internet Engineering Task Force :« We reject kings, presidents and voting. We believe in rough consensus and running code », phrase difficile à traduire qui signifie à peu près : « Nous rejetons les rois, les présidents et le vote. Nous croyons au consensus approximatif et au code qui fonctionne ».

En tout état de cause, dès 1974, Louis Pouzin a eu une vision prémonitoire. « En matière de standards, il ne faut pas s’attendre à une approbation officielle avant longtemps, car il y a encore une majorité de pays qui n’ont aucune expérience, ni même de compréhension du sujet. Par contre, il y aura d’ici un an (2 ans au plus), des standards de fait, qui tiendront lieu de modèles », écrit-il à Maurice Allègre. Il a pressenti que les standards de fait (TCP/IP) seraient plus puissants que les standards officiels (OSI) dans cette course à la normalisation.

Le bouillonnement d’idées et d’expérimentations dans les années 1970 a fait prendre conscience de la nécessité de l’interconnexion des réseaux. Il a ainsi conduit, par l’adoption du protocole TCP/IP, devenu un standard de fait, à la naissance d’Internet.

- ABBATE J ., Inventing the internet, MIT Press, juillet 2000, 272 p.

- BRETON P., Histoire de l’informatique, Paris, La Découverte, 1987, 239 p.

- CERRUZI Paul E. A History of Modern Computing, Cambridge, The MIT Press, 1998, 398 p.

- DROMARD D., L’architecture SNA, Eyrolles, Paris, 1989, 215 p.

- MOREAU R., Ainsi naquit l’informatique : histoire des hommes et des techniques, Paris, Bordas, 4ème éd., 1987, 223 p.

- POUZIN L., « Cyclades ou comment perdre un marché », La Recherche, n° 328, février 2000.

- SERRES A., Aux sources d’Internet : l’émergence d’Arpanet, Thèse de Doctorat en Sciences de l’Information et de la Communication, Université Rennes 2, 2000, 2 vol., 676 p.

Newsletter

Le responsable de ce traitement est Inria. En saisissant votre adresse mail, vous consentez à recevoir chaque mois une sélection d'articles et à ce que vos données soient collectées et stockées comme décrit dans notre politique de confidentialité

Niveau de lecture

Aidez-nous à évaluer le niveau de lecture de ce document.

Votre choix a été pris en compte. Merci d'avoir estimé le niveau de ce document !

Valérie Schafer

Historienne, chargée de recherche CNRS à l'Institut des sciences de la communication.