La conscience d’une machine

Une première version de cet article est parue dans le dossier n°87 Les robots en quête d’humanité de la revue Pour la Science, numéro d’avril/juin 2015.

Dans les années 1970, le psychologue américain Gordon Gallup a mis au point le test du miroir. L’idée est d’estimer la conscience de soi chez un animal, y compris un humain, en lui apposant subrepticement une marque sur le front. Face à un miroir, quand l’individu essaie de toucher, d’enlever la trace ou fait simplement mine d’avoir noté le changement, on en conclut qu’il est conscient de son propre corps. À ce jour, les espèces qui ont passé avec succès le test du miroir sont les chimpanzés, les bonobos, les orangs-outans, les dauphins, les éléphants, les corbeaux… Les bébés y parviennent à partir de 18 mois. Et les robots ?

Certains robots sont-ils conscients ? Peut-on imaginer qu’ils le seront ? Et si ce n’est pas le cas aujourd’hui, les robots pourraient-ils un jour le devenir ? De fait, rien n’interdit a priori de modéliser ce qui existe dans la Nature, puis de le formaliser et de l’intégrer dans une machine. Qui plus est, l’intérêt d’une telle question, celle de l’émergence d’une forme de conscience de soi chez les robots, est multiple.

Conscience sans consensus

D’abord, grâce à des modèles, on comprendrait mieux la notion de conscience elle-même, qu’elle soit naturelle ou artificielle. Ensuite, dotés d’une conscience, les robots interpréteraient plus efficacement leur environnement : leurs décisions et leurs interactions avec les êtres humains s’amélioreraient. Enfin, en s’intéressant au développement de la conscience et des capacités d’apprentissage d’un robot, on cernerait mieux le même processus chez l’enfant.

Avant de s’intéresser à la conscience chez les robots, examinons ce que les psychologues, les philosophes et les neurobiologistes en disent. En psychologie et en neurosciences, de nombreux travaux s’attachent à décrire les mécanismes et les propriétés des processus conscients mis en jeu pendant certains de nos comportements de tous les jours. Ces chercheurs étudient également comment certains comportements et perceptions du monde peuvent s’accomplir de façon automatique sans que nous en ayons conscience.

Les applications cliniques sont importantes, comme par exemple déterminer, à partir de l’observation de l’activité cérébrale, les chances d’un patient en coma végétatif de redevenir conscient. En outre, ces travaux aident à mieux comprendre et définir la conscience. En effet, aucun consensus n’existe quant à sa définition ni si d’autres espèces que l’humain en sont dotées.

On a longtemps cru qu’elle se limitait à la capacité de se concevoir et de s’identifier soi-même comme un être distinct des autres individus et du monde. Le simple fait de se reconnaître dans un miroir suffisait alors à mettre en évidence une conscience (voir la figure ci-dessus). Cependant, les spécialistes se sont rendu compte que l’identification de soi-même n’est qu’une partie du processus.

Les cinq niveaux de conscience

Des psychologues, tel Philippe Rochat, ont proposé de distinguer jusqu’à cinq niveaux de conscience de soi, ces niveaux se développant progressivement au cours de l’enfance. Dans ce cadre, l’identification de soi-même évaluée par le test du miroir ne constitue que le troisième niveau, et apparaît vers 18 mois chez l’être humain.

Dans le test du miroir, le robot peut se reconnaître, notamment en détectant que les mouvements sur le miroir sont simultanés et synchronisés avec les siens.

© ISIR-CNRS-UPMC/N. Aklil/M. Khamassi/E. Renaudo

Par ailleurs, des éthologistes ont récemment montré que les grands singes, les dauphins ou encore les éléphants sont capables d’une certaine identification d’eux-mêmes et, en conséquence, réussissent le test du miroir. Des espèces inattendues, tels les perroquets et les pies, semblent également réussir le test du miroir sans qu’on puisse dans leur cas parler rigoureusement de conscience de soi.

D’autres chercheurs ont affiné la distinction des niveaux de conscience. Ainsi, Alain Morin a mis l’accent sur l’importance de se savoir l’agent de ses propres actions, de ses propres pensées, et de se voir soi-même comme inscrit dans le temps, avec un début, une fin et une continuité entre les deux, donc capable d’avoir une mémoire autobiographique. Nous verrons comment les robots peuvent aussi être concernés.

Quant à eux, les neurobiologistes soulignent qu’un niveau élevé de conscience requiert des capacités d’auto-évaluation et d’autorégulation de son propre comportement. Ces capacités sont particulièrement importantes lors de tâches cognitives nécessitant une adaptation comportementale rapide ou une attention aux stimuli pertinents pour la régulation du comportement. Par exemple, des travaux récents ont identifié plusieurs processus et mécanismes liés à la conscience et mis en jeu lors de diverses tâches cognitives tels la perception, la prise de décision, l’apprentissage, le raisonnement, le langage…

Comment l’accès à la conscience lors d’une tâche de perception visuelle peut-il améliorer la performance ? Comment, à l’inverse, peut-il diminuer la performance en imposant des calculs mentaux longs, coûteux et parfois non nécessaires pour résoudre la tâche ? Ces questions intéressent les neurobiologistes Claire Sergent et Stanislas Dehaene. Leurs résultats sont riches d’enseignements pour les roboticiens.

En effet, des robots qui autorégulent leur comportement et se rendent compte dans quelles conditions des calculs longs et compliqués sont nécessaires pour résoudre un problème gagneraient en autonomie décisionnelle. Le reste du temps, les automatismes comportementaux pré-acquis seraient suffisants. Selon S. Dehaene, l’accès à la conscience est caractérisé par une intégration et une amplification des informations venues de différentes parties du cerveau, qui chacune réalise habituellement séparément, de façon automatique et non consciente, une sous-partie des calculs. Ce peut être le cas de la reconnaissance visuelle, du déclenchement de l’action… Or cette question de l’intégration et du tri d’informations provenant de différents modules est cruciale pour un robot. Un comportement adapté à chaque situation en dépend.

S’inspirer des mécanismes conscients d’intégration de l’information tels qu’ils sont compris en neurosciences améliorerait les architectures cognitives robotiques actuelles. En retour, puisque ces mécanismes neurologiques ne sont pas encore parfaitement compris, un robot peut aider à tester différentes hypothèses.

Enfin, une dernière théorie issue des neurosciences peut éclairer les recherches en robotique. Il s’agit de la théorie de l’information intégrée proposée par Giulio Tononi. Elle propose que le degré de conscience d’un individu se ramène à la quantité d’information intégrée dans son cerveau, c’est-à-dire à la quantité d’information non réductible aux sous-éléments qui la constituent. En d’autres termes, vous ne pouvez pas mettre de côté des informations, par exemple en décidant de mettre en noir et blanc le paysage que vous contemplez.

Le corollaire est qu’on pourrait estimer indirectement le niveau de conscience dans un cerveau à un instant donné en mesurant la quantité d’information intégrée. Une telle mesure est encore impossible dans un cerveau humain, mais elle est accessible dans le « cerveau » artificiel d’un robot. En supposant que le programme de contrôle d’un robot soit un modèle neuromimétique représentatif, le robot peut alors permettre de mesurer le niveau de conscience associé avec l’hypothèse biologique testée.

On peut, par exemple, se rendre compte qu’un robot peut résoudre une même tâche que celle réalisée par les humains, sans pour autant que le degré d’information intégrée soit suffisamment élevé pour qu’on puisse parler de conscience.

Les robots zombies

Le robot peut alors être utile dans son rôle de « zombie ». Expliquons. Le philosophe australien David Chalmers a proposé une expérience de pensée où le rôle principal est tenu par un zombie philosophe (un « p-zombie »). Cet être hypothétique ne peut se distinguer d’un être humain… à part qu’il lui manque la conscience.

Depuis, les spécialistes recourent à ce zombie lorsqu’ils prétendent qu’un certain comportement observé chez l’être humain ne trahit pas nécessairement une conscience sous-jacente. C’est le moyen d’illustrer une autre contribution de la robotique aux neurosciences : on utilise des robots zombies pour mettre en évidence des comportements qui ne nécessitent pas de conscience, nous en verrons quelques exemples.

Revenons vers la recherche en robotique autonome et en intelligence artificielle. Le débat y est vif pour savoir s’il sera possible de rendre les robots conscients. Certains, dont le physicien Roger Penrose, affirment que la conscience est un phénomène lié à la structure même des neurones et qu’il sera donc impossible de la réaliser dans une machine. À l’inverse, selon les tenants d’une hypothèse matérialiste et réductionniste, il n’y a aucun obstacle théorique à ce qu’on finisse par mettre au point des programmes informatiques et des robots conscients d’eux-mêmes. De nombreux travaux sont aussi publiés depuis moins de dix ans dans des revues spécialisées, tel le Journal of Machine Consciousness.

À l’instar du test de Turing proposé pour décider de l’intelligence d’un programme informatique, on peut imaginer concevoir un test pour évaluer la conscience d’un robot. Mais le problème est, nous l’avons vu, que les recherches sur la conscience n’ont pas encore défini de critères rigoureux pour la mesurer.

Au fond, un robot à qui on nie toute conscience et qui néanmoins réussirait des tests conçus pour détecter un certain niveau ou type de conscience, tel le test du miroir, aiderait à raffiner les tests, à les rendre plus restrictifs. De même, on s’est rendu compte que le test de Turing devait être affiné, car des programmes informatiques peuvent le réussir sans être intelligents pour autant (voir l’article Vers une théorie de l’intelligence, par J.-P. Delahaye).

Sans prétendre à l’exhaustivité, détaillons maintenant quelques réussites et échecs de cette quête d’un robot conscient. L’intelligence artificielle classique, dès les années 1970, s’est focalisée sur les fonctions qui semblent requérir des processus mentaux de haut niveau chez les humains. Ce faisant, elle a négligé les mécanismes intégrant la perception, la décision et l’interaction avec le monde réel, avec les contraintes d’incertitude, d’incomplétude et de temps.

Le besoin d’un corps

Ainsi, de nombreux travaux se sont concentrés sur la programmation d’algorithmes pour le raisonnement stratégique, la déduction et l’inférence logiques, ce qui a conduit à des succès, notamment le programme Deep Blue qui a battu Kasparov aux échecs ou plus récemment AlphaGo qui a battu des champions du jeu de go. Dans cette voie, les concepteurs ont trop souvent négligé le degré de sophistication et d’« intelligence » requis dans les interactions sensori-motrices avec le monde. Par exemple, écrire avec un stylo est une tâche loin d’être triviale, qu’un enfant ne maîtrise qu’après plusieurs années d’entraînement.

Le rôle et l’importance du corps dans la cognition ont été oubliés. La robotique a en partie compensé cette lacune, car les robots, machines matérielles, doivent tenir compte de l’imperfection des capteurs, de l’indéterminisme des actions et de la connaissance partielle de leur corps et de l’environnement dans lequel ils évoluent.

Des progrès majeurs ont certes été accomplis dans divers sous-domaines de la robotique (perception, planification, locomotion…), mais ces résultats restent le plus souvent applicables dans des contextes restreints. Aujourd’hui, aucun robot n’est vraiment intelligent, totalement autonome et encore moins conscient. La perception ne permet pas encore à un robot de comprendre et d’interpréter son environnement. La prise de décision reste limitée à des problèmes simples et bien modélisés. Les robots ne comprennent pas le sens de leurs actions et leurs conséquences. Ils ne prennent pas d’initiative.

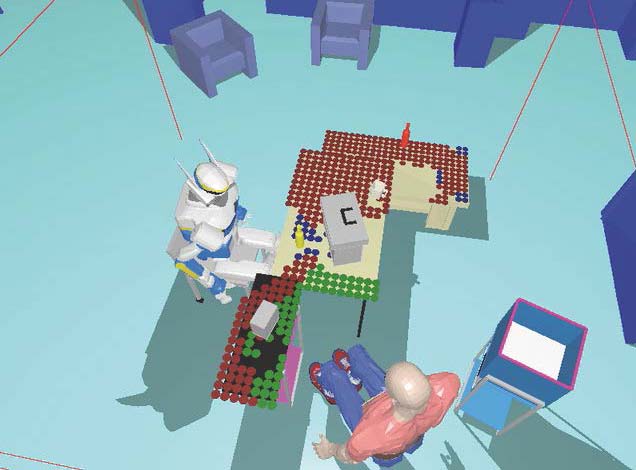

Comment approcher d’un humain une bouteille jaune en tenant compte des capacités de perception et d’action de celui-ci ? Pour accomplir cette tâche, le robot doit élaborer un plan d’action. Il détecte que la bouteille lui est accessible dans la zone bleue, mais pas par l’humain. Il en déduit qu’il doit déplacer l’objet vers une zone accessible à l’humain (en vert). Les zones rouges sont inaccessibles à l’humain.

© LAAS-CNRS

Or chez les êtres vivants, les fonctions cognitives sont liées. La perception donne du sens au monde, en particulier à travers l’action. La décision permet d’effectuer des choix d’actions pour atteindre un état, anticipé sur la base d’un modèle du monde. On peut donc explorer l’idée que l’intégration de diverses fonctions cognitives chez le robot sera nécessaire pour qu’émerge une « conscience de soi ». Dans le même temps, cette conscience de soi peut conduire à une meilleure intégration des capacités cognitives, et donc une meilleure « intelligence ».

C’est le cœur du projet ANR Roboergosum, que nous avons initié avec Benoît Girard, de l’Institut des Systèmes Intelligents et de Robotique (ISIR), à Paris, ainsi que Rachid Alami et Aurélie Clodic, du Laboratoire d’analyse et d’architecture des systèmes, à Toulouse. Nous cherchons à comprendre les mécanismes sous-jacents à l’émergence de la conscience vue comme un processus au centre de l’interaction d’un agent et de son environnement. Nous souhaitons également concevoir un système cognitif où seraient mis en oeuvre et s’exprimeraient ces mécanismes, et donc la conscience elle-même.

Un de nos travaux consiste à tester sur un robot des modèles, inspirés des neurosciences, lui permettant de décider de façon autonome du statut d’une tâche. Est-elle suffisamment familière, répétitive et stable pour que la machine développe des automatismes comportementaux ? De la sorte, elle agirait « sans réfléchir » aux conséquences de l’action. À l’inverse, quand le robot détecte des changements dans la tâche à accomplir, son système d’attention et de délibération reprend la main. Nous avons élaboré une nouvelle architecture cognitive intégrant cette distinction (voir l’encadré ci-dessous).

Le robot PR2 de l’Institut des Systèmes Intelligents et de Robotique est doté d’une architecture cognitive, c’est-à-dire d’une organisation de ses programmes informatiques qui coordonne différents processus cognitifs tels que la perception, l’exécution de l’action, la décision des actions à accomplir pour obtenir des récompenses… L’apprentissage résulte de l’obtention de récompenses de l’environnement et d’une auto-évaluation afin de juger de la pertinence d’une action.

Cette architecture, mise au point par Erwan Renaudo, s’inspire des connaissances de neurosciences en ce qu’elle coordonne plusieurs types de décisions. Les premières sont prises de façon délibérative, en évaluant par un long calcul quelles seraient les conséquences à long terme de leur action ; on parle de comportement dirigé vers un but (centre de planification). En parallèle, le robot peut apprendre, par essais et erreurs, des comportements simples à partir d’associations entre ses actions, lorsqu’un but lui est assigné, et des récompenses qui peuvent en découler (centre d’association). Ces associations se construisent lentement.

Une fois cet apprentissage stabilisé, le comportement du robot est uniquement contrôlé par ce deuxième système de décisions : on parle de comportements habituels parce qu’ils sont automatiques.

L’aptitude du robot à auto-évaluer ses propres décisions lui permet de détecter lui-même quand l’environnement change et qu’il doit interrompre ses habitudes pour délibérer, et quand l’environnement est suffisamment stable pour qu’il puisse faire confiance à ses habitudes.

Le contrôle cognitif

Des modèles ont été proposés pour le « contrôle cognitif », c’est-à-dire surveiller l’environnement et s’auto-évaluer en termes de performances comportementales pour décider quand alterner entre ces deux systèmes décisionnels. Plusieurs mécanismes neurologiques ont été proposés pour modéliser ce processus, mais les réalisations en robotique en ont écarté certains lorsqu’ils sont testés en conditions réelles. En particulier, des hypothèses sur la stabilité des représentations du monde, qui sont calculées par le système de contrôle des comportements dirigés vers un but, ne sont pas valides. On doit donc proposer des mécanismes alternatifs de contrôle cognitif.

Dans ce projet, nous explorons également comment la notion de conscience de soi peut être liée à l’interaction avec d’autres agents qui possèdent leur propre intentionnalité. Le robot permet ici de formaliser et de mettre en oeuvre des éléments de la théorie de l’esprit et des notions d’attention et d’intentions conjointes. Dans ce cas, le robot doit élaborer un plan d’action pour accomplir un objectif conjointement avec un être humain, en construisant en même temps un autre plan (qu’il estime être celui de son partenaire humain) sur la base de sa propre perception des connaissances, des capacités d’action et des objectifs de ce partenaire. Le robot doit ainsi raisonner sur lui-même et sur autrui (voir la figure ci-dessus).

Pour finir, mentionnons des exemples où la robotique contribue à la recherche sur la cognition humaine et sur la conscience en servant de « zombie ». L’idée est de démontrer que certains processus cognitifs peuvent être reproduits sur un robot sans pour autant le rendre conscient. Par exemple, un robot pourrait réussir le test du miroir sans que son programme ne fasse preuve d’une conscience explicite de soi. Ce serait le cas avec un robot voyant son bras bouger dans le miroir et dont le programme informatique reconnaîtrait les choses qu’il voit bouger dans l’environnement comme faisant partie de soi lorsque les mouvements perçus sont corrélés avec les ordres que le robot a envoyés lui-même à ses moteurs.

Ce processus de reconnaissance de soi est de plus en plus étudié en robotique pour mimer le développement des capacités motrices et d’interaction sociale chez l’enfant. Mais de telles corrélations statistiques entre ce qui est perçu par les caméras du robot et ses ordres moteurs peuvent être calculées sans une quelconque notion de conscience de soi. Ici, la mesure du degré d’information intégrée dans le programme informatique du robot apporterait une réponse quantitative et précise sur le degré de conscience attendu en lien avec un tel processus.

Autobiographie d’un robot

Un autre exemple de zombie concerne la mise en œuvre d’une mémoire autobiographique sur un robot humanoïde. Selon les psychologues, la mémoire autobiographique est un élément important de la conscience de la permanence de soi-même à travers le temps. Or, des expériences dans l’équipe de Peter Dominey, à Lyon, ont montré qu’un robot peut accumuler une mémoire des interactions qu’il a eues avec l’environnement et restituer ces éléments autobiographiques sans que l’on puisse parler de conscience chez ce robot. Néanmoins, ce type de mémoire peut être utile pour les capacités de raisonnement du robot.

Enfin, un dernier exemple de zombie robotique révèle qu’un robot peut se construire progressivement un modèle explicite de lui-même et de la structure de son propre corps à partir de régularités sensori-motrices. Dans ce travail de Josh Bongard et Hod Lipson, aux États-Unis, un robot à quatre pattes peut générer des commandes motrices et en observer le résultat pour estimer son modèle. Il peut même adapter son comportement grâce à des mises à jour de ce modèle lorsque le corps du robot change.

Toutefois, un modèle interne, même explicite, peut être construit de façon non consciente : il résulte ici d’une réorganisation dynamique automatique. Le robot se construit un modèle de lui-même sans que celui-ci lui permette une attention introspective ni une subjectivité. Ce sont pourtant des éléments clés de la conscience dans certaines théories.

Les travaux qui visent à modéliser des fonctions cognitives et en particulier la conscience, dont ceux que nous avons détaillés, nous aident à mieux les comprendre. L’ingénierie, et notamment la robotique, peuvent ainsi contribuer à la recherche fondamentale sur la cognition humaine et la conscience. C’est bien le cas lorsque la robotique offre des « zombies » qui démontrent que certains processus cognitifs peuvent être reproduits sur un robot sans que cela soit suffisant pour le rendre conscient. Ces zombies nous conduiront peut-être vers de vrais robots conscients qui interagiront avec nous.

Livres

- S. Dehaene, Consciousness and the brain : Deciphering how the brain codes our thoughts, Viking, NewYork, 2014.

- D. Chalmers, The Conscious Mind, Oxford University Press, New York, 1996.

Articles

- M. Oizumi et al., From the phenomenology to the mechanisms of consciousness : Integrated information theory 3.0, in PLoS Comput. Biol., vol. 10(5), e1003588, 2014.

- E. Renaudo et al., Design of a control architecture for habit learning in robots, in Biomimetic & Biohybrid Systems, 3rd Int. Conf. on Living Machines, vol. 8608, pp. 249-260, 2014.

Internet

Newsletter

Le responsable de ce traitement est Inria. En saisissant votre adresse mail, vous consentez à recevoir chaque mois une sélection d'articles et à ce que vos données soient collectées et stockées comme décrit dans notre politique de confidentialité

Niveau de lecture

Aidez-nous à évaluer le niveau de lecture de ce document.

Votre choix a été pris en compte. Merci d'avoir estimé le niveau de ce document !

Raja Chatila

Directeur de recherche CNRS, directeur de l’Institut des Systèmes intelligents et de robotique (ISIR).

Mehdi Khamassi

Chargé de recherche CNRS à l’Institut des Systèmes intelligents et de robotique (ISIR UMR 7222), au sein de l’Université Pierre et Marie Curie à Paris.