La neutralité du Net face à l’évolution des réseaux

La neutralité du Net : un peu d’histoire

De la naissance d’Internet…

Internet est un réseau dont la conception a été initiée au début des années 1960 aux États-Unis, pour connecter des ordinateurs afin de partager de l’information et des ressources pour la recherche (mais également pour fournir un réseau robuste aux militaires en période de guerre froide). Internet a officiellement été créé en 1983 quand le réseau ARPAnet a été séparé du réseau militaire pour connecter les universités à travers les États-Unis. Son succès et les opportunités qu’il présentait ont conduit à une ouverture globale, permettant le partage de la connaissance, transformant le commerce, l’industrie et la société, pour atteindre 4,88 milliards d’utilisateurs et utilisatrices en octobre 2021.

…aux questions relatives au traitement du trafic

Cependant, la transition d’un réseau collaboratif entre universités vers un réseau géré par des entités privées commerciales (donc dirigées par des principes économiques) introduit une contradiction avec la vision ouverte et collaborative des origines d’Internet. Cette différence de visions a donné naissance au débat sur la neutralité du Net, notamment mis en exergue quand en 2005, le PDG du principal opérateur de télécommunications aux États-Unis, Ed Whitacre, observant que les fournisseurs de contenus distants utilisaient son réseau mais ne le payaient pas pour cela, a demandé qu’ils contribuent, au risque de voir leurs services limités voire bloqués. Depuis, plusieurs situations où des opérateurs ont affecté de la sorte le trafic sur leur réseau ont été relevées, comme illustré de manière non exhaustive par le tableau suivant.

| 2005 | L’opérateur américain Madison River bloque la voix sur Internet (VoIP, service concurrent à la téléphonie traditionnelle) |

| 2007 | L’opérateur américain Comcast bloque les services pair-à-pair (supposés utilisés en majorité pour des transferts illégaux) |

| 2007-2009 | AT&T bloque le service VoIP Skype ; T-Mobile en Allemagne, Telefonica au Chili (entre autres exemples) bloquent la VoIP |

| 2009 | British Telecom est accusé de limiter le streaming vidéo de la BBC |

| 2010 | L’opérateur américain Windstream Communications remplace par son propre moteur de recherche celui choisi par l’utilisateur dans le navigateur Firefox |

| 2012 | AT&T bloque l’application FaceTime |

| 2013 | Le site d’enquête en ligne zambiawatchdog.com est bloqué en Zambie |

| 2013 | Les opérateurs néerlandais KPN et Vodafone bloquent les services VoIP sur leurs hotspots WiFi |

Ces incidents ont soulevé de vives réactions à travers le monde de la part des fournisseurs de services et contenus ou des associations d’usagers, y voyant un changement de paradigme de l’Internet.

Définir la neutralité

Il existe plusieurs définitions plus ou moins similaires de la neutralité du Net, et leurs applications varient grandement selon les pays. Pour l’Union Européenne, selon le règlement de 2015 relatif à l’accès à un internet ouvert, les utilisateurs ont le droit « d’accéder aux informations et aux contenus et de les diffuser, d’utiliser et de fournir des applications et des services et d’utiliser les équipements terminaux de leur choix, quel que soit le lieu où se trouve l’utilisateur final ou le fournisseur, et quels que soient le lieu, l’origine ou la destination de l’information, du contenu, de l’application ou du service, par l’intermédiaire de leur service d’accès à l’internet ». Ainsi, pour les opérateurs « tout le trafic doit être traité de façon égale et sans discrimination, restriction ou interférence, quels que soient l’expéditeur et le destinataire, les contenus consultés ou diffusés, les applications ou les services utilisés ou fournis ou les équipements terminaux utilisés ». Des exceptions liées à des décisions de justice, pour des questions de sécurité ou pour temporairement résoudre les problèmes de congestion sont autorisées, mais toute considération commerciale dans le traitement du trafic est interdite.

Les tendances récentes

Le débat n’est pas clos pour autant, car des décisions récentes vont plutôt dans le sens d’un allègement des règles protégeant la neutralité, comme aux États-Unis par exemple, où des opérateurs ont annulé en 2017 les règles de neutralité instaurées au nom de la « liberté économique », et en Europe où le commissaire européen chargé du marché intérieur a déclaré en mai 2022 que « les opérateurs n’ont plus le bon retour sur leurs investissements. Il est nécessaire de réorganiser la juste rémunération des réseaux ».

On peut donc s’interroger sur l’avenir du principe de neutralité : est-il toujours pertinent, ou est-il dépassé compte tenu des évolutions technologiques ? Et si on veut le maintenir sous une forme ou une autre, comment procéder ?

Les « défis » de la neutralité face aux nouvelles technologies : quelle neutralité et comment la contrôler ?

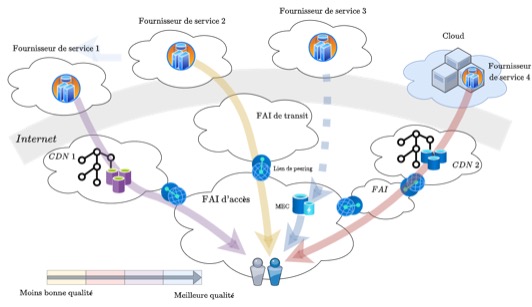

Internet n’est plus une simple chaine de transmission avec les opérateurs comme uniques intermédiaires entre contenus et usagers : il existe de nombreux autres prestataires intervenant dans l’accès au contenu, et pouvant provoquer des différences de traitement des flux (voir la figure 1 ci-dessous). Nous évoquons quelques exemples ici.

Les fournisseurs de distribution de contenu (CDNs)

Ces acteurs se chargent de dupliquer le contenu et de le conserver dans des serveurs situés à proximité des usagers. Les paquets Internet sont alors traités équitablement au cœur du réseau, mais la qualité perçue par l’utilisateur est bien meilleure si le contenu téléchargé est stocké à proximité. Les décisions du CDN quant aux contenus à stocker ont donc un impact !

Définir la neutralité dans ce contexte est déjà délicat :

- Imposer aux CDNs de stocker la même quantité de contenu de chaque fournisseur, indépendamment de leur popularité, semble très inefficace bien que respectant un principe d’équité ;

- Si on pense à l’efficacité, on pourrait plutôt considérer qu’un comportement « neutre » consisterait à stocker les contenus les plus populaires.

La question subsiste de la légitimité d’une intervention régulatoire dans l’activité de ces acteurs privés que sont les CDNs : peut-on leur interdire de stocker en priorité les contenus d’un fournisseur qui les paie pour cela ?

Si on répond positivement, la vérification pratique reste délicate à effectuer. Prenons par exemple la deuxième définition proposée : le régulateur devrait alors estimer la popularité de chaque type de contenu, et vérifier qu’il n’y a pas deux contenus pour lesquels le moins populaire est stocké par le CDN alors que le plus populaire ne l’est pas. Des outils peuvent être imaginés dans ce but afin d’automatiser la vérification, mais plusieurs difficultés techniques seraient à résoudre, concernant notamment la détermination des contenus stockés et l’estimation des popularités.

Quand les « gros » fournisseurs de services s’allient avec les opérateurs

Dans cette même tendance, les fournisseurs de services peuvent eux-mêmes s’inviter au sein des réseaux d’opérateurs en déployant leur propre solution consistant à stocker les contenus au plus près des utilisateurs (et donc leur propre service de CDN). C’est le cas de la solution Open Connect de Netflix, qui fonctionne via « des partenariats avec les fournisseurs d’accès Internet (FAI) afin de livrer [le] contenu de la façon la plus efficace qui soit ». Ce type de solutions, souvent déployées à titre gracieux, accroît de facto les différences de traitements entre les différents fournisseurs, les plus petits ne pouvant pas se permettre de tels accords.

Si on souhaite limiter ces accords pour préserver la neutralité, les défis technologiques sont les mêmes que pour contrôler le comportement des CDNs : il faudra être capable d’estimer la popularité des contenus, et le traitement (stockage proche des utilisateurs ou non) associé.

Un type d’alliance similaire implique les opérateurs de réseaux qui développent à leur tour des infrastructures en bordure du réseau avec le Multi-access Edge Computing (MEC), permettant le partage d’informations sur l’état du réseau avec certains fournisseurs de services. Ces derniers ont alors un avantage par rapport aux concurrents : ils peuvent par exemple optimiser leurs applications en conséquence (streaming notamment), mais également inclure le stockage de leurs contenus proche des utilisateurs. Ici, un régulateur visant à assurer l’équité pourrait exiger que toutes les informations quant à l’état du réseau soient librement accessibles par tous les fournisseurs de services (en mode open data).

Les moteurs de recherche

Les moteurs de recherche permettent d’accéder au contenu via une recherche par mot clé — ils sont censés renvoyer vers les services les plus pertinents. Cependant, ces acteurs sont suspectés de privilégier leurs propres services ou ceux de partenaires, et donc de potentiellement discriminer les concurrents. Pour un régulateur, de tels comportements sont difficiles à mettre en évidence, car la notion de pertinence est subjective, et la pertinence d’un résultat dépend fortement de la personne à l’origine de la requête. De plus, les algorithmes utilisés par les moteurs de recherche sont gardés secrets. Une façon de procéder est proposée par l’action exploratoire Inria SNIDE (voir l’article Interstices sur le sujet) : le principe est de se reposer sur un nombre suffisamment grand de moteurs de recherche indépendants, afin d’estimer la pertinence de chaque page web proposée en résultat, et de détecter d’éventuelles anomalies via des tests statistiques. Des campagnes sur un grand nombre de mots-clés peuvent alors mettre en évidence des tendances à favoriser ou pénaliser un acteur ou un domaine du web.

Les plateformes structurantes

Ces acteurs sont définis selon l’ARCEP comme « les opérateurs de plateforme en ligne ou les fournisseurs de système d’exploitation, qui, en particulier du fait de leur activité d’intermédiation dans l’accès aux services et contenus d’Internet, et de par leur importance, sont en mesure de limiter de manière significative la capacité des utilisateurs à exercer une activité économique ou à communiquer en ligne ». Cela concerne entre autres les sites de réservation d’hôtels, de commerce en ligne, etc. Ces sites sont dans le viseur des autorités de régulation pour des pratiques non équitables. En pratique, pour contrôler leurs potentiels biais, on peut imaginer des outils proches de celui développé pour les moteurs de recherche, avec la difficulté supplémentaire que lorsque le service est spécialisé, peu d’acteurs sont en concurrence : on peut donc moins se fier à un comportement agrégé ou moyen pour détecter des anomalies.

D’autres « zones grises »

Même en gardant le viseur sur les opérateurs réseaux, il existe des pratiques pour lesquelles les régulateurs des différents pays ne sont pas sur la même ligne. C’est notamment le cas pour le « zero rating », qui consiste pour les opérateurs mobiles à inclure dans un forfait limité en données, certains services « en illimité » non-décomptés du forfait, alors favorisés. De telles offres peuvent être plus attractives pour les usagers mais considérées discriminatoires pour les services concurrents (car il y a moins d’incitation à les utiliser), alors même que tous les paquets sont traités de manière identique au sein du réseau. Contrairement aux autres cas, celui-ci ne nous semble pas lever de défi technologique, car les offres sont publiques et la facturation détaillée facilite la vérification. La question politique d’une interdiction ou non reste (l’arrêt Telenor de la Cour de justice de l’Union européenne de novembre 2020 va cependant dans le sens d’une interdiction), mais l’implémentation est « facile ».

Et la 5G ?

Enfin, et ce n’est probablement pas le moins grand défi pour la neutralité, le principe est confronté à l’évolution des technologies elles-mêmes. La 5G notamment prévoit comme caractéristique ou fonctionnalité clé le « slicing », dont le principe de base est la virtualisation, qui consiste à découper virtuellement le réseau en tranches (slices en anglais) ou sous-réseaux pour mieux répondre aux exigences de qualité de service des différents types de flux (la vidéo ou les jeux n’ayant pas les mêmes contraintes que le mail ou le transfert de fichier). Le slicing permet ainsi un service à la demande et une flexibilité de service. Mais cette notion n’est-elle pas fondamentalement contradictoire avec la notion de neutralité ? Un défi majeur serait de concilier les deux éléments ; les premières considérations en ce sens sont peut-être d’ailleurs à l’origine des décisions récentes en défaveur de la neutralité.

Quel avenir pour la neutralité ?

Ce texte a pour but d’illustrer la complexité de l’écosystème Internet, et la difficulté de concilier neutralité et nouvelles technologies réseau. De nombreuses zones grises existent, et les décisions politiques voire économiques qui seraient prises pour les réguler en pratique impliquent souvent de résoudre des défis scientifiques et techniques.

Nous espérons, en restant le plus neutres possible, contribuer à ce que le lecteur puisse se faire sa propre idée sur ce sujet très sensible, aux enjeux économiques colossaux. S’il est inéluctable que les règles doivent évoluer avec notre société, un défi passionnant reste néanmoins de trouver des nouveaux compromis et de réussir à les mettre en œuvre, sans dénaturer les principes originels.

Newsletter

Le responsable de ce traitement est Inria. En saisissant votre adresse mail, vous consentez à recevoir chaque mois une sélection d'articles et à ce que vos données soient collectées et stockées comme décrit dans notre politique de confidentialité

Niveau de lecture

Aidez-nous à évaluer le niveau de lecture de ce document.

Votre choix a été pris en compte. Merci d'avoir estimé le niveau de ce document !

Patrick Maillé

Patrick Maillé est professeur à IMT Atlantique, au sein de l’équipe ERMINE de l’UMR IRISA.