Le traitement du signal, au cœur de la science et de notre vie quotidienne

La version originale de cet article a été publiée sur The Conversation.

![]()

Acquérir des données, les mettre en forme, les transformer, les nettoyer pour mieux les analyser et en extraire une information utile, c’est là le lot de toute science expérimentale mais, en y adjoignant des idées de modélisation et d’algorithmes de calcul, on obtient un ensemble de méthodes qui se sont aujourd’hui constituées en véritable discipline scientifique.

Des signaux partout

Qu’est-ce qu’un signal ? C’est essentiellement le support physique d’une information : des enregistrements audio, des images, des vidéos, des données collectées par des capteurs de toute nature… Par extension, quasiment toute forme de données numérisées ou numérisables, jusqu’à des textes.

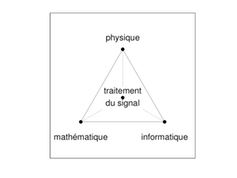

Au confluent de trois grandes disciplines. Flandrin, CC BY

Notre monde regorge de signaux à traiter, que ce soit dans la nature, ou bien provenant des réalisations humaines, notamment technologiques. Les mathématiques sont un passage obligé pour formaliser le traitement du signal et évaluer ses performances. L’informatique permet, elle, une mise en œuvre efficace de ses algorithmes. Tissant des liens avec chacune de ces disciplines mais irréductible à l’une ou à l’autre, le traitement du signal est par nature une discipline d’interface. Développant des méthodologies propres et dialoguant avec les applications depuis l’acquisition jusqu’à l’interprétation, il occupe ainsi une place singulière et centrale dans les sciences de l’information.

Un peu d’histoire

Aux origines du traitement du signal, on peut voir en Joseph Fourier (1768-1830) un précurseur. Pour établir les équations de la propagation de la chaleur, il mit au point une méthode mathématique nouvelle qui remplaça la description d’un signal dans le temps ou l’espace par celle de ses fréquences constitutives : la « transformation de Fourier ». Le scientifique a clairement formulé l’ambition de son programme dans son mémoire fondateur :

« Cette recherche difficile exigeait une analyse spéciale, fondée sur des théorèmes nouveaux […]. La méthode qui en dérive ne laisse rien de vague et d’indéterminé dans les solutions ; elle les conduit jusqu’aux dernières applications numériques, condition nécessaire de toute recherche, et sans laquelle on n’arriverait qu’à des transformations inutiles ».

Joseph Fourier. Wikipedia, CC BY-SA

En quelques mots, tout est dit sur la nécessité d’associer modèles physiques, méthodes mathématiques et algorithmes efficaces.

Fourier avait le souci des applications numériques mais les moyens du XIXe siècle étaient limités à cet égard et la transformation qu’il avait imaginée, qui a été et est encore centrale dans toute analyse de données, a vu son impact démultiplié en 1965 lorsque James Cooley et John Tukey en proposèrent un algorithme de calcul rapide (dit de FFT, pour Fast Fourier Transform). Parachevant la vision de Fourier, on peut considérer que cette année 1965 marque la vraie date de naissance du traitement (numérique) du signal.

Si l’on remonte quelques années en arrière, c’est autour de la deuxième guerre mondiale que le traitement du signal a commencé à se développer, d’abord et essentiellement pour des besoins militaires liés à l’utilisation du sonar et du radar. L’immédiat après-guerre a vu l’éclosion d’approches nouvelles visant à donner des cadres théoriques à des notions, intuitives, mais alors encore vagues, comme celles de message, de signal, de bruit, de transmission, de contrôle. En quelques années apparurent la théorie de la communication de Dennis Gabor, la cybernétique de Norbert Wiener et, bien sûr, la théorie de l’information de Claude E. Shannon.

André Blanc-Lapierre. Wikipedia, CC BY

En parallèle, le physicien et mathématicien français André Blanc-Lapierre mit au point une « théorie des fonctions aléatoires » afin de pouvoir modéliser et analyser le « bruit de fond » rencontré en acoustique sous-marine. De cette collaboration entre l’université et la Marine nationale naquit l’association GRETSI qui, en 1967, organisa en France le tout premier congrès au monde dédié à la discipline nouvelle du traitement du signal. Celui-ci inaugura une série ininterrompue de rencontres biennales, jusqu’à celle de cette année. Le colloque a fêté son cinquantième anniversaire début septembre à Juan-les-Pins, signe d’une École française qui a toujours été florissante.

De très nombreuses applications

Le traitement du signal a aujourd’hui largement dépassé le cadre de ses premières applications, investissant progressivement des champs de plus en plus nombreux de la science et de la technologie. Signe de son importance, la société savante mondiale la plus importante du domaine, l’IEEE Signal Processing Society, n’hésite pas à définir son objet comme « the science behind our digital life ».

Comme cela a été remarqué précédemment avec la FFT, il faut bien comprendre que c’est le développement prodigieux des moyens de calcul depuis les années 1960 qui a été un levier essentiel pour le traitement du signal. La puissance des ordinateurs a permis de mettre en œuvre, souvent en temps réel, des solutions de plus en plus complexes.

Sans que l’on en soit nécessairement conscient, le traitement du signal est présent dans notre vie de tous les jours, en même temps qu’au cœur d’avancées scientifiques fondamentales. Un smartphone est par exemple un concentré de traitement du signal, assurant toutes sortes de fonctions grâce auxquelles on peut communiquer, échanger ou stocker de la voix, de la musique, des photos ou des vidéos (des formats grand public comme MP3, JPEG, MPEG, etc., sont de purs produits du traitement du signal).

Le champ de la santé offre de nombreux autres exemples d’applications pour lesquels se déploient des méthodes d’analyse de signaux, d’images ou de séquences sous différentes modalités, que ce soit pour le suivi du rythme cardiaque, la localisation de foyers épileptiques dans le cerveau, l’échographie ou l’imagerie par résonance magnétique. De même dans de grands secteurs comme l’énergie ou les transports, où la prolifération de capteurs et la nécessité de traiter l’information qu’ils collectent placent le traitement du signal au centre d’enjeux globaux comme les smart grids ou les villes intelligentes.

Débruiter les données

Un dénominateur commun de beaucoup de méthodes de traitement du signal est qu’elles s’attachent à « débruiter » des données, à les « séparer » en constituants significatifs, et à les « reconstruire » en tenant compte de la résolution limitée des instruments d’acquisition. Cette préoccupation qui est au centre des quelques applications mentionnées précédemment se retrouve aussi dans d’autres domaines comme la sismique, où il s’agit d’imager le sous-sol à partir des échos qu’il renvoie en réponse à une excitation, ou encore en astronomie et en astrophysique.

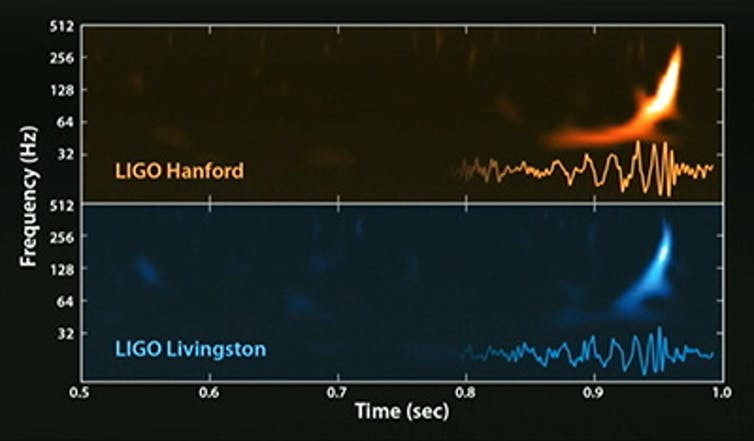

Dans ces derniers domaines, on peut citer deux exemples récents dans lesquels le traitement du signal a joué un rôle essentiel. Le premier est lié à la mission PLANCK : des techniques avancées de séparation de sources ont permis de réaliser une image du fond diffus cosmologique et d’obtenir la « plus vieille photo » de l’Univers. Le second est celui des premières détections sur Terre d’ondes gravitationnelles par les collaborations LIGO-Virgo. Ces derniers exploits ont été rendus possibles, outre la prouesse technologique des instruments eux-mêmes, par un traitement du signal poussé basé pour part sur l’analyse en ondelettes (dont le développement vient de valoir à Yves Meyer le Prix Abel) qui peut se voir comme une extension puissante de l’analyse de Fourier.

Les signaux de la première onde gravitationnelle détectée en septembre 2015.

Caltech/MIT/LIGO Laboratory, CC BY

Et demain ?

Quinquagénaire fringant, le traitement du signal, acteur majeur de la révolution numérique et des sciences de l’information, affronte aujourd’hui de nouveaux défis. Le monde numérique dans lequel nous vivons est source d’une quantité toujours plus grande de données qui fournissent autant de signaux de très grandes dimensions, sous des modalités de plus en plus variées : imagerie hyperspectrale dans des centaines de canaux fréquentiels en télédétection, réseaux de milliers de capteurs pour la surveillance de l’environnement, données de contacts sur les réseaux sociaux…

Ces configurations nouvelles amènent le traitement du signal d’aujourd’hui (et de demain) à se réinventer en lien avec des techniques issues du calcul distribué, de l’optimisation ou de l’apprentissage-machine. Il n’en garde pas moins son identité et ses spécificités, soucieux d’assurer le développement de méthodes génériques et efficaces numériquement, tout en s’appuyant sur une compréhension fine des données et en n’échappant pas à la nécessité de conduire une réflexion sur son impact sociétal.

Newsletter

Le responsable de ce traitement est Inria. En saisissant votre adresse mail, vous consentez à recevoir chaque mois une sélection d'articles et à ce que vos données soient collectées et stockées comme décrit dans notre politique de confidentialité

Niveau de lecture

Aidez-nous à évaluer le niveau de lecture de ce document.

Votre choix a été pris en compte. Merci d'avoir estimé le niveau de ce document !

Patrick Flandrin