Marvin Minsky : un des cerveaux de l’intelligence artificielle

Marvin Minsky fut certainement un étudiant brillant : en 1950, alors qu’il a tout juste 22 ans, il obtient un B.A. de mathématiques de la très prestigieuse université d’Harvard après avoir servi un an, de 1944 à 1945, dans la marine américaine (US Navy) en qualité de soldat du contingent. À la rentrée suivante, il s’engage dans une thèse de mathématiques sur les réseaux de neurones artificiels dans un laboratoire de l’université de Princeton.

Image du corps d’un neurone obtenu par la méthode de Camillo Golgi.

Pour saisir le caractère novateur de ce travail, rappelons que, couronnés conjointement par le prix Nobel de physiologie en 1906, Camillo Golgi et Santiago Ramón Y Cajal permirent de mieux comprendre la structure fine de la matière cérébrale. Camillo Golgi avait trouvé des techniques de coloration au nitrate d’argent qui visualisaient la composition des tissus cérébraux en mettant en évidence les neurones.

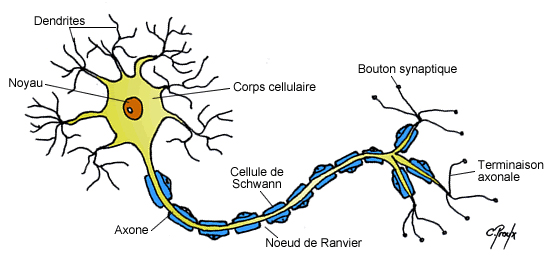

Quelques années plus tard, en reprenant la technique de Camillo Golgi, Santiago Ramón Y Cajal découvrit la structure fine des neurones avec un « corps » d’où partent un ensemble de protubérances en saillie appelées les dendrites et un long filament, l’axone, le long duquel se propage l’influx nerveux. Ce dernier se termine par des excroissances en boutons appelées les synapses, qui se connectent avec les terminaisons dendritiques d’autres neurones.

Structure d’un neurone. Dessin : Chantal Proulx.

En 1943, un médecin, Warren McCulloch, et un très jeune mathématicien âgé d’à peine 20 ans, Walter Pitts, modélisèrent les neurones tels que les avait décrits Santiago Ramón Y Cajal avec des relais électromécaniques, c’est-à-dire des commutateurs, qu’ils interprétèrent comme des automates booléens en cela qu’ils ont deux états, vrai ou faux, selon que le commutateur est ouvert ou fermé, et que l’état suivant dépend uniquement des entrées et de l’état précédent. Ils mirent ensuite ces automates en réseau de sorte que les sorties des uns, pondérées d’un poids, constituent les entrées des autres. Poursuivant l’analogie avec le cerveau, il appelèrent neurones formels les automates et liaisons synaptiques les connexions pondérées entre la sortie d’un neurone formel et l’entrée d’un autre. Ils montrèrent alors que n’importe quelle fonction logique se programmait sur un réseau d’automates booléens stratifié en trois couches de neurones formels et deux couches intermédiaires de liaisons synaptiques à condition (1) de distribuer correctement les poids des liaisons synaptiques liant les neurones de chaque couche à ceux de la suivante et (2) de disposer de suffisamment de neurones sur la couche intermédiaire dite cachée. Insistons sur l’importance majeure de ce résultat qui fut à l’origine de ce que l’on a appelé quelques années plus tard la cybernétique : il établissait des ponts entre la neurophysiologie, c’est-à-dire la science du cerveau, d’un premier côté, la logique, à savoir la science du raisonnement d’un deuxième côté, et l’ingénierie d’un troisième côté. Toutefois, si McCulloch et Pitts prouvèrent l’universalité des réseaux de neurones formels à trois couches, personne ne savait encore comment les programmer manuellement. Autrement dit, personne ne savait ni comment affecter des poids aux différentes liaisons synaptiques afin de réaliser telle ou telle fonction, ni a fortiori comment déterminer le nombre de neurones de la couche cachée. À cette fin, certains imaginèrent faire appel à des procédures d’apprentissage qui ajusteraient ces poids automatiquement, à partir d’un grand nombre d’exemples. La conception et la mise au point de ces procédures occuperont de nombreux chercheurs par la suite et jusqu’à aujourd’hui.

Quelques années plus tard, en 1949, un neuropsychologue canadien travaillant à l’université de Harvard, Donald Hebb, établit un lien entre l’excitation récurrente d’une cellule par une autre, grâce à une liaison synaptique, et la modification de la conduction de cette synapse. Ce phénomène dit de plasticité synaptique posait des bases physiologiques tangibles pour de nombreuses théories de l’apprentissage et de la mémoire qui virent le jour dans les années suivantes. Elles inspirèrent aussi les mathématiciens et les ingénieurs qui voulaient concevoir des procédures d’apprentissage automatique des poids synaptiques.

C’est dans ce contexte qu’un an plus tard, en 1950, Marvin Minsky commence sa thèse à l’université Princeton. Il construit alors la machine SNARC — Stochastic Neural Analog Reinforcement Calculator — qui réalise, physiquement, avec des tubes à vide, des réseaux de neurones formels capables d’apprendre automatiquement les poids synaptiques en s’inspirant des principes dégagés par Donald Hebb. Plus précisément, dans cette machine, les liaisons synaptiques entre les neurones formels se renforcent par des excitations électriques récurrentes. Certains suggèrent aujourd’hui qu’il s’agit là de la première machine auto-apprenante. Quatre ans plus tard, il passe sa thèse de mathématiques sur ce sujet.

L’année d’après, en 1955, alors qu’il vient tout juste d’avoir 28 ans, il rédige avec son ami John McCarthy un projet d’école d’été pour développer une nouvelle discipline qu’ils décident de nommer « intelligence artificielle » et qui vise à étudier les différentes facettes de l’intelligence en les simulant avec des ordinateurs. Après avoir fait parrainer leur projet par Nick Rochester, le directeur scientifique d’IBM, et, surtout, par le très célèbre Claude Shannon, le père de la théorie de l’information, ils le soumettent à la fondation Rockefeller qui accepte de le financer.

L’école se tient l’été d’après, en août 1956, à Dartmouth College ; c’est là que l’intelligence artificielle voit officiellement le jour. Depuis, Marvin Minsky tout comme son comparse John McCarthy accompagnèrent l’intelligence artificielle tout au long de leur vie professionnelle.

Dans la suite, Marvin Minsky continue à s’intéresser aux réseaux de neurones formels et aux procédures d’apprentissage des poids synaptiques, pour mettre en œuvre ce que l’on voit à l’époque comme une simulation du cerveau qui entre tout à fait dans le programme de l’intelligence artificielle naissante. Les diverses tentatives qui ont alors cours pour concevoir des algorithmes d’apprentissage des poids synaptiques se heurtent toutes à des obstacles d’ordre combinatoire liés à la complexité algorithmique de ces procédures et à leur absence de convergence. Or, en 1958, un camarade de Marvin Minsky, Frank Rosenblatt, conçoit un modèle d’apprentissage qui fonctionne uniquement sur des réseaux de neurones dits monocouches parce qu’ils se constituent d’une couche de liaisons synaptiques prise en sandwich entre deux couches de neurones formels qu’elles connectent. Rosenblatt prétend que l’on a affaire là à un modèle de rétine artificielle qu’il appelle, de façon évocatrice, le perceptron. Ce modèle a beaucoup de succès car il est capable de calculer automatiquement et efficacement les poids synaptiques requis pour distinguer différentes formes élémentaires.

Une dizaine d’années plus tard, en 1969, Marvin Minsky fait paraître avec un psychologue, Seymour Papert, un ouvrage intitulé Perceptrons, pour mettre en évidence les limitations des procédures d’apprentissage en général et du perceptron en particulier. Selon eux, ce dernier illustre de façon remarquablement claire toute une classe de procédures d’apprentissage qui convergent. Ils démontrent alors, avec des arguments mathématiques, que les réseaux monocouches, c’est-à-dire à une couche de poids synaptiques, sur lesquels les algorithmes d’apprentissage du perceptron sont opérationnels et convergent, ne réalisent que des fonctions très élémentaires dites linéairement séparables. Autrement dit, soit les algorithmes d’apprentissage ont une trop grande complexité algorithmique pour être opérationnels, soit ils n’apprennent que des choses triviales. Ils en concluent que les réseaux de neurones formels doivent se coupler avec d’autres techniques, en particulier aux techniques de l’intelligence artificielle naissante, et recourir à différents niveaux d’abstraction, dont certains font appel à du traitement symbolique et logique de l’information.

Notons que les travaux de Minsky et Papert sur le perceptron furent repris dans les années quatre-vingt avec les techniques d’apprentissage par rétro-propagation de gradient qui surmontèrent les limitations du perceptron à une couche de Rosenblatt en les généralisant à des perceptrons multicouches. Cela n’a été possible que grâce à une formalisation mathématique qui met en rapport l’apprentissage des poids synaptiques et la minimisation de l’erreur quadratique.

Soulignons aussi que ce sont les mêmes techniques, légèrement étendues avec, par exemple, la notion de convolution, qui sont à l’œuvre aujourd’hui dans l’apprentissage profond (Deep Learning) implanté sur des réseaux multicouches qui comportent des millions de connexions synaptiques et qui apprennent sur des grandes masses de données (Big Data).

À la fin des années soixante, et en parallèle à ce travail qui s’inscrit dans la suite de sa thèse, Marvin Minsky conçoit, toujours avec Seymour Papert, le langage de programmation Logo destiné à faciliter l’accès à la programmation. Pour cela, ils s’inspirent des théories de Jean Piaget sur l’éducation. Rappelons que, selon Jean Piaget, les enfants passent par différents stades d’abstraction. Très petits, ils n’appréhendent que les objets qui leur sont immédiatement visibles, puis avec l’âge, ces mêmes objets, une fois cachés, demeurent présents à leur esprit, par exemple une balle cachée sous un lit continue d’exister, même si elle n’est plus sous leurs yeux. Ensuite, petit à petit, ils conçoivent des notions de plus en plus éloignées de leur attention et de leurs intuitions immédiates, comme les ensembles, les séquences, les nombres, etc. Se fondant sur ces principes de psychologie, le langage Logo commence avec une petite tortue dont on apprend facilement à programmer les mouvements avec des commandes très simples qui s’expriment avec des mots proches du langage naturel : avancer, tourner à droite, etc. Cela permet de faire toutes sortes de dessins géométriques. Logo introduit ensuite les notions plus complexes de mots, de listes, de fichiers, d’entrées-sorties, etc. jusqu’à couvrir l’ensemble des aspects de la programmation. Ce faisant, c’est aussi l’un des premiers langages orientés objets qui inspire des langages ultérieurs, comme Smalltalk. Soulignons enfin que la « tortue Logo » se réfère à des petits robots réactifs, les « tortues » de Bristol, réalisés en 1947 par le neurophysiologiste Grey Walter.

Tout cela conduit alors Marvin Minsky à travailler dans les années soixante-dix sur ce qui fit l’objet d’une de ses autres grandes contributions, les « cadres de données » (frames en anglais) : ce formalisme de représentation des connaissances s’inspire des approches dites sémantiques développées à partir du début des années soixante-dix en lien avec la psychologie cognitive. Reposant sur les travaux de Sir Frederic Bartlett (1886-1969), ces approches tentent de simuler l’organisation des connaissances dans la mémoire. Ainsi, une chaise n’est pas uniquement donnée comme une image photographique, par un ensemble de points, mais comme un élément de mobilier comprenant quatre pieds, un siège, un dossier, etc. Aujourd’hui, les langages de programmation orientés vers les objets, le web sémantique, les techniques de représentation des connaissances, avec les schémas RDF et les graphes conceptuels, apparaissent comme quelques-uns des héritages de ces approches.

Poursuivant dans cette veine, et fidèle à son intérêt pour la cybernétique et les réseaux de neurones formels, Marvin Minsky fait paraître en 1986 un ouvrage intitulé « La société de l’esprit » (Society of Mind) où il promeut une théorie cognitive de l’intelligence artificielle fondée sur la synergie de processus élémentaires réalisés par des agents informatiques qui parviendraient par leur coordination spontanée à faire émerger des raisonnements complexes.

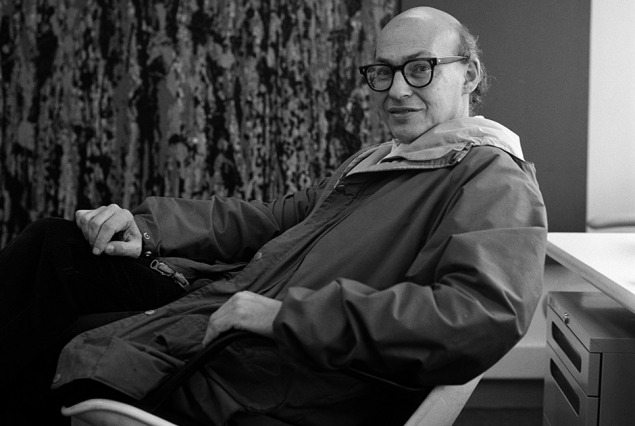

Photo : Marie Cosindas © MIT.

Indépendamment de ses contributions à l’intelligence artificielle, il se passionne pour la science-fiction qu’il connaît remarquablement bien. Il prétend même avoir rencontré la plupart des écrivains américains de science-fiction de sa génération. Il a d’ailleurs été conseiller scientifique de Stanley Kubrick lors du tournage du film « 2001, l’Odyssée de l’espace » et il a lui-même co-écrit un roman intitulé « Le problème de Turing ».

Très influencé par le roman d’Arthur Clarke « Les fontaines du paradis » dans lequel des ingénieurs construisent un ascenseur spatial, il conçoit dans les années quatre-vingts, avec deux autres grands noms de l’intelligence artificielle, John McCarthy et Hans Moravec, une variante de cet ascenseur qu’ils appellent la « fontaine spatiale » (Space Fontain) qui se compose d’un anneau en orbite à 2000 kilomètres de distance et de deux tubes à vide dans lesquels circulent des flux de projectiles qui par leur vitesse propre les maintiennent verticaux, ce qui évite d’avoir à bâtir une tour en matériaux solides.

Et, si tout cela ne suffisait pas, Marvin Minsky était aussi un musicien : il improvisait au piano et développa plusieurs réflexions sur les formes musicales.

Bref, cet esprit curieux, foisonnant et inventif qui contribua à créer l’intelligence artificielle, l’a nourrie, tout au long de sa vie, de son imagination, de ses fantaisies et de ses rêves. Aujourd’hui, après sa disparition, il reste non seulement l’une des figures tutélaires de cette discipline, mais aussi l’un des modèles les plus féconds à suivre pour tous les chercheurs.

Newsletter

Le responsable de ce traitement est Inria. En saisissant votre adresse mail, vous consentez à recevoir chaque mois une sélection d'articles et à ce que vos données soient collectées et stockées comme décrit dans notre politique de confidentialité

Niveau de lecture

Aidez-nous à évaluer le niveau de lecture de ce document.

Votre choix a été pris en compte. Merci d'avoir estimé le niveau de ce document !

Jean-Gabriel Ganascia

Professeur à l'université Pierre et Marie Curie (Paris 6).

Chercheur au Laboratoire d'Informatique de Paris 6 (LIP6).