Prendre la mesure du monde

Les mathématiques se sont toujours nourries de problèmes très concrets et une grande part de l’activité de recherche mathématique est consacrée à des questions en lien direct avec la planète Terre. La démarche du mathématicien prend aujourd’hui des formes variées que l’on peut répartir schématiquement en activités de modélisation, d’analyse et de simulation.

Entre équations et algorithmes

La modélisation vise à mettre en équations un phénomène, qu’il soit de nature physique, biologique, voire sociologique ou financière. Ce travail requiert une bonne compréhension du problème sous-jacent et la capacité d’en extraire les traits saillants afin de proposer une représentation mathématique puis, en retour, de discuter la pertinence et les limites des résultats qui peuvent en être déduits.

L’analyse, quant à elle, correspond bien à l’idée que l’on peut se faire du travail d’un mathématicien. Il faut avoir conscience que, pour ces équations traduisant des phénomènes complexes, il n’existe généralement pas de formule explicite définissant la solution. Par exemple, on dispose depuis le XIXe siècle des équations de Navier-Stokes pour décrire l’évolution de la densité et de la vitesse d’un fluide, comme l’eau d’une rivière ou l’air autour d’un véhicule. Mais, hormis dans des configurations très particulières, on ne sait pas exprimer explicitement les solutions de ce système d’équations non linéaires comme des fonctions des variables de temps et d’espace. L’objectif pour le mathématicien consiste alors à déterminer si ces équations admettent une solution puis si, pour un jeu de données fixé, il n’existe bien qu’une seule solution. Ces questions réclament la mise en place d’un cadre « fonctionnel » qui précise « où » on cherche les solutions. Derrière un jargon technique indispensable, ce cadre fixe certaines propriétés qui rendent ces solutions physiquement admissibles. Notons d’ailleurs que pour les équations de la mécanique des fluides, ces questions « basiques » restent encore largement ouvertes, et que leur résolution fait l’objet de l’un des prix du millénaire, d’une valeur d’un million de dollars, offerts par la fondation Clay en 2000.

On peut également chercher à exhiber des propriétés qualitatives des solutions. Ainsi, pour certains de ces problèmes de mécanique des fluides, on sait que les solutions peuvent présenter des singularités, c’est-à-dire des variations brutales d’une position à l’autre, quand bien même la configuration initiale serait très régulière. Le bang des avions supersoniques est une manifestation concrète de ces singularités. Décrire précisément les caractéristiques de telles solutions est un enjeu crucial du point de vue applicatif. Une autre question d’analyse importante pour les applications réside dans la mise en évidence de propriétés asymptotiques. Un même phénomène peut avoir plusieurs descriptions mathématiques, plus ou moins riches ou précises et plus ou moins adaptées à certaines situations pratiques. L’analyse asymptotique cherche à identifier des paramètres pertinents dans les équations et à établir que les solutions de descriptions différentes se ressemblent lorsque ces paramètres évoluent d’une certaine façon. De tels théorèmes justifient donc, pour un domaine de validité donné, la pertinence d’un jeu d’équations simplifié.

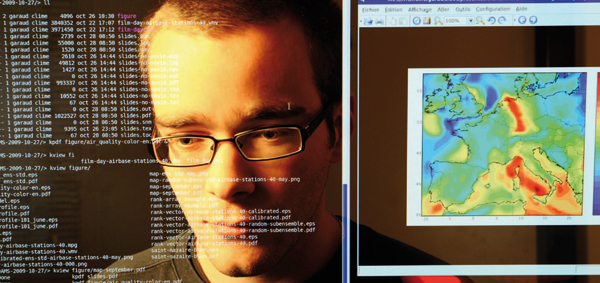

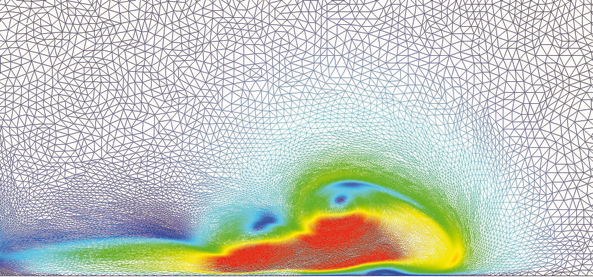

Simulation d’une avalanche de neige poudreuse. L’image représente un zoom sur le front de l’avalanche. Les couleurs indiquent les variations de vitesse (les plus grandes vitesses sont en rouge). Les équations sous-jacentes sont de type Navier-Stokes.

© Caterina Calgaro, Emmanuel Creusé, Thierry Goudon/Université Lille-I /CNRS/Inria. Simulation avec le logiciel ND2DDV, 2013.

Enfin, troisième volet de l’intervention des mathématiques, l’art de la simulation numérique consiste à concevoir un algorithme, c’est-à-dire une suite d’instructions élémentaires qui permettent de produire, à l’aide d’un ordinateur, une approximation de la solution recherchée. La conception d’algorithmes performants s’appuie sur une compréhension profonde à la fois des enjeux de modélisation et des résultats d’analyse. Techniquement se cachent derrière ce travail les liens du discret au continu, les liens entre suites et fonctions. En effet, la modélisation fournit des équations avec des variables évoluant de manière continue alors que l’ordinateur ne peut manipuler que des quantités discrètes. On doit donc changer la nature du problème. Mais ce problème discret que l’on entend ainsi résoudre est-il bien une approximation du problème continu ? Les erreurs produites ne s’accumulent-elles pas pour conduire à une solution numérique incohérente ? Ces questions ont motivé l’introduction des notions de consistance et de stabilité des schémas numériques, auxquelles sont associés des grands noms des mathématiques tels que John von Neumann ou Peter Lax.

Les ordinateurs, assistants des mathématiciens

Les progrès de la simulation numérique reposent également sur ceux des moyens de calcul : les machines sont de plus en plus performantes, elles font davantage d’opérations par seconde et stockent plus de données. Ces évolutions multiformes et dans des directions parfois inattendues suscitent en retour de nouvelles questions d’ordre mathématique, afin de les exploiter au mieux, et influencent profondément les pratiques. Ainsi, on peut partager entre plusieurs ordinateurs les calculs à effectuer pour résoudre un problème. Comment gérer alors la répartition des opérations ? Quelles sont les difficultés liées au fait que les diverses machines peuvent exploiter des architectures différentes ? Les cartes graphiques, si performantes pour les jeux vidéo, n’offrent-elles pas aussi des perspectives séduisantes pour le calcul ? Peut-on optimiser l’affectation des calculs en fonction des temps de communication entre les différents matériels (ordinateurs, processeurs, dispositifs de stockage, etc.) ? Comment gérer, stocker et visualiser toutes ces données ?

Salle de calcul du Tera 100 au CEA-DAM – Île-de-France.

© P. Stroppa/CEA.

Quelques chiffres permettent de mesurer l’enjeu de ces questions. Le code de calcul Gysela réalise des simulations pour le projet Iter (International Thermonuclear Experimental Reactor). Il s’agit de décrire le comportement de particules chargées – des ions et des électrons – confinées dans un tore et soumises à un champ magnétique intense. Les simulations de pointe manipulent jusqu’à 272 × 109 inconnues ; le calcul nécessite 31 jours sur 8 192 processeurs, soit l’équivalent de 6 millions d’heures sur un processeur unique, et produit 6,7 téraoctets de données à analyser. La machine de calcul la plus performante en France – le Tera 100 du Commissariat à l’énergie atomique et aux énergies alternatives (CEA) – peut effectuer jusqu’à un million de milliards d’opérations par seconde (1 petaflops) ; son stockage interne représente 240 fois le volume numérisé des ouvrages de la Bibliothèque nationale de France (BnF) ; elle produit quotidiennement un volume de données équivalent au contenu de la BnF au prix d’une puissance électrique de 7 mégawatts, soit ce que développent deux motrices de train. Une appréciation des progrès fulgurants de la simulation a été donnée dans un rapport de l’Académie des sciences en 2008 : « La puissance des ordinateurs double tous les 18 mois ; avec la progression des méthodes numériques, on a un facteur 5 tous les 2 ans. »

Ainsi, le travail mathématique est protéiforme, le mathématicien – ou la mathématicienne ! – offre de multiples visages, et il y a bien des façons, dans le monde académique ou industriel, de contribuer à l’effort scientifique en vue de mieux comprendre le monde qui nous entoure, cette planète Terre qui demeure source d’inspiration et de motivation. Les mathématiques forment une discipline vivante, où la production de résultats nouveaux (théorèmes, méthodes de calcul, etc.) est colossale. Il s’agit d’une spécialité ouverte, en interaction permanente avec d’autres champs scientifiques : la physique bien sûr, la biologie, l’informatique et même les sciences humaines. Les quelques exemples qui suivent illustrent plusieurs apports concrets des mathématiques.

Des outils pour mesurer la planète

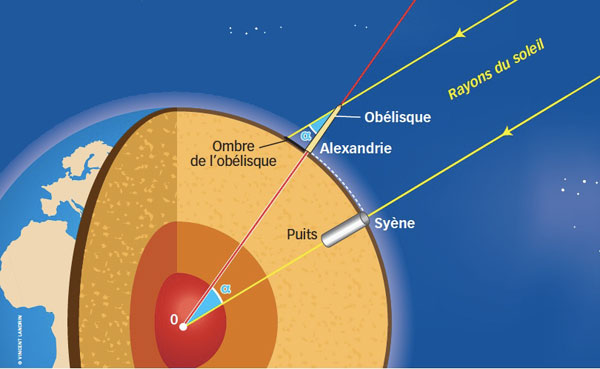

Le raisonnement d’Ératosthène pour déterminer la circonférence de la Terre.

Infographie © Vincent Landrin.

L’étymologie nous rappelle qu’associer mathématiques et planète Terre est bien naturel : la géométrie est l’art de mesurer la Terre. Au IIIe siècle avant J.-C., Ératosthène a ainsi élaboré une méthode purement… géométrique pour évaluer la circonférence de notre planète. Son raisonnement exploite des données issues de l’observation. Au solstice d’été, le 21 juin, à midi, il remarque qu’aucune ombre ne subsiste au fond d’un puits à Syène (aujourd’hui Assouan) située sur le tropique du Cancer alors qu’au même moment on peut mesurer l’ombre d’un obélisque à Alexandrie. Supposant que la lumière arrive du Soleil en rayons parallèles et connaissant la hauteur de l’obélisque, il en déduit que l’axe Soleil-Alexandrie réalise un angle de 7,2 degrés avec l’axe vertical. Il fait ensuite réaliser par des arpenteurs une mesure de la distance entre Syène et Alexandrie, situées approximativement sur un même méridien. En multipliant les 787,5 km mesurés par 360/7,2, il obtient une circonférence de 39 375 km. Ce résultat est remarquablement précis (les mesures modernes donnent 40 075,02 km) en dépit des incertitudes des mesures réalisées par les arpenteurs et du fait que les deux villes ne sont pas exactement sur la même longitude.

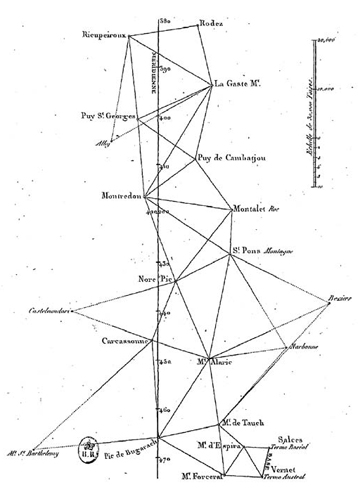

Portion de la méridienne de France. Planche extraite de Base du système métrique décimal ou Mesure de l’arc du méridien compris entre les parallèles de Dunkerque et Barcelone, tome 1, de Jean-Baptiste Delambre et Pierre Méchain, vers 1792. Illustration © gallica.bnf.fr/Bibliothèque nationale de France.

Des résultats plus précis ont été obtenus en exploitant la méthode de triangulation dont les principes ont été introduits par Gemma Frisius au XVIe siècle. L’idée maîtresse est qu’il est plus facile de mesurer des angles que des distances. On commence par découper le territoire d’étude en triangles dont chaque sommet coïncide avec un point haut (clocher, tour de château, etc.) d’où l’on peut voir d’autres sommets. Cette décomposition constitue un pavage. Depuis chaque sommet, on détermine l’angle entre les directions de visée vers deux autres sommets grâce à un instrument spécifique appelé théodolite. Il reste à mesurer un côté d’un des triangles, la base de la triangulation. De simples calculs de trigonométrie permettent d’obtenir toutes les distances caractéristiques du pavage. Cette technique est à la base de la mesure réalisée par Jean-Baptiste Delambre et Pierre Méchain pour la « méridienne de France » entre Dunkerque et Barcelone durant une expédition qui a duré de 1792 à 1798. Jean-Baptiste Delambre et Adrien Legendre publient à cette occasion un mémoire détaillé de plus de deux cents pages, Méthodes analytiques pour la détermination d’un arc du méridien, où ils établissent des formules pour effectuer les corrections nécessaires afin de prendre en compte la géométrie sphéroïde de la Terre. Tout l’enjeu de cette quête n’était rien d’autre que d’aboutir à la définition du mètre, unité de mesure correspondant au dix-millionième de la moitié du méridien terrestre : la mesure de Delambre fut adoptée par la France le 7 avril 1795 comme base de l’unité de longueur officielle.

Des modèles indispensables en biologie

Parmi les questions mathématiques motivées par la compréhension des processus biologiques, l’une concerne la description de l’évolution des effectifs de différentes espèces vivantes en interaction. Le mathématicien et physicien italien Vito Volterra s’est intéressé à cette problématique sous l’impulsion de son beau-fils, le biologiste Umberto D’Ancona, qui avait observé des fluctuations dans les relevés des espèces de poissons pêchés dans la mer Adriatique et cherchait une explication à ces variations. Volterra, qui a présenté ses conclusions dans une série de leçons données à l’Institut Henri-Poincaré à Paris en 1928-1929, propose de séparer les poissons en deux catégories, les proies et les prédateurs, dont il décrit les interactions de manière simplifiée. Les proies se reproduisent facilement et, en l’absence de prédateurs, leur population peut croître rapidement de façon exponentielle (on retrouve là le comportement d’une population malthusienne).

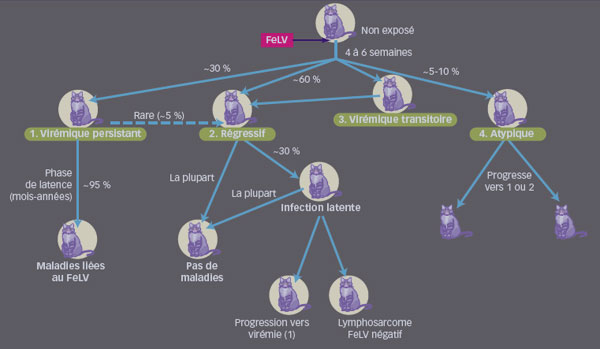

Les prédateurs, s’ils ne trouvent pas de nourriture, disparaissent. L’évolution des deux populations est bien sûr couplée. Les rencontres entre les deux types d’individus se traduisent par un prélèvement sur la population de proies selon un taux proportionnel au nombre d’individus des deux espèces. Enfin, la présence de proies favorise la croissance de la population des prédateurs, là aussi selon un taux proportionnel au nombre d’individus des deux espèces. S’il y a peu de prédateurs, les proies se reproduisent facilement et, les rencontres avec les prédateurs étant rares, elles subissent peu de pertes. Mais avec la multiplication des proies, les prédateurs trouvent davantage de nourriture, ce qui fait augmenter leur nombre. Jusqu’au moment où les prélèvements sur la population de proies font diminuer celle-ci, rendant plus difficiles les rencontres prédateurs-proies, ce qui affecte en retour le nombre de prédateurs, qui tend alors à baisser. Ce modèle très simple, référencé sous le nom de Lotka-Volterra, produit donc des solutions périodiques, reproduisant les cycles observés par les pêcheurs de l’Adriatique. Une démarche comparable s’applique pour rendre compte de la propagation de certaines épidémies. À la fin des années 1990, des mathématiciens de l’université Bordeaux-II, en collaboration avec des biologistes du laboratoire de biométrie, génétique et biologie des populations à Lyon, ont ainsi étudié la propagation du virus leucémogène félin (FeLV), un rétrovirus responsable d’un syndrome d’immunodéficience et du développement de tumeurs chez les chats.

Modalités de l’infection par le FeLV chez le chat.

© Vincent Landrin, d’après La Démarche diagnostique de l’infection par le FeLV : synthèse et conseils aux praticiens, thèse d’Aline Pfister, 2010.

L’intérêt de cette étude réside dans le fait que les résultats peuvent être facilement confrontés à de nombreuses données expérimentales et qu’il paraît raisonnable d’étendre la démarche à la propagation d’autres virus du même type, comme le virus de l’immunodéficience humaine (VIH). Exposés au FeLV, les animaux peuvent soit s’infecter de manière chronique, auquel cas leur mortalité devient plus élevée et leur natalité plus faible, soit s’immuniser, ce qui n’affecte pas leur capacité de reproduction ni leur durée de vie. Les caractères infectés ou immuns s’acquérant pour la vie, les individus se répartissent en trois classes ou « compartiments » : les chats infectés, les chats immunisés et les chats sains n’ayant jamais été en contact avec le virus. L’évolution de la population globale se décrit en termes d’équations différentielles, la dynamique étant régie d’une part par les taux de mortalité et de natalité propres à chaque compartiment et d’autre part par les probabilités de rencontres entre individus qui sont à l’origine du possible changement d’état, de sain vers infecté ou immunisé. Ces systèmes différentiels font apparaître plusieurs états stationnaires possibles suivant les valeurs des différents paramètres du modèle : dans certains cas, l’infection s’éteint ; dans d’autres, elle reste présente. Ce travail permet de rendre compte de la dynamique du FeLV et d’évaluer comment il affecte une population de chats. Le modèle mathématique donne aussi la possibilité de comparer l’efficacité de campagnes de vaccination ou d’élimination des individus infectés. Il montre que la proportion de chats qu’il faudrait vacciner pour enrayer l’épidémie est inférieure à la proportion de chats infectés qu’il faudrait euthanasier pour parvenir au même résultat, une conclusion à confronter au coût de ces opérations. Des raisonnements similaires sont applicables à de nombreuses situations issues des sciences de la vie, et la modélisation peut s’enrichir par la prise en compte de dépendances spatiales. On obtient alors des systèmes d’équations aux dérivées partielles de type réaction-diffusion, pour lesquels la variété des comportements des solutions est encore plus riche !

Réguler la circulation routière

Les activités humaines influencent notre environnement et leur gestion suscite de nouvelles questions mathématiques. La compréhension du trafic routier en est un exemple. On a vu apparaître dès les années 1930 des travaux concernant la modélisation de ce trafic. Ils ont pendant longtemps été l’apanage d’ingénieurs cherchant à prédire les flux, dimensionner les infrastructures ou optimiser l’écoulement du trafic selon un point de vue relativement pragmatique (mécanismes de formation et de résorption des embouteillages, optimisation des flux, prévention de la pollution, étude d’impacts de l’installation de nouveaux dispositifs de circulation, etc.). Mais la nécessité d’une gestion plus efficace et plus sûre des transports routiers, combinée à la montée des préoccupations environnementales, s’est traduite par un effort substantiel afin de disposer d’outils de modélisation et de prévision du trafic plus performants et sophistiqués. En France, l’Institut français des sciences et technologies des transports, de l’aménagement et des réseaux (Ifsttar) est un institut de recherche dépendant du ministère de l’Écologie, du Développement durable et de l’Énergie et du ministère de l’Enseignement supérieur et de la Recherche dont une partie des équipes travaillent spécifiquement sur ces questions.

De très nombreux modèles s’expriment sous la forme de systèmes d’équations différentielles ordinaires qui couplent de manière non linéaire les positions et les vitesses d’un ensemble de véhicules. Une autre approche consiste à s’inspirer des concepts de la mécanique des milieux continus et à décrire l’écoulement des véhicules sur une route comme celui d’un fluide dans un canal. Les inconnues dans ce type de description sont la densité et la vitesse locales des véhicules. Une approche un peu naïve repose sur l’hypothèse que la vitesse est une simple fonction de la densité. Par exemple, si n(t,x) désigne la densité, dépendant des variables de temps et d’espace, on suppose que la vitesse est donnée par la formule suivante : V0 . (1 – n). Moins il y a de véhicules, plus la vitesse est élevée et proche de la vitesse limite V0. Si la densité s’approche du seuil n = 1, la vitesse d’écoulement s’annule : un embouteillage s’est formé. L’équation aux dérivées partielles qui résulte de cette hypothèse, attribuée à Michael Lighthill, Gerald Whitham et Lorenzo Richards, relève de la théorie, bien établie, des lois de conservation scalaires. Une telle description reste néanmoins un peu fruste. On a alors cherché à enrichir la modélisation en écrivant plutôt un système d’équations pour le couple densité-vitesse directement inspiré de la structure des équations régissant l’écoulement d’un fluide parfait. Mais les lois physiques de la mécanique des fluides s’appliquent mal au trafic routier. Un article au titre sans appel, « Requiem for Second-Order Fluid Approximation of Traffic Flows », paru en 1994, condamnait ce type d’approche en pointant les conclusions aberrantes auxquelles il pouvait mener. Deux défauts notamment paraissaient totalement rédhibitoires : d’une part, les équations prévoient que, dans certaines configurations, les véhicules peuvent partir en marche arrière ; d’autre part, une partie de l’information contenue dans les équations se propage plus vite que les véhicules, alors que ceux-ci sont soumis à une vitesse maximale !

Au début des années 2000, deux mathématiciens niçois, Michel Rascle et son élève Abdallahi Bechir Aw, ont répondu en publiant un travail au titre en forme de clin d’œil : « Resurrection of “Second Order” Models of Traffic Flow ». Ils y proposent une révision conceptuelle profonde de ces systèmes, apte à corriger ces défauts majeurs. Leur apport consiste à traduire dans les équations les comportements des conducteurs et à y incorporer ce en quoi ils diffèrent de ceux des molécules de gaz ! Ainsi, l’observation montre qu’un conducteur qui suit une forte densité de véhicules ayant une vitesse plus grande que la sienne a tendance à accélérer plutôt qu’à freiner. Ce travail a eu un impact très important. D’un point de vue technique, ces nouvelles équations ont enrichi la théorie des systèmes hyperboliques et des lois de conservation en y apportant une série de questions et de défis originaux, nécessitant l’introduction de méthodes d’analyse mathématique spécifiques. D’un point de vue pratique, elles ont permis une amélioration des outils de prédiction des conditions de circulation.

Depuis, ce système d’équations a été repris, sophistiqué et adapté à des situations toujours plus complexes. Par exemple, dans sa version initiale, le modèle n’impose pas de limite au nombre de véhicules par mètre carré de voie de circulation. Afin de le rendre plus réaliste, la description doit prendre en compte cette contrainte qui, si elle semble très naturelle d’un point de vue pratique, n’est pas aisée à mettre en équations. Ces équations peuvent être complétées en décrivant la circulation sur plusieurs voies, en distinguant différentes classes de véhicules (camions, voitures, deux-roues, etc.), en incorporant des limitations de vitesse imposées de façon variable sur un tronçon de route ou la présence de jonctions et de croisements.

Au cœur des enjeux contemporains

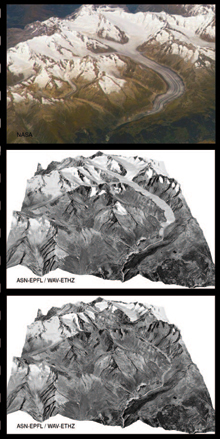

Évolution du glacier d’Aletsch. En haut, photographie aérienne prise en 2006. Simulations à l’horizon 2050 (au centre) et 2100 (en bas). © Guillaume Jouvet/EPFL/ETHZ

Les mathématiques peuvent servir d’outil d’aide à la décision, notamment pour fournir des éléments de réflexion en vue de choix politiques dont certains engagent des sommes conséquentes pour ne produire des effets qu’à des échéances beaucoup plus lointaines. Les problématiques liées à l’évaluation du réchauffement climatique et de ses conséquences illustrent de tels enjeux. Ainsi, le recul des glaciers tout à fait sensible aujourd’hui pourrait être lié à l’élévation globale de la température. L’étude mathématique de ce phénomène permet de mieux appréhender ce lien et de tester l’effet de différents scénarios sur l’évolution future des grands glaciers.

La description des glaciers est extrêmement complexe. Ce sujet a laissé les scientifiques perplexes pendant longtemps et ce n’est qu’au cours du XIXe siècle que les premiers modèles ont été élaborés. Pour résumer, la difficulté provient de leur comportement hybride car ils partagent à la fois les caractéristiques des fluides et celles des solides. La thèse de Guillaume Jouvet, soutenue en 2009, propose des développements originaux et tout à fait remarquables sur le sujet, fruits d’une collaboration poussée avec des glaciologues. Sur les longues échelles de temps qui sont pertinentes ici, on peut considérer que le glacier s’écoule sur la roche comme un fluide visqueux soumis à son propre poids. Par ailleurs, lorsque la température de la roche est suffisamment élevée, la glace peut s’en détacher et glisser comme un solide sur un plan incliné. Enfin, le glacier évolue aussi par échange de masse avec l’extérieur : les précipitations neigeuses le régénèrent alors que le rayonnement solaire et le vent contribuent à sa fonte.

Ces effets sont pris en compte à partir des mesures de température et de précipitations. Techniquement, on est confronté à un problème à frontière libre : le domaine occupé par la glace se modifie au cours du temps. Ce modèle mathématique est analysé dans la thèse et des théorèmes précis donnent une base rigoureuse à la description proposée. Les résultats sont validés par la confrontation avec les données climatiques recueillies pendant plus d’une centaine d’années sur le glacier du Rhône et le glacier d’Aletsch (voir ci-contre). L’outil numérique permet alors de prédire leur devenir suivant diverses hypothèses d’évolution climatique. Les résultats montrent une tendance forte au retrait, pouvant aller jusqu’à la disparition complète du glacier du Rhône sur une échelle de temps de l’ordre de la centaine d’années.

Tous ces exemples montrent que les mathématiques sont une science ouverte sur la société et enrichie par ses interactions avec les autres disciplines scientifiques et l’ingénierie. Les progrès les plus sensibles résultent d’un continuum d’efforts, englobant les développements des plus théoriques jusqu’aux plus pratiques. Le mathématicien apporte un point de vue particulier, qui lui est tout à fait propre, résultat de sa formation et de sa sensibilité. Il ne voit pas dans les équations la même chose que le physicien, le biologiste ou l’ingénieur. Son apport est donc complémentaire : il met des couleurs différentes sur sa palette, mais il contribue indiscutablement à la beauté du tableau !

- Site de la revue Interstices.

- Site de la revue Images des maths du CNRS.

- Page personnelle de Guillaume Jouvet contenant des simulations numériques.

Cet article est paru dans la revue Textes et documents pour la classe (TDC) n° 1062 « Les mathématiques de la Terre », éditée par le CNDP, en partenariat avec Inria et à l’initiative du comité éditorial d’Interstices.

Newsletter

Le responsable de ce traitement est Inria. En saisissant votre adresse mail, vous consentez à recevoir chaque mois une sélection d'articles et à ce que vos données soient collectées et stockées comme décrit dans notre politique de confidentialité

Niveau de lecture

Aidez-nous à évaluer le niveau de lecture de ce document.

Votre choix a été pris en compte. Merci d'avoir estimé le niveau de ce document !