Des robots capables de faire face à des environnements ouverts

Les robots autonomes actuellement déployés sont programmés pour faire face à des situations bien identifiées. Cette connaissance de l’environnement est utilisée par le concepteur du robot pour définir le comportement approprié, que le robot soit destiné à assembler des voitures ou à nettoyer le sol. Ces robots sont incapables de s’adapter à des contextes nouveaux ou de résoudre des tâches imprévues par leur concepteur car ce sont des robots spécialisés. Le problème est que toutes les tâches ne peuvent pas être décrites avec une précision suffisante : ranger une chambre ou vider un lave-vaisselle par exemple, nécessite de s’adapter à des conditions très variables d’une habitation à une autre. À ce jour, il n’y a pas de comportement préconçu qui puisse résoudre ces tâches quelles que soient les conditions, contrairement au problème du nettoyage des sols que les robots aspirateurs résolvent très bien avec un assemblage de comportements robustes. De même, un concepteur de robot doit savoir à l’avance la ou les tâches que le robot devra accomplir. Un robot destiné à vider le lave-vaisselle ne pourrait pas plier des serviettes sans disposer du programme adéquat. Cette limitation reste un frein important dans de nombreux domaines d’application, notamment pour le développement de robots de service qui s’adapteraient à la grande variabilité de nos environnements quotidiens, mais aussi des tâches qu’ils auraient à effectuer pour être véritablement utiles.

Des algorithmes s’adaptant à la variabilité des environnements

Le domaine de l’apprentissage machine a connu de nombreuses évolutions ces dernières années, permettant le développement de nouveaux algorithmes « censés » gérer une telle variabilité, tant dans la définition de la tâche que dans le contexte de son exécution. Par exemple, la branche de l’apprentissage appelée « apprentissage par renforcement », permet de découvrir un comportement approprié à partir du moment où la tâche est décrite par une récompense : un algorithme d’apprentissage par renforcement explore les comportements possibles pour maximiser cette récompense et donc résoudre la tâche posée. Ces algorithmes nécessitent cependant de définir des éléments de base sur lesquels ils vont s’appuyer, éléments que l’on peut regrouper sous la forme d’un processus de décision Markovien.

Un tel processus est décrit par :

- les actions possibles,

- les états dans lesquels le robot peut être, ces états devant être non ambigus et contenir une information suffisante pour déterminer le comportement approprié,

- la fonction de récompense

- et éventuellement, la fonction de transition, qui décrit comment une action va changer l’état. Le comportement trouvé par apprentissage associera une action à un état donné.

Les actions utilisées définissent donc l’espace des possibles pour le robot et l’espace des états définit l’information qu’il est capable de prendre en compte. Cette information définit les capacités du robot, mais aussi ses incapacités puisqu’il ne pourra rien faire qui ne puisse être décrit sur la base de ces actions et de ces états. Plus ces espaces sont larges, plus l’apprentissage sera long et difficile, c’est ce qu’on appelle la malédiction de la dimensionnalité. Il existe donc une tension entre un espace d’actions et d’états possibles larges, qui pourraient ainsi couvrir un grand nombre de situations, mais qui vont compliquer l’apprentissage, et des espaces bien choisis, spécifiques à une tâche donnée qui permettront un apprentissage rapide et efficace. Il est notoire que ce choix est critique en robotique où les actions et les perceptions sont bruitées (c’est-à-dire qu’il y a des erreurs, des informations inutiles qui brouillent quelque peu l’information utile), en grandes dimensions et continues plutôt que discrètes.

Régulièrement confrontés aux mêmes défis dans notre vie quotidienne, nous sommes pourtant capables de résoudre efficacement ces problèmes sur lesquels bute la robotique. D’après des psychologues comme Annette Karmiloff-Smith, cela est dû à notre capacité à changer la représentation de nos connaissances. Cela nous permet de trouver progressivement les représentations les plus appropriées pour résoudre les problèmes auxquels nous sommes confrontés, car, comme l’a dit Stephen Hawking, trouver la bonne formulation d’un problème permet souvent de le résoudre. Dans le cadre du projet de recherche européen DREAM, cette problématique a été incluse dans les algorithmes d’adaptation développés. Cela signifie que l’on s’intéresse à la construction d’espaces d’états et d’espaces d’actions pertinents plutôt que de les considérer comme donnés. Chaque état ainsi découvert doit rendre accessible l’information nécessaire pour décider de l’action à choisir, mais doit aussi permettre de comprendre à quoi est associée une récompense donnée au robot. Les actions doivent permettre de se déplacer dans cet espace d’état aussi efficacement que possible.

Une approche inspirée de l’apprentissage des enfants par étapes

Construire ces représentations est une problématique qui occupe désormais une importance croissante en robotique. L’apprentissage profond par exemple peut générer de telles représentations, mais ces algorithmes nécessitent une grande quantité de données du robot interagissant avec son environnement. On s’intéresse alors à la génération de ces données lorsqu’on manque d’informations sur l’environnement. L’approche proposée dans le cadre du projet DREAM est itérative. Elle s’inspire du développement de l’enfant par étapes proposé par Jean Piaget et décompose ce processus global en une séquence de processus. Il n’y a donc pas un processus unique qui va générer les espaces d’états et d’actions pertinents, mais une succession de processus en charge d’enrichir l’information disponible jusqu’à ce qu’elle soit suffisante pour construire la représentation appropriée. Certains de ces processus se déroulent en interaction avec le monde réel, d’autres en sont déconnectés. Le robot développé au sein du projet DREAM dispose donc de l’équivalent de l’état de sommeil pour consolider les connaissances, explorer de nouvelles alternatives en simulation ou découvrir ces nouvelles représentations.

Des robots qui apprennent

Doter les robots de créativité

Ce processus soulève une question cruciale : comment découvrir des comportements intéressants si les représentations appropriées ne sont pas encore connues ? Les algorithmes développés doivent doter le robot d’une forme de créativité, prise dans le sens de la capacité à générer des comportements à la fois efficaces et allant au-delà des connaissances initialement disponibles. La créativité dont il est question ici n’est pas la créativité artistique, mais la créativité à laquelle on ne pense pas tant elle nous semble évidente, la créativité dont chacun de nous est doté et qui nous permet d’aller au-delà de ce que l’on a explicitement appris dans nos gestes quotidiens, celle qui nous permet par exemple de pousser une porte avec le coude si on a les mains prises. C’est cette forme de créativité qui fait défaut aux robots pour qu’ils puissent gérer la variabilité de notre environnement.

Alors comment doter les robots d’une telle créativité ? La théorie développée notamment par les professeurs Arne Dietrich spécialisé en neurosciences cognitives et Hilde Haider, spécialisée en psychologie cognitive est que la créativité humaine serait le résultat d’un processus de variation et de sélection associé à une capacité de prédire l’intérêt d’une idée. Seules les idées reconnues comme intéressantes passeraient le seuil de notre conscience et créeraient l’effet « Eurêka » d’Archimède. C’est pourquoi les scientifiques impliqués dans le projet DREAM ont utilisé des algorithmes évolutionnistes inspirés de ces processus de variation et de sélection pour ajouter cette composante de créativité à notre processus d’adaptation. Ils se sont servis en particulier des algorithmes dits d’illumination pour découvrir de nombreuses façons de générer un effet particulier, par exemple pour lancer des balles ou manipuler un joystick. Ils combinent une approche évolutionniste de ce type avec des modules en amont, pour découvrir des objets et identifier leur forme et des modules en aval qui s’appuient sur les comportements ainsi découverts pour résoudre des tâches ou générer de nouvelles représentations plus appropriées.

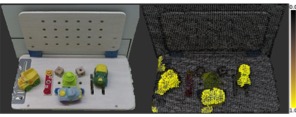

Exemple de carte correspondant à l’effet « poussable ». (À gauche) ce que perçoit la caméra du robot, (à droite) ce qui est reconnu comme « poussable » après plusieurs interactions.

Les modules en amont utilisent des primitives motrices pour interagir avec l’environnement du robot et identifier les parties de l’environnement associées à un effet particulier (être « poussable », attrapable, …). Il s’agit alors de s’appuyer sur le concept des affordances pour segmenter l’environnement et découvrir sa structure. Les affordances sont un concept venant du psychologue J.J. Gibson qui lie la perception à la capacité d’action d’un être vivant et, par extension, d’un robot : les perceptions sont influencées par les actions que le système peut réaliser et les effets qu’il peut ainsi obtenir. Cela permet de se focaliser sur ce qui est important pour le système et d’ignorer les informations non pertinentes. Cet algorithme génère, après interaction du robot avec son environnement une carte perceptive indiquant quelle partie de l’environnement permet un effet particulier (attrapable ou poussable par exemple). Cette information structurelle peut ensuite être utilisée pour se concentrer sur un élément et apprendre plus en détail sa forme et ses différentes caractéristiques et ainsi créer la notion d’objet qui sera utilisée aux étapes ultérieures, par exemple pour explorer, en simulation par les méthodes évolutionnistes évoquées précédemment, comment on peut interagir avec cet objet et quels effets on peut ainsi obtenir.

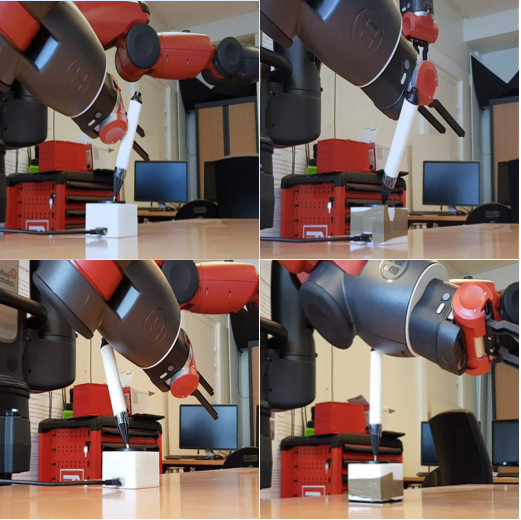

Exemples de mouvements manipulant le joystick générés par l’algorithme évolutionniste.

Le module évolutionniste génère des milliers de manières d’interagir avec un objet, de le lancer, de le manipuler. Cette nouvelle compétence peut alors être utilisée pour résoudre des tâches impliquant ces différentes interactions avec l’avantage de pouvoir les générer de différentes façons. Dans un des exemples traités, le robot est amené à interagir avec un joystick pour piloter un autre robot à distance. Certains des mouvements qu’il réalise utilisent la pince du robot, mais d’autres utilisent le coude, lui donnant ainsi la possibilité d’utiliser le joystick même si sa pince est occupée par la saisie d’un objet par exemple. Ces différents exemples peuvent également être analysés pour découvrir les éléments pertinents afin de bien reproduire l’interaction (quelle partie de l’objet est importante pour l’interaction, par exemple) et construire de nouveaux espaces d’états ou d’actions.

Conclusion

Le projet de recherche fondamentale DREAM propose une autre vision de la robotique pour rendre un robot humanoïde capable de s’adapter à un environnement variable. Cette approche consiste avant tout à limiter les connaissances nécessaires à la programmation du robot concernant la tâche et l’environnement dans lequel elle doit être réalisée. Elle consiste à lui permettre de découvrir, de façon autonome, ces connaissances en interagissant avec l’environnement, comme le font les êtres vivants pendant leur développement.

Les robots super-spécialistes actuels peuvent réaliser une tâche connue avec une précision surhumaine parce que des ingénieurs ont passé suffisamment de temps à essayer de comprendre ce qui est important pour réussir cette tâche et quels gestes précis le robot doit réaliser. Un robot capable de s’adapter est un robot qui, par définition, ne sera pas systématiquement adapté dès les premières minutes de son déploiement dans un nouvel environnement ou sur une nouvelle tâche. De tels robots feront donc des erreurs et en auront besoin pour apprendre. Si la minimisation de ces erreurs sera clairement un objectif de recherche, il sera très probablement impossible de les supprimer totalement. Les utilisateurs intéressés par ce type de robot devront donc l’accepter car ce ne sera pas le symptôme d’une panne, mais une de leurs caractéristiques. Les robots actuels peuvent cependant aussi se tromper. Un robot plongé dans un environnement non contrôlé et complexe comme notre environnement quotidien peut faire des erreurs car il est difficile pour un ingénieur de prévoir toutes les situations. Les robots aspirateurs ou tondeuses à gazon peuvent ainsi se coincer dans certains cas. Si les erreurs ne sont pas acceptables dans certaines applications — pour des véhicules autonomes par exemple — dans de nombreuses autres situations, des erreurs sont, ou devraient être, acceptables, à partir du moment où elles n’ont pas de conséquences problématiques.

À la différence des robots actuels, les robots adaptatifs apprendraient de leurs erreurs et trouveraient rapidement un comportement plus approprié là où les robots actuels doivent attendre qu’un ingénieur se penche sur le problème et mette à jour leur programme. Si une telle approche est envisageable pour des robots envoyés sur Mars, qui disposent d’une équipe d’ingénieurs les surveillant en permanence, elle est plus difficile à mettre en œuvre sur des robots à bas coûts, qui n’auraient de plus pas les capteurs indispensables aux ingénieurs pour identifier les problèmes. L’ajout de capacités d’adaptation autonome est alors une alternative prometteuse pour ouvrir la robotique à des environnements complexes et non préparés.

Pour en savoir plus, voir aussi «Des robots qui apprennent ».

Newsletter

Le responsable de ce traitement est Inria. En saisissant votre adresse mail, vous consentez à recevoir chaque mois une sélection d'articles et à ce que vos données soient collectées et stockées comme décrit dans notre politique de confidentialité

Niveau de lecture

Aidez-nous à évaluer le niveau de lecture de ce document.

Votre choix a été pris en compte. Merci d'avoir estimé le niveau de ce document !

Stéphane Doncieux

Professeur, responsable de l'équipe AMAC de l'Institut des Systèmes Intelligents et de Robotique (ISIR) et coordinateur du projet de recherche européen DREAM.