Arkangel dans Black Mirror : la réalité diminuée

Cet article est publié en partenariat avec le blog Binaire, dans sa série Le divulgâcheur.

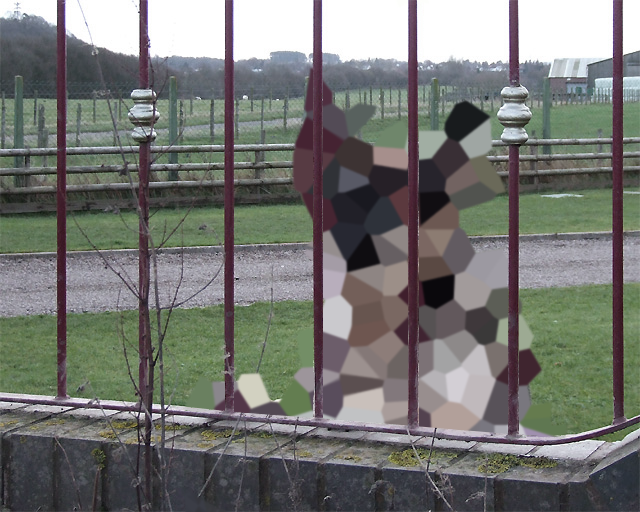

Dans l’épisode Arkangel de Black Mirror, suite à un incident durant lequel elle perd de vue sa fille, une mère surprotectrice décide de l’inscrire à un essai gratuit d’une version préliminaire d’Arkangel, un système révolutionnaire de surveillance pour enfants. Arkangel est une technologie qui, grâce à l’implantation d’une puce dans le cerveau des enfants, permet aux parents de suivre en temps réel leur localisation et leur état médical via une tablette. Il offre également la possibilité de consulter la vision de l’enfant en direct, d’enregistrer et de rejouer tout ce qu’il a vu, et de censurer l’obscénité et autres stimuli stressants par pixellisation (voir Figure 1) et distorsion audio. L’épisode tourne autour de la mère protectrice et de sa fille pour montrer à quel point une telle technologie pourrait être dangereuse et porter atteinte à la vie privée, selon le schéma classique de la série télévisée.

Figure 1 : Reproduction d’une scène de Black Mirror, où un chien en colère est censuré visuellement par l’implant cérébral Arkangel. Photo originale de Roger Kidd, CC BY-SA 2.0.

Malgré les problèmes évidents de protection de la vie privée et d’éthique ainsi que l’avenir dystopique que présente l’épisode, la censure visuelle automatique peut potentiellement répondre à de réels besoins utilisateurs. Environ deux ans avant la sortie de l’épisode de Black Mirror, notre équipe de recherche a commencé à travailler sur la façon de réduire l’effet répulsif des photos d’interventions chirurgicales en appliquant un traitement d’image automatique. Bien que l’aversion pour des images chirurgicales soit naturelle pour la plupart d’entre nous, elle limite la capacité de nombreuses personnes à se renseigner, à prendre des décisions informées ou plus simplement à satisfaire leur curiosité. Par exemple, parce que de nombreux patients trouvent les images ou les vidéos chirurgicales répugnantes, la communication avec leur chirurgien peut en souffrir. Nos recherches se sont concentrées sur la possibilité d’utiliser des techniques de traitement d’images existantes qui pourraient réduire l’impact émotionnel des images d’interventions médicales, tout en préservant l’information importante. En effet, il est facile de rendre une image pratiquement méconnaissable comme dans l’épisode de Black Mirror (voir Figure 1), mais cela supprimerait toute information utile que l’image était censée transmettre. Afin d’identifier les techniques qui conservent le plus d’informations utiles, nous avons demandé à quatre chirurgiens de nous faire parvenir des photos de leurs interventions. Nous avons ensuite transformé ces photos en appliquant treize techniques différentes, imprimé les images et demandé aux chirurgiens de les ordonner en fonction de leur capacité à préserver les informations importantes. Ce faisant, nous avons éliminé sept techniques qui ont été considérées comme supprimant trop d’informations utiles à une bonne communication avec les patients.

Figure 2 : GIF animé montrant les six techniques testées sur des non-spécialistes. Nous utilisons ici des lasagnes car leur photo est moins choquante que des images chirurgicales.

Nous avons ensuite testé les six autres techniques de traitement d’images sur des non-chirurgiens (visibles sur l’animation de la figure 2) pour comprendre lesquelles seraient le plus à même de réduire l’impact émotionnel des images de chirurgie. Puisqu’il fallait exposer les gens à des images chirurgicales potentiellement dérangeantes, l’obtention de l’approbation éthique pour notre étude a été un long processus itératif. Nous avons montré aux participants des images chirurgicales non filtrées et filtrées, et leur avons demandé d’évaluer dans quelle mesure ils les trouvaient dérangeantes. Selon nos résultats, l’une des techniques les plus prometteuses a été une technique d’abstraction d’images mise au point à l’Institut Hasso Plattner de l’Université de Postdam, en Allemagne, qui utilise un filtrage structure-adaptatif à partir des couleurs pour donner aux images un aspect bande dessinée (voir Figure 3). Cette technique a diminué les réactions affectives négatives des participants tout en préservant une grande partie du contenu informationnel. Certains de nos participants ont signalé que les images étaient moins dérangeantes parce que leur aspect bande dessinée les rendait moins réelles. Dans une étude suivante avec cinq chirurgiens, nous avons montré que des filtres similaires peuvent également être appliqués avec succès aux vidéos.

Figure 3 : Abstraction de type « bande dessinée » de l’image de lasagnes à l’aide d’une technique appelée filtrage structure-adaptatif.

Bien que nos recherches se soient concentrées sur les images et les vidéos de chirurgie, les techniques de censure visuelle automatique pourraient être utilisées pour d’autres types de contenus dérangeants, tels que les images hyper-violentes ou pornographiques. Il est clair qu’avec le développement du web et des réseaux sociaux, le contenu explicite est, aujourd’hui plus que jamais, facilement, et souvent par inadvertance, accessible. Par exemple, les enfants qui naviguent sur le Web pour des projets scolaires courent le risque d’être exposés par inadvertance à du contenu explicite [1]. Wikipédia, par exemple, contient des images ou des vidéos qui peuvent être jugées choquantes ou inappropriées pour certains publics. De même, les réseaux sociaux permettent actuellement aux gens de publier du contenu potentiellement choquant, comme le soulignent les conditions d’utilisation de Facebook ou de Twitter. Si l’interdiction de tout contenu explicite est possible, il est souvent avancé que ce genre de contenu peut informer ou sensibiliser le public, par exemple sur des questions politiques ou sanitaires. Ainsi, les rédactions en chef de journaux ont justifié leur utilisation de photos violentes en expliquant qu’elles aident à informer leur lectorat. De même les associations de défense des droits des animaux telles que L214 et Red Pill en France ou PETA, PEA à l’étranger diffusent régulièrement les photos et vidéos de leurs enquêtes dans les abattoirs ou élevages sur les réseaux sociaux afin d’informer le public, mais ces images sont ignorées par une majorité du public en raison de leur contenu choquant. Enfin, des études ont suggéré que les logiciels destinés à protéger les enfants bloquent également l’accès à des informations utiles et pourraient donc avoir un impact négatif sur les processus d’apprentissage.

Pour aider à rendre la navigation sur Internet informative mais sans risque pour les publics sensibles, nous avons développé une extension Google Chrome que nous avons nommée Arkangel, en hommage à l’épisode de Black Mirror. Notre Arkangel utilise des réseaux neuronaux pour trouver, dans une page web, les images susceptibles de contenir du contenu médical, de la violence ou de la nudité, et les traiter avant que l’utilisateur ne puisse les voir. Dans le même temps, Arkangel laisse à l’utilisateur la possibilité (1) de déterminer l’intensité du traitement de l’image et (2) de dévoiler l’image originale. Bien que nous n’ayons testé empiriquement les techniques de traitement que sur des images chirurgicales, nous supposons qu’elles pourraient également fonctionner de manière similaire sur toute image impliquant du sang ou des mutilations, comme les photographies de guerre ou d’accident. Nous imaginons que les mêmes filtres ou des filtres semblables peuvent aussi aider à réduire l’impact psychologique d’autres contenus fréquemment jugés répugnants (par exemple des photos de maladies de la peau, de vomissements ou d’excréments) ou de la pornographie. Il est néanmoins nécessaire de conduire des études supplémentaires afin de valider ou d’infirmer ces hypothèses. Malgré le nom que nous avons donné à notre extension Google Chrome, son but est fondamentalement différent de l’outil présenté dans l’épisode de Black Mirror. Alors que l’Arkangel de Black Mirror se concentrait sur l’idée de protéger les enfants des stimuli que leurs parents jugent potentiellement dérangeants, nous avons développé notre extension Arkangel dans l’espoir qu’elle aidera les gens à s’informer en s’exposant à du contenu qu’ils auraient évité autrement. Ainsi, son but n’est pas de restreindre, mais d’aider les utilisateurs à pouvoir accéder aux médias nécessaires à leurs recherches. Cependant, il est nécessaire de rester vigilants pour que ces outils restent sous le contrôle total de l’utilisateur et ne soient jamais imposés à d’autres contre leur gré.

Quel avenir pour les technologies de censure visuelle automatique ?

Un obstacle important réside dans la reconnaissance automatique de contenus potentiellement dérangeants : aujourd’hui, les machines ne peuvent le faire que dans les cas les plus évidents. Un autre problème réside dans le matériel informatique utilisable. Il est peu probable que dans un avenir proche, les gens souhaitent que des puces soient implantées dans leur cerveau ou dans le cerveau de leurs proches. De plus, malgré les recherches actuelles sur l’électronique implantable (et la possibilité d’augmenter cybernétiquement des requins ou des insectes), de telles technologies sont encore loin d’être prêtes aujourd’hui. Il est cependant possible d’imaginer que des technologies de censure visuelle personnelle deviendront disponibles sur les appareils portables. Les lunettes pourraient être un support idéal, et certaines d’entre elles comprennent déjà des implants auditifs. Il est facile d’imaginer que certaines modifications d’appareils comme les Google Glasses pourraient les faire fonctionner de la même façon que l’implant cérébral Arkangel. Ils pourraient modifier ce que le porteur voit en ajoutant un flou local à la surface des lunettes et pourraient également censurer l’information auditive grâce à l’implant auriculaire intégré. Des casques antibruit sont actuellement disponibles sur le marché et démontrent la faisabilité d’une censure auditive en temps réel. Il est possible d’imaginer un processus similaire appliqué au champ visuel. Les travaux de recherche sur la réalité diminuée ont par exemple étudié comment les affichages de réalité augmentée peuvent être utilisés pour supprimer (plutôt que d’ajouter) du contenu au monde réel.

Munis de dispositifs de censure sensorielle entièrement personnalisables, de nombreuses personnes pourraient, par exemple, assister à des chirurgies en direct pour s’instruire. Les personnes sensibles seraient également capables de s’immuniser contre les actes d’agression non physiques tels que les jurons et leurs analogues visuels. Cependant, il est raisonnable de craindre que de tels outils ne fassent que fragiliser les populations sensibles en les privant d’occasions de développer une résistance à des événements de la vie de tous les jours. De tels outils pourraient également nous rapprocher de scénarios de suppression des libertés individuelles comme celui illustré dans l’épisode Black Mirror. Par exemple, il n’est pas difficile d’imaginer comment des lunettes de censure sensorielle pourraient être complétées par une carte SIM, de petites caméras et des capteurs de signes vitaux, afin que les parents puissent surveiller et contrôler leurs enfants comme jamais auparavant. Pire encore, les technologies portables de censure perceptuelle pourraient être utilisées à mauvais escient par des organisations militaires ou terroristes afin de faciliter les actes de torture ou de meurtre. Par exemple, de telles technologies pourraient changer la couleur du sang, faire apparaître le monde comme un dessin animé, ou bien faire croire que les ennemis sont des créatures répugnantes comme l’illustre un autre épisode de Black Mirror : Men Against Fire. Elles pourraient même être utilisées pour prétendre que les événements réels font partie d’une simulation, un thème repris dans Ender’s Game d’Orson Scott Card.

Bien que nous nous soyons concentrés sur la façon dont la censure visuelle peut être utilisée pour aider les gens à s’éduquer en éliminant un obstacle potentiel au libre accès à l’information, la censure visuelle peut aussi être extrêmement utile aux personnes dont le travail quotidien consiste à regarder des contenus troublants, comme les journalistes ou les modérateurs de contenus en ligne. De récents reportages et documentaires sur la santé mentale des modérateurs travaillant pour des réseaux sociaux tels que Facebook, Twitter ou Youtube, ont souligné la difficulté de leur travail. Ils doivent regarder du contenu particulièrement violent et choquant tout au long de leur journée de travail pour comprendre si le média affiché enfreint ou non les conditions d’utilisation du service. Pour ce faire, ils doivent clairement identifier l’information présentée dans les médias, mais cela peut se faire au détriment de leur santé mentale à long terme. Nous espérons que des filtres comme notre extension de navigateur Arkangel pourront les aider dans leur tâche. Des difficultés similaires semblent être au centre des préoccupations de certaines salles de rédaction lorsqu’elles doivent regarder des dizaines de photos ou de vidéos de zones de guerre pour décider lesquelles utiliser. Notre étude a déjà suggéré que les techniques d’abstraction d’images peuvent réduire la réponse affective aux images chirurgicales tout en préservant les informations essentielles de l’image, et il serait intéressant d’étudier si elles peuvent aussi être utilisées pour réduire l’impact que la modération de contenu ou les tâches de sélection d’images peuvent avoir sur la santé mentale des travailleurs.

Plus d’informations sur notre extension pour Google Chrome sont disponibles dans la vidéo de ce TEDx donné par un des membres de l’équipe de recherche.

[1] On appelle « contenu explicite » des documents (textes, images, vidéos…) contenant des aspects pouvant choquer le public (violence, pornographie, insultes…). Cette expression est issue du monde de la chanson où elle est utilisée depuis très longtemps.

Newsletter

Le responsable de ce traitement est Inria. En saisissant votre adresse mail, vous consentez à recevoir chaque mois une sélection d'articles et à ce que vos données soient collectées et stockées comme décrit dans notre politique de confidentialité

Niveau de lecture

Aidez-nous à évaluer le niveau de lecture de ce document.

Votre choix a été pris en compte. Merci d'avoir estimé le niveau de ce document !