Images de synthèse : palme de la longévité pour l’ombrage de Gouraud

Dans le monde informatique, combien de méthodes algorithmiques résistent à l’usure du temps ? Assurément très peu, les chercheurs et les développeurs améliorant en permanence les performances des solutions existantes, ou bien en inventant de nouvelles. Il y a au moins une exception à ce constat, une innovation qui, malgré l’augmentation de la puissance des ordinateurs et l’évolution des logiciels, reste d’actualité, toujours utilisée depuis bientôt… 40 ans ! Et pas dans n’importe quel domaine : celui des images de synthèse, et par conséquent dans ceux des jeux vidéos, des effets spéciaux du cinéma, de la conception assistée par ordinateur (CAO) dans l’industrie automobile, aéronautique ou aérospatiale, des logiciels d’architecture, de la réalité virtuelle…

« Il n’y a qu’une seule explication à cela, avance discrètement Henri Gouraud, l’inventeur de la technique de rendu des images de synthèse 3D qui porte son nom : elle était à l’époque et elle reste aujourd’hui encore la technologie la plus simple, la plus économique pour obtenir des images 3D quasi-réalistes, en temps réel. » Elle est même utilisée aujourd’hui dans toutes les cartes graphiques 3D du marché des ordinateurs. Cela ne durera peut-être pas encore plusieurs décennies, car les technologies d’informatique graphique plus sophistiquées, beaucoup plus réalistes encore, profitent de la puissance des ordinateurs. Mais la prouesse n’en reste pas moins remarquable.

Revenons donc quelques années en arrière, lorsqu’en septembre 1968, Henri Gouraud, jeune homme de 24 ans, traverse l’Atlantique sur les conseils d’un de ses professeurs de Sup’Aéro pour rejoindre le département Informatique de l’Université de l’Utah (Salt Lake City) et l’équipe d’Ivan Sutherland. « L’informatique graphique m’intéressait, raconte Henri Gouraud. Parce que c’était concret : on voyait ce qu’on faisait. Mais je n’y connaissais rien. J’avais seulement fait du Fortran et du calcul numérique à l’Ecole Centrale, et commencé à découvrir l’informatique dans ma spécialisation Automatique et Informatique à Sup’Aéro. »

En revanche, Ivan Sutherland avait, quant à lui, déjà une certaine notoriété en la matière. Pionnier de ce domaine, au début des années 1960, il avait développé au Massachusetts Institute of Technology (MIT) ce qui est considéré comme la première application interactive graphique : Sketchpad.

SketchPad est le premier logiciel graphique interactif : il utilise un crayon optique et un écran cathodique et permet de générer une édition graphique de dessins techniques. Ces travaux d’Ivan Sutherland marquent ainsi le début de l’histoire de l’interaction homme-machine.

Ses travaux, publiés dans sa thèse, en 1963, décrivent les principes fondamentaux de l’infographie 3D et du vaste domaine de la conception assistée par ordinateur, la CAO, autrement dit le prototypage virtuel, qui deviendra, en quelques décennies, le modèle pour la conception de toute l’industrie automobile et aéronautique. Il propose à Henri Gouraud de travailler dans cette voie, sur la conception et la manipulation par ordinateur, en temps réel, d’objets 3D complexes, comme des pièces de structure automobile.

Quel était le contexte ? La synthèse d’images, création d’images numériques par ordinateur, était dans les limbes. Jusqu’à la fin des années 1960, ordinateurs et écrans d’affichage étaient évidemment à des années lumière des matériels actuels. Néanmoins, les bases de la modélisation des images étaient déjà posées. Le calcul par ordinateur de l’image d’un objet (que ce soit un capot de voiture, un avion ou un visage) repose sur la définition de sa forme à l’aide d’un modèle géométrique. Chaque objet peut être représenté par des facettes, des polygones, triangles, rectangles… qui décrivent l’enveloppe extérieure de n’importe quel solide.

À partir d’une structure en fil de fer, quelle est la face avant ?

À l’écran, cela se traduit par une juxtaposition de facettes représentées par leurs arêtes, ce qu’on appelle « la structure en fil de fer ». On voit tout simplement toutes les facettes que l’ordinateur a calculées. Prenons l’exemple d’un dé : son modèle numérique s’affiche avec ses six faces, comme s’il était transparent. L’intérêt de cette représentation simple est qu’elle pouvait être affichée en temps réel, avec le matériel de l’époque. Il existait des écrans (ADAGE, Tektronix…) que l’on utilisait un peu comme des tables à dessiner, en traçant des lignes, composant ainsi un dessin vectoriel dont les équations étaient décrites dans l’ordinateur, et que l’on pouvait ensuite manipuler, en modifier la longueur… « Mais dès que les objets dessinés étaient complexes, on n’y comprenait plus rien, les tracés des faces avant et arrière se mélangeaient » explique Henri Gouraud.

Beaucoup de recherches visaient, à ce moment là, à résoudre ce problème d’affichage, pour que seules les faces visibles de l’objet soient affichées, qu’on ne voie plus au travers. En particulier, le français Philippe Loutrel à New York avait publié une thèse sur ce sujet en 1967. Sa méthode de résolution faisait néanmoins appel à des calculs complexes qui posaient de délicats problèmes de précision. À l’Université de l’Utah, le directeur du département David Evans avait proposé une approche fondamentalement différente, beaucoup plus simple : effectuer les calculs non plus dans l’espace géométrique de l’objet – où la précision des nombres en question définit la précision du résultat – mais en fonction de l’écran – où la précision est dictée par sa résolution, c’est à dire le pixel. La thèse de John Warnock, également à l’université de l’Utah en 1969, a été la première à mettre en œuvre cette approche qui permettait en plus une représentation plus naturelle des objets, avec un aspect volumique, solide, une image opaque, bien plus réaliste.

« Mais ces images solides, comme celles sur lesquelles travaillait John Warnock, étaient bien plus longues à calculer, rappelle Henri Gouraud. Du coup, l’affichage était très lent. On devait utiliser un appareil photo, en pause pendant deux minutes devant l’écran, pour capter l’image complète ! » Les mémoires d’écran n’existaient pas encore. Les ordinateurs n’étaient pas capables de conserver les images calculées au fur et à mesure et de les afficher en balayage comme le font les écrans de télévision, au rythme d’une image tous les 1/30e de seconde. Justement, un autre thésard du labo, Gary Watkins, concevait un matériel d’affichage d’objets solides, en temps réel sur un écran de type TV. Sa technique était basée sur une comparaison des facettes entre elles pour déterminer leurs points d’intersection, éliminer les facettes cachées… « Tout à fait ce dont j’avais besoin » résume Henri Gouraud.

Restait néanmoins un problème de taille : « Pour représenter les pièces complexes auxquelles je m’intéressais, les facettes étaient trop anguleuses, poursuit Henri Gouraud. Je souhaitais utiliser des surfaces courbes comme celles proposées quelques années plus tôt par Coons ou Bézier. » Les surfaces (ou « carreaux ») de Bézier, inventées en 1962 par les ingénieurs français Paul de Casteljau (Citroën) et Pierre Bézier (Renault), permettaient de concevoir par ordinateur la surface de pièces de carrosseries par exemple. Le modèle était ensuite intégré dans une machine à commande numérique pour être usiné dans une mousse que l’on pouvait peindre pour avoir une idée réaliste de la pièce. Citroën et Renault étaient d’ailleurs précurseurs en CAO mais on était loin des applications interactives.

« Sauf que pour pouvoir tirer profit des algorithmes de John Warnock et de Gary Watkins pour supprimer les faces cachées et utiliser l’affichage en mode TV, il me fallait décomposer chaque surface de Bézier en une collection de facettes, reprend Henri Gouraud. Ce qui redonnait immanquablement un aspect anguleux à mes images. »

En effet, l’ombrage plat alors utilisé consistait simplement à affecter à chacune des facettes de l’objet un éclairement fonction de l’angle entre la normale à la facette et la direction de la source lumineuse éclairant la scène. Cette valeur est constante sur toute la facette, d’où la discontinuité d’ombrage entre les facettes adjacentes.

Là encore, Henri Gouraud a su contourner le problème et mettre à profit la diversité des approches qui étaient étudiées dans son environnement de recherche. « Il faut dire que l’université de l’Utah et en particulier notre département était une vraie pépinière de chercheurs en synthèse d’images » reconnaît-il. Il suivait le cours de traitement du signal du professeur Thomas Stockham. Celui-ci s’intéressait à la façon dont la rétine traite les images, avant de les envoyer au cerveau. Il supposait, à juste titre, qu’une meilleure compréhension de ces phénomènes permettrait d’améliorer l’affichage des images numériques, sur l’écran de l’ordinateur.

« Les théories de Thomas Stockham m’ont permis de voir les choses sous un autre angle (presque sans jeu de mot), reconnaît Henri Gouraud. J’ai compris que la rétine travaillait toujours à faire surgir le détail dans une image : un minuscule point dans une image blanche, les frontières entre les facettes… c’est d’ailleurs la raison pour laquelle diminuer leur taille était illusoire, puisque non seulement cela pénalisait les temps de calcul, mais il aurait aussi fallu aller au delà de la résolution de l’écran pour s’en affranchir. C’est cela qui m’a donné l’idée de teinter les facettes, de façon à estomper leurs arêtes, redonner une continuité visuelle à l’image. » Il fallait y penser.

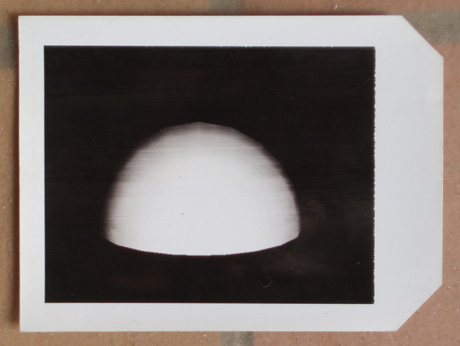

Premier Polaroïd qu’Henri Gouraud a montré à Ivan Sutherland.

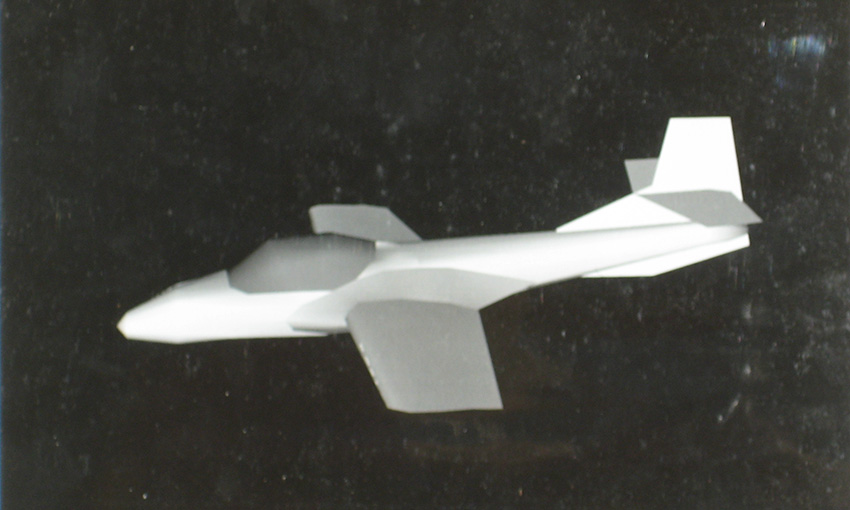

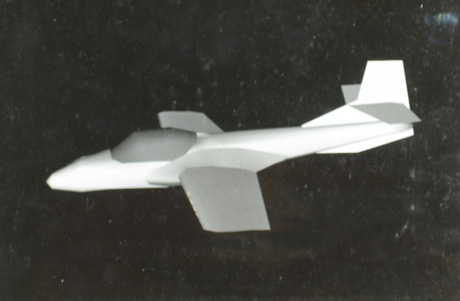

La suite est allée très vite : un rapide essai sur l’image d’une sphère avec le logiciel de Gary Watkins modifié pour prendre en compte cette nouvelle méthode d’ombrage. « On ne voyait plus les facettes, se rappelle Henri Gouraud. J’ai montré ce résultat à Ivan Sutherland, mais il m’a surtout conseillé de me remettre au travail… à la conception, manipulation d’objets… à la CAO plutôt qu’au rendu des images qui n’était effectivement pas le thème central de mon travail ! » Ce n’est qu’un mois ou deux plus tard qu’Ivan Sutherland revient vers lui, pour savoir si sa technique serait aussi adaptée à des objets complexes, comme une structure d’avion. « Pourquoi pas, lui répond-il : il suffit d’avoir sa géométrie, de la définir avec des facettes ! » Chose faite rapidement, sur une maquette d’avion, dont ils mesurent les coordonnées, les entrent dans l’ordinateur, et l’image s’affiche à l’écran…

Polaroïd de la maquette d’avion qui a convaincu Ivan Sutherland.

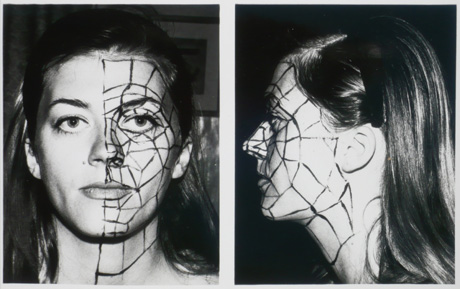

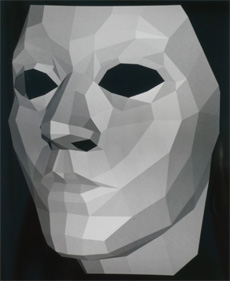

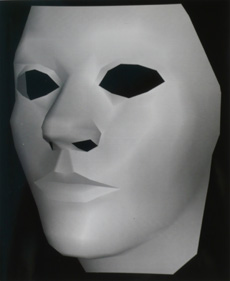

« C’est cette photo qui a été le déclic ! » se rappelle t-il. « Cela vaut un PhD, m’a dit Ivan Sutherland. Rédige cette idée, ce sera le sujet de ta thèse. » Un peu incrédule, compte-tenu de la simplicité technique et mathématique, Henri Gouraud couche son idée sur le papier. Une excellente idée, comme le confirmera la suite, justement parce qu’elle apporte une solution simple à un problème qui paraissait compliqué. D’ailleurs, pour explorer les limites de sa technique, Henri Gouraud n’a pas hésité à prendre son épouse comme modèle ! « Quoi de plus compliqué à reproduire qu’un visage ? » rétorque-t-il. Un soir, elle a donc accepté de servir la science : il lui a peint des lignes sur le visage au crayon noir, il a mesuré les sommets des polygones et entré le tout dans l’ordinateur. Les images du visage de Sylvie Gouraud, façonnées par l’ordinateur selon l’ombrage de son mari, ont ainsi été publiées dans de nombreuses revues et ont figuré en bonne place au Musée de l’informatique de Boston (Mountain View aujourd’hui).

|

|

| Visage de Sylvie Gouraud pendant le relevé de points. |

|

|

|

| Reconstruction des facettes à l’ordinateur, à gauche, puis lissage avec ombrage de Gouraud, à droite. | |

En quoi consiste exactement cette fameuse technique d’ombrage ? « C’est un lissage sur la surface de chaque facette, explique son auteur : mon algorithme calcule l’éclairement local de l’objet pour chaque sommet des facettes, et le répartit pixel par pixel sur la facette en l’interpolant entre chaque sommet. » Concrètement, on commence par interpoler les valeurs de l’éclairement sur les frontières des facettes à partir des éclairements calculés de façon exacte aux sommets. Puis on calcule les valeurs de l’éclairement en chaque pixel de la facette par interpolation des éclairements calculés sur ses frontières. Cet algorithme, contrairement aux solutions précédentes, utilise donc un calcul qui n’est pas uniquement basé sur la facette, mais prend en compte les facettes adjacentes en calculant une moyenne de leurs valeurs d’éclairement, ce qui rend les arêtes entre facettes voisines (presque) imperceptibles.

Pour la première fois, surtout, les chercheurs en synthèse d’image se libèrent de la géométrie pure de l’objet et effectuent sur l’image un travail créatif visant à en améliorer le réalisme. De nombreux thésards ont poursuivi dans cette voie, pendant plusieurs années. C’est d’ailleurs l’un d’entre eux, Bui Tuong Phong, un français d’origine vietnamienne qui venait de l’INRIA, qui a donné le nom d’« ombrage de Gouraud » à cette technique. « Je l’avais baptisé « smooth shading » autrement dit ombrage lisse par opposition à l’ombrage plat (flat shading) à base de facettes de teinte uniforme, précise Henri Gouraud. Bui Tuong Phong a publié sa thèse en 1973 sur une technique plus complexe, qui améliorait encore le rendu en traitant correctement l’effet produit par la réflexion des sources lumineuses. Pour la différencier de la mienne, il les a baptisées respectivement « ombrage de Gouraud (Gouraud shading) » et « ombrage de Phong (Phong shading) »… et c’est resté ! »

|

|

|

| Le même objet en ombrage plat (à gauche), de Gouraud (au centre), et de Phong (à droite). | ||

Le rendu n’a cessé d’être amélioré ensuite avec le bump mapping (pour donner l’illusion d’un relief granuleux), le texture mapping (pour donner un aspect de texture, peinture)…

On connaît aujourd’hui le succès des images de synthèse. Néanmoins, les utilisateurs actuels (cinéma, CAO, architecture…) ne s’en sont pas emparés d’emblée. « Il y avait un vrai décalage entre nos travaux d’informaticiens et ces utilisateurs, explique Henri Gouraud. Un concepteur de carrosserie comme Pierre Bézier, que je suis allé voir avec mes images, n’était absolument pas convaincu de l’intérêt des images à l’écran : il avait besoin de les transformer en une maquette réelle, voir le reflet de la lumière sur sa carrosserie. Et j’avoue qu’on était encore loin des rendus réalistes dont il avait effectivement besoin. » Idem en architecture : les architectes n’envisageaient pas de passer plusieurs jours à relever les coordonnées d’un futur bâtiment et les entrer dans l’ordinateur. Peu de clients étaient prêts à en payer le prix. Il a fallu attendre les premiers logiciels de dessin assisté par ordinateur, comme AutoCAD en 1982, qui ont rapidement imposé les modèles 3D et leur intérêt pour le métré des matériaux et les calculs de structures.

C’est en fait l’industrie aéronautique qui a pris les devants en matière de CAO. Là encore, la compétence des ingénieurs français en représentation mathématique des objets était reconnue. Le logiciel le plus réputé, Catia, développé dans les années 1970 par Avions Marcel Dassault pour ses propres besoins, est ensuite devenu le cœur de métier de Dassault Systèmes, filiale créée en 1981. Commercialisé par IBM, Catia est depuis 1984 le principal outil de CAO de Boeing. Plusieurs milliers d’entreprises l’utilisent dans le monde tant pour la conception mécanique que de systèmes électriques, le design ou la fabrication assistée par ordinateur (FAO). C’est une référence en aéronautique évidemment, mais aussi désormais en architecture – depuis 1995, Frank Gehry a conçu avec Catia la plupart de ses réalisations, comme le Musée Guggenheim de Bilbao – et dans l’industrie automobile où la voiture est totalement reconstituée en images de synthèse, chaque pièce pouvant être tournée, démontée, comme sur un prototype physique. Les ingénieurs peuvent vérifier la disposition des instruments de conduite, la visibilité, l’accès aux pièces mécaniques… On entre alors dans le monde de la réalité virtuelle. Là encore, Ivan Sutherland fut l’un des précurseurs : à la fin des années 1960, il a conçu le premier casque de visualisation asservi aux mouvements de la tête, l’« Ultimate Display ».

Avec quelques autres, c’est aussi lui qui a eu l’idée d’utiliser ces techniques pour le cinéma, au début des années 1980. Mais cela n’a pas abouti. Les premiers films qui comportaient quelques séquences d’animation en trois dimensions sont sortis en 1982 : d’abord « Vol de rêve » de Nadia et Daniel Thalmann, puis « Tron », une production de Walt Disney où une course de moto futuriste est réalisée à partir d’images de synthèse. Les français étaient très présents sur ce terrain et y apportaient une créativité artistique notoire. Les sociétés françaises « pionnières » de l’image de synthèse ont été Sogitec et TDI (Thomson Digital Image), qui développaient du matériel (simulateurs de vol et de conduite, essentiellement pour la défense) mais faisaient aussi un peu de production d’image, et surtout Ex Machina (issue de TDI) et Mac Guff Line (créée il y a un peu plus de 20 ans), spécialisées dans la production d’image.

Le premier film d’animation entièrement en images de synthèse viendra bien plus tard, en 1995, avec « Toy Story » des studios Pixar (cofondé par Ed Catmull, ancien étudiant de l’université de l’Utah). Ils ont développé un « moteur de rendu », baptisé RenderMan, considéré comme l’un des plus performants aujourd’hui. Depuis, les succès n’ont cessé, reléguant en quelques années les films d’animation traditionnelle des Studios Disney au stade d’antiquités : « Shrek » en 2001, « Le monde de Nemo » en 2003, « Ratatouille » en 2007…

C’est seulement à partir des années 1990 que les images de synthèse ont connu un développement fulgurant, notamment grâce à l’évolution du matériel, comme les cartes 3D de Silicon Graphics (dont le fondateur, Jim Clark est aussi un ancien étudiant de l’université de l’Utah) dédiées à des stations de travail haut de gamme. Suivront des cartes 3D pour ordinateur grand public et consoles de jeux vidéos, Nintendo et autres PlayStation dont on connaît le succès. Outre le cinéma et les jeux vidéos, les animations 3D ont aussi conquis le monde de la publicité, les génériques d’émissions, les simulateurs de vol… Elles sont aussi devenues indispensables en médecine, en recherche scientifique, météorologie…

« Aujourd’hui, les images calculées par ordinateur sont difficiles à distinguer des images réelles » se félicite Henri Gouraud. Et de se souvenir qu’il n’y a pas encore si longtemps, le nombre de polygones de Gouraud qu’un ordinateur était capable d’afficher par seconde était un argument de vente des fabricants de cartes graphiques.

Une chose est sûre : si l’ombrage de Gouraud est désormais cantonné à certains modes de fonctionnement spécifiques des applications, lorsque l’image doit être calculée très vite, en temps réel, sur un grand nombre de facettes, cette innovation figure dans tous les manuels d’images de synthèse et elle y restera assurément longtemps.

Newsletter

Le responsable de ce traitement est Inria. En saisissant votre adresse mail, vous consentez à recevoir chaque mois une sélection d'articles et à ce que vos données soient collectées et stockées comme décrit dans notre politique de confidentialité

Niveau de lecture

Aidez-nous à évaluer le niveau de lecture de ce document.

Votre choix a été pris en compte. Merci d'avoir estimé le niveau de ce document !