Mobilité, mouvement : le mouvement

Commençons par laisser parler le Littré, ce dictionnaire de référence de la langue française : Mouvement ? « Action par laquelle un corps ou quelqu’une de ses parties passe d’un lieu à un autre ». Cette action se déroule dans l’espace et le temps, elle concerne un objet dont le changement dans le temps consiste à se déplacer dans l’espace. Cet objet change de position, certes, mais sans se modifier. Car s’il variait tout en bougeant, il ne s’agirait plus de mouvement mais de déformation. Dualité du mouvement.

Ce qui est remarquable ici, c’est que ces mots, que nous utilisons pour le dire, correspondent exactement à ce que les mathématiques formalisent du mouvement : ce qui caractérise un mouvement, c’est… ce qui reste invariant. Cette idée-clé est le levier pour découvrir ce que les sciences informatiques et les mathématiques qui y sont liées nous enseignent à propos du mouvement.

Allons-y, expérimentons : attrapons la banane en plastique de notre petite sœur (en son absence) et lançons-la joyeusement en l’air avant de la rattraper. La voilà qui a fait un fort beau mouvement. De rotation : elle tourne sur elle-même. Et de translation : elle monte et descend dans les airs. Mais en restant intacte.

La banane, elle, a d’abord subi un mouvement rigide qui peut combiner translation (en X, Y et Z) et rotation (autour des axes X, Y, et Z), donc six degrés possibles de liberté. Mais elle ne s’est pas déformée, c’est-à-dire que sur elle, toutes les distances et tous les angles entre ses parties sont restés invariants. Pour un objet, c’est cela être rigide : au cours du déplacement, entre deux de ses points la distance ne varie jamais, et l’angle formé par deux droites séquentes (on parle de dièdre) ne varie pas non plus. Nous sommes devant l’exemple le plus simple de mouvement en lien avec son invariance : déplacement euclidien 3D, invariance rigide.

Si nous étions en 2D, par exemple à déplacer sur la table la photo d’une banane en plastique, le déplacement n’aurait eu que 3 degrés de liberté (2 de translation en X et Y, 1 seul degré de rotation) : vous pouvez faire le geste pour vous en convaincre, si besoin.

Si l’objet se rétrécit ou se déforme, ce n’est plus un mouvement, mais une autre transformation. On peut expliciter beaucoup de transformations apprises à l’école, récapitulées dans le tableau ci-dessous.

| Transformation 3D | Invariance | Illustration |

| Translation pure | Rigidité + Orientation de l’objet | Le carré reste un carré, sans tourner, mais bouge. |

| Rotation pure | Rigidité + Position du centre de gravité de l’objet | Le carré reste un carré, au même endroit, mais tourne. |

| Déplacement euclidien (translation + rotation) | Rigidité (préservation des distances et des angles sur l’objet) | Le carré reste un carré, de même taille, mais bouge et tourne. |

| Similitude (déplacement + dilation/contraction) | Préservation des angles et des rapports entre les distances avant et après le mouvement | Le carré reste un carré, mais de taille, position et orientation différente. |

| Isométrie (déplacement avec des symétries) | Préservation des distances | Le carré est déplacé et retourné. |

| Transformation affine | Préservation des rapports entre les angles et des rapports entre les distances | Le carré devient un parallélogramme. |

| Transformation projective | Préservation des alignements de droite | Le carré devient un quadrilatère quelconque. |

La similitude 3D, par exemple, permet en plus du déplacement de dilater ou rétrécir l’objet 3D (on parle d’homothétie) et un septième degré de liberté s’ajoute donc. Les distances ne sont plus les mêmes, mais sont toutes modifiées d’un même facteur de réduction ou de grossissement, comme à travers une loupe ou un « zoom ». Nous voyons qu’en ajoutant un degré de liberté, nous perdons une propriété d’invariance.

L’isométrie, elle, est une transformation moins évidente. Il s’agit de préserver toutes les distances, mais pas les angles. Mais dans ce cas, nous ne pouvons ajouter aux déplacements que des symétries (appelées aussi réflexions). En bref, « retourner » l’objet comme un vêtement que l’on mettrait à l’envers. Du coup, les angles se retrouvent aussi, au signe près. Le nouveau de degré de liberté n’est plus vraiment une valeur continue comme pour les translation, rotation, homothétie, mais un « choix » (on retourne ou non l’objet).

Un cran plus loin, pour comprendre ce qu’est une transformation affine, il faut prendre une caméra un peu bizarre, dont tous les rayons optiques sont parallèles, et regarder comment se transforme la projection de l’objet sur la rétine de la caméra : on observe que le mouvement rigide 3D engendre… une transformation affine 2D dans l’image, avec des variations de taille selon que l’objet s’éloigne ou se rapproche, des changement de forme selon que l’objet est de face ou de profil. Ce qui est remarquable, c’est que les rapports entre chaque couple de distances ou entre chaque couple d’angles restent invariants. C’est le fait que les rayons optiques restent parallèles qui permet cette invariance : derrière cette propriété est caché le théorème de Thalès.

Comprendre et modéliser le mouvement

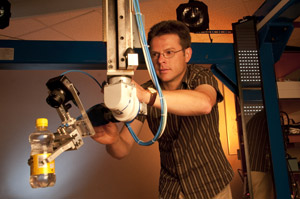

Expérimentation de vision robotique.

© INRIA / Photo Kaksonen

Quand il a été question de construire des robots, d’analyser des séquences d’images réelles par ordinateur, ou de mélanger images de synthèse et images réelles dans des films, les mathématiques se sont retrouvées en première ligne.

– Si nous voulons fabriquer un bras robotique qui puisse translater et orienter un objet : combien de degrés de liberté, Monsieur l’ingénieur ?

– Six, il lui faut au moins six articulations pour saisir et manipuler un objet sans être gauche (c’est-à-dire sans être empêché de faire certains mouvements). Regardez votre propre bras, avec ses trois degrés de liberté à l’épaule, celui du coude et les trois du poignet : il semble bien que Dame Nature ait eu quelques connaissances de géométrie, ou plus exactement, que les systèmes biologiques qui ont survécu sont bien ceux à qui le hasard de l’évolution a permis de développer un système avec assez de degrés de liberté.

– Essayons autre chose : garer une voiture. Mince alors ! Ce n’est pas si facile, il faut faire de drôles de manœuvres parfois ! Pourquoi est-ce si compliqué ?

– Eh bien, il nous manque un degré de liberté : notre voiture a besoin de trois degrés de liberté pour se déplacer à sa guise sur le sol : deux de position et un d’orientation, mais nous n’avons que la translation avant-arrière et l’orientation gauche-droite à notre disposition, avec l’impossibilité de faire directement glisser la voiture de droite à gauche. Il faut alors remplacer le degré de liberté manquant en générant une trajectoire compliquée pour « aller chercher » le déplacement gauche-droite en combinant d’autres mouvements. L’automatisation de ce procédé pour résoudre toutes les manœuvres (on parle de commande non holonome, pour dire qu’on ne peut résoudre localement le problème) est un problème mathématique qui n’a été résolu que récemment.

– Autre exemple encore, fixons une caméra sur notre robot. Le robot va-t-il percevoir les mouvements de la même façon que les humains avec leurs yeux ? Comment va-t-il reconnaître des objets ?

Changeons de domaine et allons regarder un œil animal ou humain : ça alors ?! L’œil est rond !!!! Oui, vous lisez bien tous ces points d’exclamation, car c’est complètement stupéfiant. Alors que, du poisson au primate, l’anatomie a vraiment changé du tout au tout, il y a un organe qui a gardé la même géométrie. Toujours, partout. C’est l’œil. Il est toujours rond, ou plus exactement sphérique. Pourquoi ? Pour faire des rotations sans translation. Et les physiologistes ont vérifié que les mouvements des yeux sont des rotations pures, à une précision inégalée par rapport à tous les autres mouvements biologiques. Une précision extraordinaire pour une raison extraordinairement précise.

La cause géométrique de ce fait singulier s’explique grâce aux mathématiques. Lors d’une translation, d’une image à l’autre, le mouvement de la projection rétinienne des objets dépend de la profondeur de ces objets, c’est à dire de leur distance à la caméra. Ainsi, les images des objets proches bougent beaucoup si on bouge la caméra, les images des objets lointains beaucoup moins, et les images des objets à l’horizon pas du tout. Voilà une propriété qui permet aussi aux systèmes robotiques de calculer les distances relatives des objets en mesurant le mouvement de leur image projetée. Mais du coup c’est bien compliqué. Il y a ce qu’on appelle de la parallaxe, des objets qui en occultent d’autres. Et il n’est pas possible d’analyser les mouvements des images sans tenir compte de la profondeur des objets, c’est à dire du 3D. Et faire des calculs 3D c’est sûrement bien compliqué pour un petit cerveau de poisson ou de grenouille.

Comment éviter cela ? En faisant des rotations, des rotations pures. Car dans ce cas, les différentes images correspondent à la vision du monde vu du même endroit. C’est la même scène visuelle, vue sous un angle différent. Les changements entre les images ne dépendent alors plus de la profondeur des objets, juste de l’angle de vue. Plus besoin alors d’analyser le 3D pour calculer ce qui se passe d’une vue à l’autre: toutes les opérations de traitement de l’information visuelle sont grandement simplifiées. Nous savons que c’est la raison pour laquelle si vous voulez relier entre elles des photos d’une même scène pour faire un beau panoramique d’un paysage, vous devez très minutieusement prendre ces photos du même endroit en les séparant par des rotations sans translation. Nous pensons que c’est la raison principale pour laquelle l’œil est rond.

Cette analyse du mouvement a aussi permis de mieux comprendre comment se forme la perception du mouvement dans le système nerveux. En commençant par le détecteur de mouvement le plus rudimentaire, qui est une soustraction d’images : on prend une image à un instant donné, puis une deuxième image juste après. Si rien n’a bougé, la différence entre les intensités de chaque pixel sera faible, sinon une différence notoire va apparaitre entre les deux images. Cette « tâche de mouvement » pourra être analysée plus en détail. Elle peut provenir d’un objet mobile : une proie ou un prédateur, dans tous les cas quelque chose qui mérite notre attention. Et si nous faisons une translation, nous venons de découvrir que les objets proches induisent un mouvement projeté plus important, nous voilà donc en train de détecter au niveau le plus rudimentaire du système visuel les plus proches parmi les proies et les prédateurs : utile, très utile.

Au-delà de cet exemple, nous voyons que les deux catégories de systèmes (« animaux » et « robots ») ont beaucoup de fonctionnalités similaires, car ils travaillent dans des environnements identiques. De ce fait, leur représentation interne de l’environnement et de ses propriétés géométriques ou cinématiques se base sur des hypothèses similaires. Ce sont donc les même formalismes qui sont utiles dans les deux cas, même si l’implémentation informatique est tellement différente de celle des tissus biologiques qu’il serait illusoire de vouloir « imiter » l’artificiel à partir du naturel ou « calquer » les mécanismes artificiels sur les processus biologiques pour les expliquer.

– Reformulons : comment va-t-il automatiquement (c’est-à-dire avec de l’intelligence mécanique, autrement dit en calculant sans véritablement penser) reconnaître des objets dans toutes les projections possibles sur la rétine de la caméra ? La réponse est tombée il y a à peine une dizaine d’années : en considérant les « bi-rapports » des points des objets. De quoi s’agit-il ? Selon sa position ou son orientation, la forme de l’objet dans l’image change fortement, mais… des mathématiques récentes nous enseignent que les « bi-rapports » (c’est-à-dire les rapports de rapports entre quatre distances ou quatre angles) restent invariants. Par conséquent, si nous connaissons plusieurs bi-rapports pour un objet, s’ils sont différents d’un objet à l’autre et que les points ne sont pas masqués, le calcul va produire un nombre spécifique à chaque objet, donc un indice pour le discriminer. Voilà une de ces propriétés d’invariance qui bouleverse, vers la fin du 20e siècle, le traitement des images numériques. Puisqu’elles permettent notamment de reconnaître nos visages, ou les marques de nos iris, etc.

– Et le rapport avec les effets spéciaux des films dont nous parlions ?

– Le voici : il s’agissait d’insérer très précisément des personnages réels au sein d’un univers 3D complètement virtuel, ou plutôt de fabriquer les images correspondant aux projections 2D à la fois des personnages réels et du monde imaginaire. La génération des images de tels films nécessite des calculs colossaux, rendus possibles par l’utilisation des propriétés évoquées ici. C’est une société issue de travaux de recherche de l’INRIA qui a conçu plusieurs des logiciels ayant permis de grandement automatiser ces calculs.

L’acquérir, le mesurer ?

Équipement pour système virtuel : lunettes et capteurs de mouvements

© INRIA / Photo C. Lebedinsky

Pour mesurer un mouvement, on peut utiliser divers dispositifs, soit à base de pastilles réfléchissantes et de caméras, soit à base de capteurs de position installés sur l’objet ou la personne. Les jeux vidéo sont très consommateurs de ces techniques (on parle de Motion capture en anglais) pour reproduire de façon très fidèle les mouvements humains. Par exemple, des séquences d’un vrai joueur sont insérées dans une simulation sportive (comme Ronaldinho pour FIFA 2010 ou Tiger Woods pour PGA Tour 11). Le principe est très simple : le dispositif mesure plusieurs fois par seconde la position de cibles placées très précisément sur l’athlète quand il évolue. Ces points sont stockés, puis réutilisés pour animer le squelette du joueur virtuel en fonction des séquences nécessaires au déroulement du jeu. On assiste à une augmentation du nombre de cibles mesurées. Alors qu’ils se limitaient initialement aux articulations (cou, hanches, genoux, chevilles, coudes, poignets), les dispositifs mesurent maintenant jusqu’aux expressions des visages, de façon à rendre plus réalistes les images de synthèse des joueurs. Cette augmentation pose une fois de plus la problématique très classique en informatique : comment établir le meilleur compromis entre beaucoup d’informations qui offrent plus de précision et moins d’informations qui nécessitent moins de temps de calcul ?

Ces techniques s’appliquent dans beaucoup d’autres domaines que le jeu. Par exemple, les fabricants automobiles étudient le mouvement d’un conducteur à l’intérieur d’une voiture, afin de lui proposer des aménagements mieux adaptés. Au cinéma, comme dans Avatar, les mouvements d’acteurs humains servent à animer des créatures de fiction.

Les caméras vidéo ou les capteurs de position ne sont pas les seuls dispositifs technologiques servant à saisir un mouvement : citons également les accéléromètres et les capteurs GPS parfois regroupés dans des systèmes composites appelés centrales inertielles. On en trouve par exemple dans des manettes de jeu comme la Wii. Pensons également aux interfaces tactiles, popularisées par l’iPhone, où des gestes des doigts permettent de piloter les logiciels disponibles. Plus globalement, ces dernières années ont vu apparaître un nombre considérable d’interfaces homme-machine basées sur la capture de gestes. Et cette évolution est loin d’être terminée.

L’analyser ?

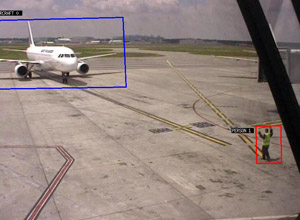

Interprétation automatique d’images vidéo.

Le système doit permettre de repérer des dysfonctionnements dans les procédures.

© INRIA / Projet ORION

Les applications évoquées jusqu’ici se bornaient à utiliser un geste mesuré. Intéressons-nous à présent à des contextes où l’analyse du mouvement est nécessaire pour mieux le comprendre et en extraire des informations pertinentes.

Prenons l’exemple de la surveillance vidéo, où des opérateurs humains surveillent des écrans diffusant des images issues de caméras. Ce type de dispositif est très utilisé dans des magasins pour limiter les vols ou bien dans des zones publiques (stades de football, métro, aéroports…) pour surveiller d’éventuels incidents. Le nombre de caméras en très forte progression ces dernières années a conduit à développer des dispositifs automatiques ou semi-automatiques. Ils sont aujourd’hui capables de détecter un visage humain dans un environnement complexe et de piloter les mouvements de la caméra pour le « suivre ».

Enregistrement et analyse des mouvements d’un gardien de but de handball, face à un joueur 3D.

© INRIA / Photo C. Lebedinsky

De plus en plus d’entraîneurs sportifs font appel à l’analyse de mouvement pour mieux analyser les gestes des sportifs dans le but de les optimiser. Seront ainsi mesurées des informations comme des amplitudes, des angles de flexion, des vitesses… Des thérapeutes commencent à utiliser exactement le même principe pour apprendre ou réapprendre à des patients handicapés ou blessés des gestes de la vie quotidienne.

Peut-être ces analyses de geste utiliseront-elles des méthodes comme celles développées dans le projet Grimage à Grenoble. Il s’agit d’un système analysant les images issues de caméras filmant un personnage (non équipé de cibles) pour construire – en temps réel ! – son modèle 3D. Il est ensuite possible de transmettre ce modèle sur un site distant, de l’incruster dans une scène virtuelle…

Enfin, comment ne pas évoquer une des révolutions que le grand public ne va pas tarder à vivre : l’apparition massive du relief dans les images (souvent qualifiées à tort de 3D) du cinéma et de la télévision ? De nombreux verrous scientifiques et technologiques restent encore à lever, certains d’entre eux étant directement liés à une bonne analyse du mouvement dans ces images.

Le reproduire ?

Certaines applications nécessitent de reproduire un mouvement. C’est le cas notamment dans les jeux vidéo où, avant l’utilisation intensive de la Motion capture, les mouvements étaient synthétisés à l’aide de lois inspirées de la bio-mécanique avec comme principal défi, la production d’un déplacement en un temps suffisamment court pour que le joueur ne détecte pas ce calcul.

Ces techniques débordent du cadre des jeux, par exemple pour reproduire et/ou simuler des mouvements de foule, que ce soit dans des contextes d’évacuation d’un stade en cas d’urgence, de fluidification du trafic dans une gare ou encore d’effets spéciaux pour le cinéma.

La réalité virtuelle, elle aussi, est consommatrice de mouvements synthétiques : quand il s’agit par exemple d’immerger un élève dans une séquence d’apprentissage, il est parfois nécessaire d’insérer sa représentation parmi celles d’autres personnages. On parle alors d’humain virtuel.

Conclusion : d’autres formes de mouvement

Ce petit voyage au sein de l’étude du mouvement s’achève bientôt. Évoquons brièvement d’autres formes de mouvement, que nous ne développerons pas ici.

La robotique fournit un autre cadre où les chercheurs recréent un mouvement, par exemple pour les robots humanoïdes qui se déplacent.

À côté de la mesure et de l’analyse de mouvement, d’autres recherches sont entreprises pour calculer, prédire ou simuler le mouvement, pour déterminer des trajectoires de véhicules, se protéger de trajectoires de projectiles, ou encore pour calculer des prévisions météo, notamment à partir de mouvements de phénomènes climatologiques (nuages, dépressions, tornades…).

Citons également d’autres façons de formaliser les phénomènes en mouvement. Les travaux sur le mouvement des fluides et des milieux continus s’appliquent quand il faut simuler pour modéliser, par exemple, pour des modèles aéronautiques, des prédictions météo, etc. L’étude des systèmes dynamiques intervient quand on peut qualifier avant de quantifier. Un exemple en est l’équation de Lotka-Volterra, appliquée aux problèmes proies-prédateurs.

Retrouvez en complément, sur le site fuscia.info, des éléments bibliographiques.

Newsletter

Le responsable de ce traitement est Inria. En saisissant votre adresse mail, vous consentez à recevoir chaque mois une sélection d'articles et à ce que vos données soient collectées et stockées comme décrit dans notre politique de confidentialité

Niveau de lecture

Aidez-nous à évaluer le niveau de lecture de ce document.

Votre choix a été pris en compte. Merci d'avoir estimé le niveau de ce document !