Qui créera le premier ordinateur intelligent ?

Un ordinateur, c’est pratique ! On peut jouer, communiquer, faire des calculs gigantesques ou chercher un mot dans une encyclopédie. Mais si on leur demande quelque chose de différemment intelligent, comme de raconter une blague, on sera souvent déçu. Les robots intelligents n’existent que dans les films ! Mais comment définir l’intelligence ? Est-il possible de la comprendre et de la « mettre en boîte » ? Pour y répondre, on peut s’adresser directement à notre cerveau. Pouvons-nous formaliser les mécanismes de la pensée et ensuite les copier afin de créer une machine qui soit dotée d’intelligence ?

Et pourtant… ils pensent !

C’est bien le cerveau, centre du système nerveux, qui est le siège de l’intelligence chez les animaux vertébrés. C’est le système le plus complexe à étudier et notre connaissance de son fonctionnement est très récente. À l’époque de l’invention de la machine à vapeur, on pensait que le cerveau était « fluide », donnant ainsi les mots « humeur » et « humour ». Santiago Ramón y Cajal, un précurseur, a pu montrer au début du siècle dernier que notre système nerveux central n’est pas un milieu continu. On a plutôt affaire à un grand nombre de cellules spécialisées, les neurones, entourés de cellules nourricières, les cellules gliales. La science de l’intelligence, ou neurosciences, était née !

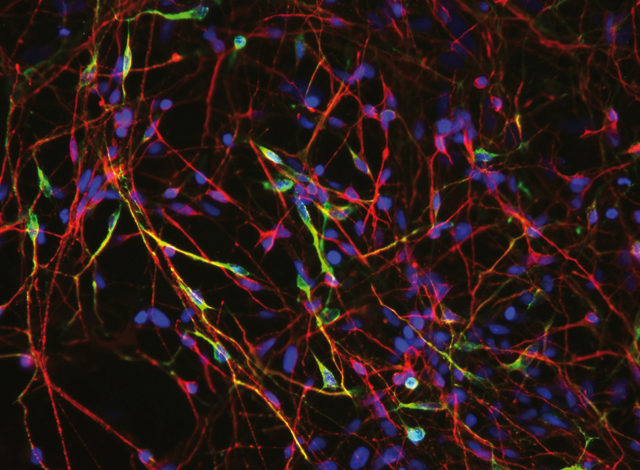

Image de neurones (© Xianmin Zeng au Buck Institute for Age Research).

Les neurones, ici visualisés en microscopie de fluorescence, ne fonctionnent pas comme un ordinateur. Le réseau qu’ils forment est dépourvu d’horloge centrale.

Cette image de neurones, cultivés à partir de cellules souches d’embryons humains, est obtenue par microscopie à fluorescence. Ils apparaissent comme des noyaux avec des terminaisons arborées, permettant de « connecter » les neurones entre eux et de former des réseaux. À la différence d’un ordinateur classique, le système nerveux central est constitué d’un grand nombre de processeurs (les neurones) mais est dépourvu d’horloge centrale. Son langage est radicalement différent car les neurones communiquent principalement entre eux par de brèves impulsions.

Personne ne « programme » le cerveau comme un calculateur classique ! L’ensemble du système évolue de façon auto organisée, en modifiant les paramètres de son activité, dont la morphologie des neurones, leur connectivité ou en changeant des concentrations hormonales. Un « programme neural » s’inscrit dans tous ces paramètres et fait émerger des propriétés, permettant au système d’effectuer des calculs complexes, comme lire une revue.

Chez l’homme, on compte environ 100 milliards neurones. Ils sont organisés en un réseau complexe connectant chaque cellule à environ dix mille autres ! À chaque connexion correspondent des molécules définies par des centaines d’éléments. Ce sont donc à un potentiel de plus de 1011 x 104 x 103 = 1018 éléments d’informations (soit cent mille disques durs d’un tera‑octet !) que correspond l’architecture de notre cerveau à chaque instant.

Cette organisation est immature chez le bébé. Même si les grandes structures anatomiques sont déjà en place, les connexions entre neurones sont largement aléatoires. C’est par la maturation du nouveau-né, et par son interaction avec le monde, que cette organisation va se mettre en place. Petit à petit, les neurones, « bêtes » cellules microscopiques, vont se connecter et s’associer. Dans les aires visuelles, par exemple, des neurones vont développer une préférence pour certaines classes de signaux comme les lignes. Les neurones peuvent alors s’organiser à plus grande échelle en populations de neurones. Les différentes parties du cerveau vont progressivement se spécialiser chez le jeune adulte jusqu’à produire des fonctions cognitives efficaces, comme la vision ou la motricité. Mais comment ce résultat émerge‑t-il d’un simple réseau de neurones ? Quelle « magie » fait que les neurones puissent se parler ? Par quel « miracle » peuvent-ils apprendre ? Au lieu de parler de magie ou de miracle, essayons de comprendre quels mécanismes se cachent derrière nos neurones.

Comment décrypter le langage des neurones ?

En grande majorité, les neurones communiquent par de brèves impulsions électrochimiques, les potentiels d’action, de formes très similaires entre neurones dans le cerveau mais aussi au sein du vivant. On parle de potentiel d’action pour ces signaux car des impulsions permettent de libérer des substances chimiques à l’interface entre deux neurones, la synapse, et de propager de l’information d’un neurone à l’autre. L’information est donc essentiellement transmise à travers de brèves impulsions. Ce qui compte ici ce sont les instants où ces événements sont émis. Le cerveau ne code pas son information sous forme de valeur, mais de manière temporelle (le moment où l’impulsion est émise) et de manière spatiale (l’endroit qui a émis cette information). Si on écoute le signal émis par un neurone en l’amplifiant dans un haut-parleur, on entend en moyenne une impulsion par seconde. On peut reconnaître dans ce brouhaha soit des rythmes, soit un bruit aléatoire, similaire à la pluie, soit des sons toniques (« bang ! ») ou encore des bouffées (« brrr…. brrr… »). Mais comment interpréter cette information comme une donnée utile ?

En effet, ce niveau de description ne permet pas de comprendre l’image globale représentée dans l’activité neurale. Des progrès récents en imagerie permettent de mieux capturer l’essence de ce langage. Il n’est pas comme une langue humaine, un assemblage organisé par une grammaire de mots attachés à des symboles. Le code neural, en effet, possède un seul mot, le potentiel d’action. Mais, pour chaque neurone, cet événement peut venir d’un grand nombre de voisins. L’architecture est parallèle. De plus, la réponse du neurone est dépendante de la séquence avec laquelle ces impulsions convergent sur ses synapses, bien que ces calculs élémentaires soient effectués sans horloge centrale. La dynamique est asynchrone. Enfin, les neurones par leurs multiples interactions forment un réseau compact et ne peuvent être considérés seuls, mais dans le contexte du réseau auxquels ils sont connectés. Le code est distribué. Dans ce cadre, le code neural n’est pas un langage comme celui des ordinateurs mais plutôt le résultat de la superposition d’un très grand nombre de processus parallèles. On parle alors de système dynamique.

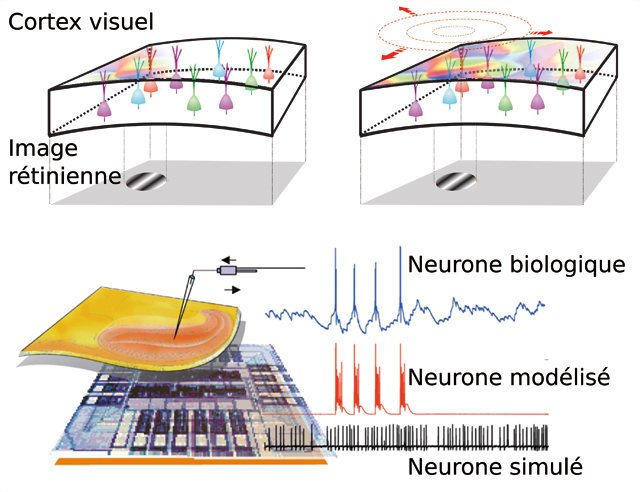

Le code neural (En haut : © F. Chavane, en bas : © T. Bal).

Le code neural est mieux compris grâce aux techniques d’imagerie récentes. Les neurosciences computationnelles permettent d’étudier les propriétés des réseaux de neurones.

En haut. Les techniques récentes d’imagerie permettent de mieux comprendre certaines caractéristiques du code neural. Ici une image de l’activité cérébrale dans une partie du cerveau chargée du traitement de l’information visuelle : le cortex visuel primaire. Les figures représentent une zone de quelques cm2 et au-dessous la partie correspondante de notre espace visuel. Les couleurs correspondent aux différentes réponses des neurones quand un point unique est placé devant la rétine. La figure de droite représente après quelques millisecondes, l’ensemble de l’activité neurale. L’activité, d’abord locale, se propage dans la population, grâce au réseau de connexions entre les neurones. Ce qui est remarquable, c’est qu’à chaque zone correspond un traitement bien identifié. (Figure modifiée depuis des données de F. Chavane à l’INCM/CNRS.)

En bas. Les neurosciences computationnelles étudient la capacité de calcul de tels réseaux de neurones et leur capacité à traiter l’information. Ce système hybride étudie des neurones biologiques, en les faisant interagir avec des neurones simulés sur ordinateur et dans le futur avec des neurones construits sur des puces dédiées. (Figure par Thierry Bal, modifié de G. Le Masson, S. Renaud-Le Masson, D. Debay and T. Bal (2002). Feedback inhibition controls spike transfer in hybrid thalamic circuits. Nature, 417 : 854-858.)

L’activité neurale, en s’appuyant sur une très forte connectivité, porte l’information en la propageant à travers le cerveau. On peut ainsi imaginer comment l’information visuelle, pour un mot imprimé sur une feuille de papier, va être codée sur notre rétine, pour ensuite rebondir dans le cortex visuel primaire, puis suivre des chemins parallèles pour déclencher la compréhension de ce mot, et simultanément bouger le regard pour aller fixer le mot suivant. La somme du travail effectué par chaque neurone pris individuellement semble pourtant dérisoire face à ce résultat ! Une clé existe permettant de comprendre globalement comment ces capacités émergent : l’étude de l’apprentissage au sein du cerveau.

Apprentissage : un lien entre le tout et la somme des parties

Dans un cerveau immature, le « langage » parlé par les neurones est partiellement embrouillé par la superposition aléatoire de tous les messages neuronaux. Comme l’a suggéré le neuropsychologue canadien Donald Hebb, la maturation du cerveau est obtenue par la consolidation et l’affinement progressifs des connexions synaptiques. Ainsi, des neurones voisins émettant des potentiels d’action en même temps auront tendance à s’associer en renforçant la force de leur connexion synaptique. À l’inverse, les neurones ayant des activités sans corrélation verront leurs connexions s’estomper, renforçant ainsi la cohérence de l’ensemble. Cette double règle fondamentale est la trace d’un mécanisme neural inné d’auto organisation, créant alors des populations de neurones qui elles-mêmes peuvent servir à des représentations mentales plus complexes.

Bruno Olshausen, un neuroscientifique américain, a montré, en étudiant des modèles de réseaux de neurones, c’est-à-dire des simulations de neurones biologiques sur ordinateur, comment reproduire des connexions entre neurones comme celles observées dans le cortex visuel primaire mature après auto‑organisation. La règle utilisée correspondait à connecter les neurones de manière à ce qu’ils soient le plus efficace possible. Pour définir cette efficacité, il a considéré que le flux d’information à qualité égale devrait être le plus économique c’est-à-dire avec le minimum d’impulsions. Nos neurones travaillent donc de manière à transmettre l’information qu’ils traitent de façon parcimonieuse. Ce résultat a été minutieusement quantifié et relié aux concepts les plus avancés de la physique théorique. Ils ont eu de nombreuses implications, comme permettre de comprendre concrètement comment évolue la connectivité en termes de règles fonctionnelles simples.

Qui construira le calculateur neural intelligent ?

Malgré ces belles avancées, nous sommes encore au Moyen‑Âge dans notre compréhension du cerveau et de l’intelligence biologique. Si on connaît relativement bien le comportement d’un neurone et de l’ensemble des parties constituant sa cellule, ce survol montre aussi qu’on ne maîtrise pas les possibilités offertes par les combinaisons de connexion de 10 milliards de neurones. Ce que nous pensons être l’intelligence mécanique, en revanche, a été bien formalisé par Alan Turing. Ses travaux ont permis de formaliser la notion d’algorithme, et la thèse de Church-Turing explique comment tous les calculs possibles avec des nombres et des symboles peuvent se décomposer en un nombre fini d’étapes élémentaires sur une « machine universelle ».

Ces travaux permettent de construire théoriquement cette machine comme une machine binaire séquentielle (la « machine de Turing »), équivalente à tous les ordinateurs du monde. L’information y est stockée de manière statique, et le calcul s’y fait de manière centralisée et synchrone. En théorie, un cerveau est un objet matériel, donc aussi une machine au sens donné par Turing. Mais en pratique, la comparaison est vaine, puisque nous avons vu que tout s’y fait de manière asynchrone et distribuée, et que l’information est dynamique et codée par des événements. De plus, le cerveau est avant tout un mécanisme en complète interaction avec son environnement, qui perçoit et agit.

Un système « sensori-moteur » dont l’apprentissage s’est fait au cours des millions d’années d’évolution. Rien n’a jamais été programmé, mais s’est simplement adapté ou a disparu au cours de myriades d’essais-erreurs.

À l’image d’Alan Turing et de sa machine computationnelle universelle, peut-on créer une Machine de Turing Neurale ? Depuis plus de 30 ans, des équipes de recherche incluant des biologistes, des spécialistes de physique statistique et des informaticiens étudient le comportement des mécanismes du cerveau, les neurosciences computationnelles. Elles utilisent les systèmes dynamiques non linéaires pour étudier les modèles décrivant ce que nous comprenons des aspects calculatoires de l’activité neurale.

Nous disposons de différentes approches pour découvrir les mécanismes de calcul cachés dans notre cerveau. Les biologistes vont tester la réaction comportementale ou enregistrer l’activité du cerveau dans différents protocoles expérimentaux. Les informaticiens et les mathématiciens vont imaginer des théories et des modèles qui, simulés sur des calculateurs classiques, vont pouvoir être comparés avec les résultats biologiques. Enfin, les électroniciens vont implanter ces modèles sur des puces « neuromimétiques » et vérifier expérimentalement que les modèles produisent les bonnes prédictions. Une nouvelle méthode est de mélanger ces chercheurs de plusieurs disciplines autour de la même question : peut-on créer des circuits hybrides intelligents (voir panneau inférieur de la figure intitulée Le code neural). En créant des machines intégrant des aspects du « in-vivo » au « in-silico » en passant par le « in-computo », on invente de nouvelles façons de penser aux calculateurs du futur.

Est-ce qu’un jour, quelqu’un inventera ce calculateur neural intelligent ? Qui sait… Mais le XXIe siècle sera, après l’exploration de l’incommensurablement grand et petit, le siècle de l’exploration de l’incommensurablement complexe.

- Encyclopédie historique des neurosciences : Du neurone à l’émergence de la pensée de François Clarac, Jean‑Pierre Ternaux et Dominique Wolton,

- John von Neumann, Le cerveau et l’ordinateur, Flammarion, coll. « Champs », 1996,

- Simulation de l’apprentissage SparseNET de Bruno Olshausen.

Cet article est paru dans la revue DocSciences n°13 Informatique et médecine, éditée par le CRDP de l’Académie de Versailles en partenariat avec l’INRIA.

Newsletter

Le responsable de ce traitement est Inria. En saisissant votre adresse mail, vous consentez à recevoir chaque mois une sélection d'articles et à ce que vos données soient collectées et stockées comme décrit dans notre politique de confidentialité

Niveau de lecture

Aidez-nous à évaluer le niveau de lecture de ce document.

Votre choix a été pris en compte. Merci d'avoir estimé le niveau de ce document !

Laurent Perrinet