Prévision : une approche scientifique

La prévision est l’action de prédire. En se référant au Petit Larousse Illustré, édition 2010, on arrive à cette définition :

« Prédire : annoncer ce qui doit se produire soit par intuition, soit par divination, soit par des règles certaines, soit par conjecture ou par raisonnement. »

Parmi les synonymes, on peut trouver : anticipation, calcul, conjecture, divination, prédiction, prescience, pressentiment, prévoyance, prophétie, pronostic.

Dans le cadre d’une approche scientifique de la prévision, on se limitera bien entendu aux approches fondées sur des règles ou des raisonnements, et à quelques synonymes : calcul, prédiction, pronostic.

Cette définition montre clairement que la prévision s’intéresse au futur. En d’autres termes, la prévision consiste à estimer ce qui va se passer après un instant t, à partir de connaissances et à partir d’observations antérieures à cet instant t. Ainsi, en médecine, le diagnostic, qui consiste à associer à des symptômes, observés à l’instant t, la pathologie à ce même instant, ne relève pas de la prévision. Au contraire, le pronostic, qui consiste, à partir des mêmes informations, à prévoir l’évolution future de la pathologie et du patient, relève de la prévision.

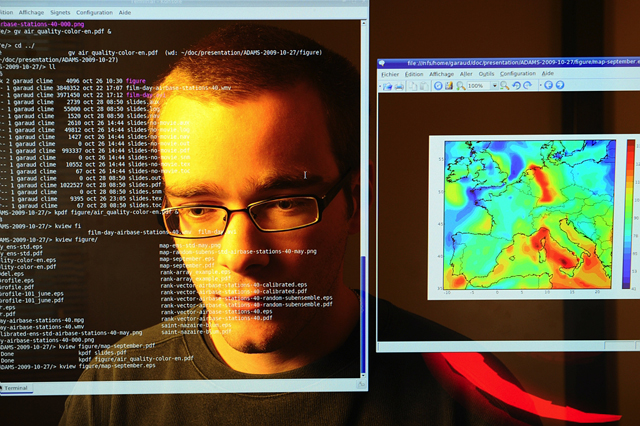

Prévision de la qualité de l’air, plus précisément de l’ozone au niveau du sol. © Inria / Photo Kaksonen.

Les applications sont très nombreuses et, pour certaines, ont envahi notre quotidien : prévisions météorologiques ou plus largement de phénomènes géophysiques, prédictions boursières, prédiction de la parole, prédiction de la position et de la vitesse d’un objet, pronostic médical, contrôle de qualité, etc.

D’un point de vue méthodologique, la prévision s’appuiera sur un modèle qui résume de façon aussi précise que possible les connaissances du système, et les relations entre les observations (mesures) et ce que l’on veut prévoir.

Mais, un modèle est par nature simplifié et par conséquent raisonnablement juste (ou faux !) ; de plus, les mesures sont toujours entachées d’erreurs.

Par exemple, les prévisions astronomiques – positions des astres, dates des éclipses – s’appuient sur les lois de la mécanique céleste (modèle théorique) et des observations (données expérimentales). Si on considère les lois de la mécanique classique, le modèle sous-jacent fournit de bonnes prévisions tant que les objets ne se déplacent pas trop vite, ou qu’ils n’approchent pas trop près de masses importantes. Dans de telles situations, le modèle classique devient franchement faux, et pour obtenir des prévisions correctes, il faut bien sûr considérer un modèle plus fin qui s’appuie sur la mécanique relativiste. Ainsi, une prévision scientifique doit être accompagnée du modèle qu’elle utilise.

À l’opposé, la divination, la pensée magique… souvent formulée de façon très ésotérique et vague (comme les prévisions astrologiques qui prétendent prédire l’avenir d’une personne à partir de sa date de naissance et quelques autres données) ne s’appuient sur aucun modèle raisonnable ! Un tel modèle devrait être explicite, formel et surtout révisable, ou réfutable. Or les modèles qui soutiennent les différentes pratiques astrologiques, par exemple, peuvent être formels et explicites, voire en partie calculables, mais ils ne font pas l’objet de confrontation et de révision.

Du modèle physique au modèle fonctionnel

Dans le domaine des Sciences et Technologies de l’Information, les chercheurs se sont penchés sur les problèmes de prévision depuis de nombreuses années.

En fait, de façon très générale, la physique expérimentale essaie d’établir des lois mathématiques qui permettent de prédire le comportement d’un objet. Par exemple, les lois de Newton permettent de prédire la trajectoire d’un objet si l’on connaît les forces qui s’y appliquent, sa position et sa vitesse initiale : la théorie permet de prédire les mesures futures. C’est aussi pour expliquer des phénomènes dont l’observation s’écarte de façon trop importante des prévisions de la théorie de Newton, qu’Einstein a développé la théorie de la relativité. La modélisation physique est donc une forme élaborée de prévision.

Mais, dans de nombreux domaines, les phénomènes physiques sont très complexes, si complexes qu’on ne sait pas d’une façon simple modéliser mathématiquement ces phénomènes. Lorsque la modélisation mathématique n’est plus possible, ou lorsque le modèle mathématique ne peut pas être résolu analytiquement, que peut-on faire ?

Une première approche, liée aux progrès du calcul numérique, repose sur la simulation. Ainsi, dans le domaine de la prévision météorologique, les phénomènes mis en jeu, qui sont nombreux et complexes (par exemple, les turbulences), sont simulés. En effet, le modèle est un système d’équations aux dérivées partielles, couplées et souvent non linéaires, que l’on ne peut pas résoudre analytiquement. La simulation permet alors de prédire en s’appuyant sur les équations de ce modèle qui contiennent les lois physiques. Une tendance actuelle est d’exploiter conjointement les mesures et le modèle dans des approches que l’on appelle « assimilation de données ».

Les équations aux dérivées partielles (EDP) sont des équations fonctionnelles, dont les solutions sont des fonctions de plusieurs variables réelles.

La solution d’une équation algébrique est un ou plusieurs nombres. Ainsi les équations de la forme ax2 + bx + c = 0, qui implique le fameux trinôme étudié au lycée, possèdent, selon les valeurs des coefficients a, b et c, aucune, une ou deux solutions, c’est-à-dire des valeurs de x qui annulent le trinôme.

Une équation différentielle ordinaire (ODE) lie une fonction inconnue à ses dérivées. Ses solutions sont des fonctions d’une variable réelle. Par exemple, l’équation élémentaire f’(x) = a.f(x) admet comme solution la fonction f(x) = f(0) eax, puisqu’alors f’(x) = f(0) a eax, bien identique à a.f(x). Quand la variable x est le temps, les ODE décrivent des systèmes dynamiques, qui tentent de rendre compte de l’évolution de grandeurs au cours du temps, telles qu’une distance parcourue par un mobile, la tension aux bornes d’un circuit ou l’effectif d’une population.

Lorsque les grandeurs étudiées dépendent, outre le temps, de la position sur un axe, sur un plan ou dans l’espace, les fonctions impliquées possèdent autant de variables additionnelles. Ainsi, l’évolution de la température dans le temps et le long d’une tige métallique peut être modélisée par une fonction T (x, t), où x est la distance à l’extrémité de la tige et t est le temps écoulé depuis le début de l’expérience. Pour modéliser les phénomènes associés, il est nécessaire d’écrire des équations qui lient la fonction T (x, t) et ses dérivées par rapport à la variable t, mais aussi par rapport à la variable x : autant de dérivées dites partielles. La résolution numérique de ces équations sur un ordinateur permet de simuler l’évolution de la température en chaque point de la tige et au cours du temps.

Si les phénomènes évoluent dans un plan ou dans l’espace, ce sont de nouvelles variables y, puis z qu’il est ainsi nécessaire d’introduire, ainsi que les dérivées correspondantes dans les équations aux dérivées partielles. Ainsi, les prédictions météorologiques mettent en œuvre des modèles qui rassemblent des équations de la mécanique des fluides et permettent de simuler l’évolution dans le temps de grandeurs physiques telles que vitesse ou pression, et ce, à chaque point d’une grille tridimensionnelle au-dessus de la surface terrestre.

À côté de leur mise en œuvre pour la modélisation et la simulation de nombreux phénomènes, les EDP constituent un chapitre important des mathématiques pures.

La simulation est donc intimement liée à la modélisation ; mais elle implique un portage des équations du modèle sur ordinateur. Si le modèle mathématique est intrinsèquement à temps discret et numérique, le portage est simple, car la simulation reproduit fidèlement le modèle de façon naturelle ; si le modèle mathématique est continu, le portage est plus délicat : la simulation, qui implique une numérisation et une discrétisation des équations (des variables concernant l’espace, le temps, etc.) , c’est-à-dire des approximations, exige tout le savoir-faire du spécialiste pour fournir des résultats précis, accompagnés si possible de l’estimation des erreurs de calcul.

Une seconde approche, développée dans les années 60 dans le domaine de l’intelligence artificielle, consiste à modéliser le raisonnement d’un expert sous forme de règles. Le résultat est un programme appelé système-expert, qui a été utilisé par exemple pour aider les médecins dans le diagnostic médical (ici, diagnostic est pris ici au sens large : il inclut le pronostic, qui seul nous intéresse dans le contexte de la prévision).

Dans le cas du diagnostic médical, les experts ne sont pas toujours d’accord ou pas complètement fiables, ou certains symptômes peuvent conduire à plusieurs diagnostics. De plus, certaines données (symptômes) sont parfois manquantes ou incertaines. Ceci est également vrai dans bien d’autres domaines. Il est donc très difficile d’élaborer les règles qui seront utilisées dans le système-expert. Le raisonnement doit alors tenir compte de l’incertitude de ces règles et des données. Une façon de faire est de considérer des raisonnements à base de logique floue. Quelle que soit la mise en œuvre, la solution est d’accompagner la prédiction de l’ensemble des faits (observations) et des règles employées pour inférer le diagnostic, c’est-à-dire du modèle (très complexe) du raisonnement de l’expert médical.

Une troisième approche est de considérer un modèle mathématique fonctionnel du phénomène. Par modèle fonctionnel, on entend un modèle « boîte noire » qui ne cherche pas à mettre en équation les lois physiques, mais simplement à prédire les observations. Cette approche est intéressante lorsque la physique du phénomène est trop complexe pour en écrire les équations.

Par exemple, un signal de parole, très complexe, entre dans cette catégorie : il est impossible d’écrire toutes les équations qui aboutissent à la production d’un signal de parole, mais on peut modéliser ce signal par un modèle linéaire très simple, que l’on appelle prédiction linéaire. La prédiction linéaire consiste à considérer que l’échantillon à venir est une combinaison linéaire de N échantillons précédents (avec des coefficients de pondération à estimer). Ce modèle, au principe très simple, qui ne repose pas sur des équations physiques, s’appuie simplement sur le fait que les échantillons successifs d’un signal de parole ont une certaine dépendance. Et il donne de bons résultats, il est d’ailleurs à la base des systèmes de compression de parole.

Dans le cas de systèmes plus complexes, qui sont manifestement non linéaires, le modèle linéaire ne suffit plus et l’on fait appel à des méthodes plus sophistiquées, comme les réseaux de neurones formels ou les machines à vecteurs support. Initialement, ces méthodes cherchaient à mimer les capacités d’apprentissage des êtres vivants, et en particulier des humains. Elles entrent dans le domaine scientifique que l’on appelle communément « Machine learning ».

En résumé

En résumé, dans le domaine scientifique, une prédiction s’appuie sur un modèle et sur des observations. Pour être valide, une prédiction doit donc être accompagnée du modèle qui la sous-tend. Ce modèle doit être accessible et discutable, afin d’être éventuellement affiné pour améliorer la prédiction. Les erreurs de prédiction, c’est-à-dire les écarts entre les prédictions du modèle et les observations expérimentales, jouent un rôle fondamental pour les tâches de validation et d’amélioration du modèle. La validation est donc une étape très importante, mais aussi très difficile. En effet, la confrontation des prédictions du modèle et des mesures est très délicate, puisque le modèle est par nature simplifié et les mesures par nature bruitées ! Les erreurs sont-elles dues à la simplicité du modèle ou au bruit des données ? Il n’est pas toujours simple de conclure.

Pour finir, quelques mots-clés en anglais pour étendre vos recherches : modelisation, expert systems, forecasting, prediction, linear prediction, neural networks, support vector machine, machine learning.

Vous souhaitez approfondir un sujet ? Poser une question à un spécialiste ?

Rendez-vous sur pixees.fr !

Newsletter

Le responsable de ce traitement est Inria. En saisissant votre adresse mail, vous consentez à recevoir chaque mois une sélection d'articles et à ce que vos données soient collectées et stockées comme décrit dans notre politique de confidentialité

Niveau de lecture

Aidez-nous à évaluer le niveau de lecture de ce document.

Votre choix a été pris en compte. Merci d'avoir estimé le niveau de ce document !

Christian Jutten